sed & awk

Дейл Догерти & Арнольд Роббинс

1997

перевод В.Айсин

Мириам, за твои любовь и терпение

--Арнольд Роббинс

Предисловие

Эта книга посвящена набору утилит UNIX со странными названиями, sed и awk. У этих утилит много общего, включая использование регулярных выражений для сопоставления с образцом. Так как сопоставление паттернов является важной частью их использования, эта книга объясняет синтаксис регулярных выражений UNIX очень подробно. Поскольку обучение от grep до sed и awk происходит естественным образом, мы рассмотрим все три программы, хотя основное внимание уделим sed и awk.

Sed и awk — это инструменты, используемые пользователями, программистами и системными администраторами — всеми, кто работает с текстовыми файлами. Sed, названный так потому, что это потоковый редактор, идеально подходит для применения серии правок к нескольким файлам. Awk, названный в честь разработчиков Ахо, Вайнбергера и Кернигана, является языком программирования, который позволяет легко манипулировать структурированными данными и создавать форматированные отчеты. В этой книге особое внимание уделяется определению awk в POSIX. Кроме того, в книге кратко описывается оригинальная версия awk, прежде чем обсуждать три свободно доступные версии awk и две коммерческие, все они реализуют POSIX awk.

Основное внимание в этой книге уделяется написанию сценариев для sed и awk, которые быстро решают ряд проблем пользователя. Многие из этих сценариев можно назвать «быстрыми исправлениями» (quick-fixes). Кроме того, мы рассмотрим сценарии, которые решают более крупные проблемы, требующие более тщательного проектирования и разработки.

Структура книги

Глава 1, Инструменты для редактирования, представляет собой обзор функций и возможностей sed и awk.

Глава 2, Понимание основных операций, демонстрирует основные операции sed и awk, показывая прогресс в функциональности от sed до awk. Обе программы имеют схожий синтаксис командной строки, принимая инструкции пользователя в виде скрипта.

Глава 3, Понимание синтаксиса регулярных выражений, подробно описывается синтаксис регулярных выражений UNIX. Новых пользователей часто пугают эти странные выражения, используемые для сопоставления шаблонов. Важно овладеть синтаксисом регулярных выражений, чтобы получить максимальную отдачу от sed и awk. Примеры сопоставления шаблонов в этой главе по большей части основаны на grep и egrep.

Глава 4, Написание сценариев sed, начинает раздел из трех глав, посвященный sed. В этой главе рассматриваются основные элементы написания сценария sed с использованием всего нескольких команд sed. Также представлен сценарий оболочки, который упрощает вызов сценариев sed.

Глава 5, Основные команды sed и Глава 6. Расширенные команды sed, разделяют набор команд sed на базовые и расширенные команды. Основные команды — это команды, которые параллельно редактируют вручную, а расширенные команды предоставляют простые возможности программирования. Среди расширенных команд есть те, которые управляют буфером хранения (hold space) — выделенным временным буфером.

Глава 7, Написание скриптов для awk, начинает раздел, состоящий из пяти глав, посвященных awk. В этой главе представлены основные особенности этого языка сценариев. Объясняется ряд сценариев, в том числе тот, который изменяет вывод команды ls.

Глава 8, Условные выражения, циклы и массивы, описывает, как использовать общие конструкции программирования, такие, как условные выражения, циклы и массивы.

Глава 9, Функции, описывает, как использовать встроенные функции awk, а также как писать пользовательские функции.

Глава 10, Нижний ящик, охватывает множество различных тем, связанных с awk. Описывает, как выполнять команды UNIX из сценария awk и способы прямого вывода в файлы и каналы. Также предлагает некоторые (скудные) советы по отладке сценариев awk.

Глава 11, Семейство awk, описывает исходную версию awk V7, текущую версию Bell Labs awk, GNU awk (gawk) от Фонда свободного программного обеспечения и mawk Майкла Бреннана. Последние три распространяются с открытым исходным кодом. В этой главе также описаны две коммерческие реализации, MKS awk и Thomson Automation awk (tawk), а также VSAwk, который привносит awk-подобные возможности в среду Visual Basic.

Глава 12, Полнофункциональные приложения, представляет два более длинных и более сложных сценария awk, которые вместе демонстрируют практически все возможности языка. Первый скрипт — это интерактивная проверка орфографии, второй сценарий обрабатывает и форматирует указатель книги или главный указатель набора книг.

Глава 13, Сборник сценариев, представлен ряд сценариев, добавленных пользователями, которые показывают разные стили и приемы написания скриптов для sed и awk.

Приложение A, Краткий справочник по sed, представляет собой краткий справочник, описывающий команды sed и параметры командной строки.

Приложение B, Краткий справочник по awk, представляет собой краткое руководство по параметрам командной строки awk и полное описание его скриптового языка.

Приложение C, Дополнение к Главе 12, представлены полные листинги скриптов spellcheck.awk и masterindex, описанные в главе 12.

Доступность sed и awk

Sed и awk были частью UNIX версии 7 (также известной как «V7» и «Seventh Edition») и с тех пор являются частью стандартного дистрибутива. Sed остается неизменным с тех пор, как был представлен.

Версия sed проекта Free Software Foundation GNU находится в свободном доступе, хотя технически и не является общественным достоянием. Исходный код GNU sed доступен через анонимный FTP[1] ftp.gnu.org/pub/gnu/sed/. Это tar-файл, сжатый с помощью программы gzip, исходный код которой доступен в том же каталоге. Есть много сайтов по всему миру, которые «зеркалируют» файлы с основного сайта дистрибутива GNU; если вы знаете один из них рядом с вами, вы должны получить файлы оттуда. Обязательно используйте режим «binary» или «image» для передачи файла(ов).

В 1985 году авторы awk расширили язык, добавив множество полезных функций. К сожалению, эта новая версия оставалась внутри AT&T в течение нескольких лет. Она стала частью UNIX System V начиная с версии 3.1. Ее можно найти под именем nawk, для нового awk; более старая версия все еще существует под своим первоначальным именем. Это все еще имеет место в системах System V Release 4.

В коммерческих системах UNIX, таких как Hewlett-Packard, Sun, IBM, Digital и других, ситуация именования более сложная. Все эти системы имеют некоторую версию как старого, так и нового awk, но то, как каждый поставщик называет каждую программу, варьируется. Некоторые называют oawk и awk, некоторые awk и nawk. Лучший совет, который мы можем дать, — это проверить вашу локальную документацию[2]. В этой книге мы используем термин awk для описания POSIX awk. Конкретные реализации будут называться по имени, например «gawk» или «The Bell Labs awk». В Главе 11 обсуждаются три свободно доступных awk (включая то, где их взять), а также несколько коммерческих.

NOTE: Начиная с первого издания этой книги, язык awk был стандартизирован как часть командного языка и служебных программ POSIX (P1003.2). Все современные реализации awk направлены на то, чтобы быть полностью совместимыми со стандартом POSIX.

Стандарт включает в себя функции, появившиеся как в новых awk, так и в gawk. В этой книге вы можете предположить, что то, что верно для одной реализации POSIX awk, также верно и для другой, если не указана конкретная версия.

-

Если у вас нет доступа в Интернет и вы хотите получить копию GNU sed, свяжитесь с FreeSoftware Foundation, Inc., 59 Temple Place, Suite 330, Boston, MA 02111-1307, США. Номер телефона: 1-617-5425942, номер факса: 1-617-542-2652.

-

Пуристы называют новый awk просто

awk; новый должен был заменить оригинальный. Увы, спустя почти 10 лет после его выхода этого так и не произошло.

Версии для DOS

Gawk, mawk и GNU sed были перенесены в DOS. На основном сайте дистрибутива GNU есть файлы с указателями на версии этих программ для DOS. Кроме того, gawk был перенесен на OS/2, VMS и микрокомпьютеры Atari и Amiga с переносом на другие системы (Macintosh, Windows).

egrep, sed и awk доступны для компьютеров под управлением MS-DOS как часть MKS Toolkit (MorticeKern Systems, Inc., Онтарио, Канада). Их реализация awk поддерживает функции POSIX awk.

MKS Toolkit также включает оболочку Korn, что означает, что многие сценарии оболочки, написанные для оболочки Bourne в системах UNIX можно запустить на ПК. Хотя большинство пользователей MKS Toolkit, вероятно,уже открыли эти инструменты в UNIX, мы надеемся, что преимущества этих программ будут очевидны для пользователей ПК, которые не рискнули использовать UNIX.

Thompson Automation Software[3] имеет компилятор awk для UNIX, DOS и Microsoft Windows. Эта версия интересна тем, что она имеет ряд расширений языка и включает отладчик awk, написанный на awk!

Мы иногда использовали ПК, потому что Ventura Publisher — это потрясающий пакет форматирования. Одна из причин, по которой он нам нравится, заключается в том, что мы можем продолжать использовать vi для создания и редактирования текстовых файлов и использовать sed для написания сценариев редактирования. Мы использовали sed для написания программ преобразования, которые переводят макросы troff в теги таблиц стилей Ventura. Мы также использовали его для вставки тегов в пакетном режиме. Это может избавить вас от необходимости вручную помечать повторяющиеся элементы в файле.

Sed и awk также полезны для написания программ преобразования, которые работают с различными форматами файлов.

-

5616 SW Jefferson, Portland, OR 97221 USA, 1-800-944-0139 в США, 1-503-224-1639 в других странах.

Другие источники информации о sed и awk

Долгое время основным источником информации об этих утилитах были две статьи, содержащиеся в томе 2 UNIX Programmer's Guide. Статья awk — A Pattern Scanning and Processing Language (1 сентября 1978 г.) была написана тремя авторами языка. На 10 страницах предлагается краткое руководство и обсуждение несколько вопросов проектирования и реализации. Статья SED — A Non-Interactive Text Editor (15 августа 1978 г.) была написана Ли Э. МакМахоном. Это справочник, дающий полное описание каждой функции и включает несколько полезных примеров (с использованием Coleridge Xanadu в качестве входных данных).

В отраслевых книгах наиболее значимая трактовка sed и awk содержится в The UNIX Programming Environment Брайана В. Кернигана и Роба Пайка (Прентис-Холл, 1984). Глава «Filters» не только объясняет, как работают эти программы, но и показывает, как они могут работать вместе для создания полезных приложений.

Авторы awk совместно работали над книгой, описывающей расширенную версию: The AWK Programming Language (Аддисон-Уэсли, 1988). Она содержит множество полных примеров и демонстрирует широкий спектр областей, в которых можно применить awk. Она следует стилю UNIX Programming Environment, что иногда делает ее слишком насыщенной для некоторых читателей, которые являются новыми пользователями. Исходный код примеров программ в книге можно найти в по адресу netlib.belllabs.com/netlib/research/awkbookcode.

IEEE Standard for Information and Technology Portable Operating System Interface (POSIX) Part 2: Shell and Utilities (Standard 1003.2-1992)[4] описывает как sed, так и awk[5]. Это «официальное» слово о функциях, доступных для переносимых программ оболочки, использующих sed и awk. Поскольку awk сам по себе является языком программирования, POSIX также является официальным словом для портативных программ awk.

В 1996 году Фонд свободного программного обеспечения опубликовал The GNU Awk User's Guide Арнольда Роббинса. Это документация для gawk, написанная в более учебном стиле, чем книга Aho, Kernighan и Weinberger. Она состоит из двух полных глав с примерами и охватывает POSIX awk. Эта книга также издается SSC под заголовком Effective AWK Programming, а исходный код Texinfo для книги поставляется с дистрибутивом gawk.

Одним из текущих недостатков GNU sed является отсутствие собственной документации, даже страницы руководства.

Большинство общих введений в UNIX представляют sed и awk в длинном параде утилит. Из подобных книг книга Генри МакГилтона и Рэйчел Морган Introducing the UNIX System предлагает наилучшее рассмотрение основных навыков редактирования, включая использование всех текстовых редакторов UNIX.

UNIX Text Processing (Hayden Books, 1987), написанная автором этого справочника и Тимом О'Рейли, полностью охватывает sed и awk, хотя мы не включили новую версию awk. Читатели этой книги обнаружат, что некоторые части дублируются в этой книге, но в целом здесь был использован другой подход. В то время как в учебнике мы рассматриваем sed и awk отдельно, ожидая, что только продвинутые пользователи будут заниматься awk, здесь мы пытаемся представить обе программы по отношению друг к другу. Это разные инструменты, которые можно использовать индивидуально или вместе, чтобы получить интересные возможности для обработки текста.

Наконец, в 1995 году появилась группа новостей Usenet comp.lang.awk. Если вы не можете найти то, что вам нужно, чтобы узнать в одной из вышеперечисленных книг, вы можете задать вопрос в группе новостей, с большой вероятностью кто-нибудь сможет вам помочь.

В группе новостей также есть статья «Часто задаваемые вопросы» (FAQ), которая публикуется регулярно. Кроме ответов на вопросы об awk, в FAQ перечислено множество сайтов, где вы можете получить бинарные файлы различных версий awk для разных систем. Вы можете получить FAQ через FTP в файле rtfm.mit.edu/pub/usenetby-hierarchy/.

-

Уф! Скажи это в три раза быстрее!

-

Стандарт не доступен в интернете. Его можно заказать в IEEE по телефону 1-800-678-IEEE (4333) в США и Канаде, 1-908-981-0060 в других странах. Или, см. http://www.ieee.org/ из веб-браузера. Стоимость составляет 228 долларов США, включая стандарт 1003.2 d-1994-поправка 1 для пакетных сред. Члены и/или сообщества IEEE получают скидку.

Примеры программ

Примеры программ в этой книге изначально были написаны и протестированы на Mac и выполнены на A/UX 2.0 (UNIX System V Release 2) и SparcStation под управлением SunOS 4.0. Программы, требующие POSIX awk, были повторно протестированы с использованием gawk 3.0.0, а также версии Bell Labs awk от августа 1994 года с FTP-сайта Bell Labs (подробности FTP см. в главе 11). Программы Sed были повторно протестированы с SunOS 4.1.3.sed и GNU sed 2.05.

Получение примеров исходного кода

NOTE: Перечисленные ниже способы получения исходного кода книги слегка устарели. Проще и удобней получить исходный код на странице книги на сайте издательства: https://www.oreilly.com/library/view/sed-awk/1565922255/, или здесь: progs.tar.gz. (Прим. пер.)

Исходный код программ, представленных в этой книге, вы можете получить у компании O'Reilly & Associates через их интернет-сервер. Примеры программ в этой книге доступны в электронном виде несколькими способами: по FTP, Ftpmail, BITFTP и UUCP. Самые дешевые, быстрые и простые способы перечислены в первую очередь. Если Вы читаете сверху вниз, то первое, что работает для вас, вероятно, лучше всего. Используйте FTP, если вы находитесь непосредственно в Интернете. Используйте Ftpmail, если вы не находитесь в интернете, но можете отправлять и получать электронную почту на интернет-сайты (это включает пользователей CompuServe). Используйте BITFTP, если вы можете отправлять электронную почту через BITNET. Используйте UUCP, если ничего из вышеперечисленного не работает.

FTP

Для использования FTP вам понадобится машина с прямым доступом в Интернет. Показан образец сеанса, то что следует набрать, показано жирным шрифтом.

$ ftp ftp.oreilly.com

Connected to ftp.oreilly.com.

220 FTP server (Version 6.21 Tue Mar 10 22:09:55 EST 1992) ready.

Name (ftp.oreilly.com:yourname): anonymous

331 Guest login ok, send domain style e-mail address as password.

Password: yourname@domain.name

(Use your user name and host here)

230 Guest login ok, access restrictions apply.

ftp> cd /published/oreilly/nutshell/sedawk_2

250 CWD command successful.

ftp> binary (Очень важно! Вы должны указать двоичную передачу для сжатых файлов.)

200 Type set to I.

ftp> get progs.tar.gz

200 PORT command successful.

150 Opening BINARY mode data connection for progs.tar.gz.

226 Transfer complete.

ftp> quit

221 Goodbye.

Файл представляет собой сжатый gzip архив tar; извлеките файлы из архива, набрав:

$ gzcat progs.tar.gz | tar xvf -Для систем System V требуется следующая команда tar:

$ gzcat progs.tar.gz | tar xof -Если gzcat недоступен в вашей системе, используйте отдельные команды gunzip и tar.

$ gunzip progs.tar.gz

$ tar xvf progs.tar

Ftpmail

Ftpmail — это почтовый сервер, доступный любому, кто может отправлять электронную почту и получать ее с интернет-сайтов. Это относится к любой компании или поставщику услуг, которые разрешают подключение электронной почты к интернету. Вот как вы это делаете. Вы отправляете почту по адресу ftpmail@online.oreilly.com в теле сообщения укажите команды FTP, которые вы хотите запустить. Сервер запустит для вас анонимный FTP и отправит файлы вам. Чтобы получить полный файл справки, отправьте сообщение без темы и с одним словом «help» в теле. Ниже приведен образец почтового сеанса, который должен предоставить вам примеры. Эта команда отправляет вам список файлов в выбранном каталоге и запрошенные примеры файлов. Этот список полезен, если есть более поздняя версия примеров, которые вас интересуют.

$ mail ftpmail@online.oreilly.com

Subject:

reply-to yourname@domain.name (Куда вы хотите отправить файлы по почте.)

open

cd /published/oreilly/nutshell/sedawk_2

dir

mode binary

uuencode

get progs.tar.gz

quit

.

Подпись в конце сообщения допустима, если она стоит после «quit».

BITFTP

BITFTP — это почтовый сервер для пользователей BITNET. Вы отправляете ему сообщения электронной почты с запросом файлов, и он отправляет вам файлы по электронной почте. BITFTP в настоящее время обслуживает только пользователей, которые отправляют ему почту c узлов, которые находятся непосредственно в BITNET, EARN или NetNorth. Чтобы использовать BITFTP, отправьте письмо с вашими командами ftp для BITFTP@PUCC. Чтобы получить полный файл справки, отправьте HELP в теле сообщения. Ниже приведено тело сообщения, отправляемого в BITFTP:

FTP ftp.oreilly.com NETDATA

USER anonymous

PASS yourname@yourhost.edu (Укажите здесь свой адрес электронной почты в Интернете (не свой адрес BITNET))

CD /published/oreilly/nutshell/sedawk_2

DIR

BINARY

GET progs.tar.gz

QUIT

Как только вы получите нужный файл, следуйте инструкциям в разделе FTP, чтобы извлечь файлы из архива. Поскольку вы, вероятно, не находитесь в системе UNIX, вам может потребоваться получить версии uudeb, gunzip, atob и tar для вашей системы. Доступны версии VMS, DOS и Mac.

UUCP

UUCP является стандартным практически для всех UNIX-систем и доступен для пользователей IBM-совместимых ПК и Apple Macintosh. Примеры доступны UUCP через модем от UUNET; за время соединения UUNET взимается плата. Если у вас или вашей компании есть учетная запись в UUNET, у вас есть система где-то с прямым соединением UUCP с UUNET, найдите эту систему и введите:

uucp uunet\!~/published/oreilly/nutshell/sedawk_2/progs.tar.gz yourhost\!~/yourname/Обратные слэши могут быть опущены, если вы используете оболочку в стиле Борна (sh, ksh, bash, zsh, pdksh) вместо csh. Файл должен появиться некоторое время спустя (до суток и более) в каталоге /usr/spool/uucppublic/yourname. Если у вас нет учетной записи, но вы хотели бы получить ее по электронной почте, свяжитесь с UUNET по телефону 703-206-5400. Это хорошая идея — получить файл /published/oreilly/ls-lR.Z как короткий тестовый файл, содержащий имена и размеры всех доступных файлов. Как только вы получите желаемый файл, следуйте инструкциям в разделе FTP, чтобы извлечь файлы из архива.

Условные обозначения, используемые в этом справочнике

В этой книге используются следующие условные обозначения:

- Bold

- используется для операторов и функций, идентификаторов и имен программ.

- Italic

- используется для имен файлов и каталогов, когда они появляются в теле абзаца, а также для типов данных и подчеркивания новых терминов и концепций при их введении.

Constant Width- используется в примерах для отображения содержимого файлов или вывода команд.

Constant Bold- используется в примерах для отображения командных строк и параметров, которые пользователь должен вводить буквально. (Например,

rm fooозначает ввестиrm fooв точности так, как оно отображается в тексте или примере.) - ""

- используются для обозначения фрагмента кода в пояснительном тексте. Системные сообщения и символы также оборачиваются в кавычки.

- $

- это приглашение оболочки Bourne или оболочки Korn UNIX.

- [ ]

- окружают необязательные элементы в описании синтаксиса программы. (Сами скобки набирать не нужно, если не указано иное.)

- ...

- обозначает текст (обычно компьютерный вывод), опущенный для ясности или для экономии места.

- □

- обозначает литеральный пробел. Этот символ используется, чтобы сделать пробелы видимыми в примерах, а также в тексте.

- •

- обозначает литеральный символ TAB. Этот символ используется для отображения табуляции в примерах, а также в тексте.

Обозначение CTRL-X или ^X указывает на использование управляющих символов. Это значит зажать клавишу «control» при вводе символа «x». Аналогичным образом мы обозначаем другие клавиши (например, RETURN указывает возврат каретки). За всеми примерами командных строк следует RETURN, если не указано иное.

О втором издании

С тех пор как эта книга была впервые опубликована в 1990 году, она стала одной из самых фундаментальных книг O'Reilly & Associates Nutshell Handbooks. После написания произошли три важных события. Первым была публикация стандарта POSIX для sed и, что более важно, для awk. Вторым (возможно, из-за первого) было повсеместное распространение той или иной версии нового awk на всех современных UNIX системах, как коммерческих, так и свободно доступных UNIX-подобных системах, таких как NetBSD, FreeBSD и Linux. Третьим — доступность исходного кода GNU sed и трех версий awk вместо только gawk.

По этим и другим причинам компания O'Reilly & Associates решила, что это руководство необходимо обновить. Цели исправления заключались в том, чтобы сохранить неповторимый вкус книги («если не сломано — не чините»), переориентировать awk-часть книги на awk POSIX, исправить ошибки и обновить книгу.

Я хотел бы поблагодарить Джиджи Эстабрук, Криса Рейли и Ленни Мюллнера из O'Reilly & Associates за их помощь, Марка Воклера, французского переводчика первого издания, за многие полезные комментарии и Джона Дзуберу за его комментарии к первому изданию. Майкл Бреннан, Генри Спенсер и Озан Йигит выступили в качестве технических рецензентов этого издания, и я хотел бы их поблагодарить за их вклад. Озан Йигит, в частности, заслуживает дополнительной благодарности за то, что заставил меня быть очень строгим в моем тестировании. Пэт Томпсон из Thompson Automation Software любезно предоставила ознакомительную копию tawk для просмотра в этой книге. Ричард Монтгомери из Videosoft предоставил мне информацию о VSAwk.

Следующие люди предоставили скрипты к Главе 13: Джон Л. Бентли, Том Кристиансен, Джефф Клэр, Роджер А. Корнелиус, Рахул Деси, Ник Холлоуэй, Норман Джозеф, Уэс Морган, Том Ван Раалте и Мартин Вайцель. Мы с благодарностью отмечаем их вклад.

Спасибо также сотрудникам O'Reilly & Associates. Николь Гипсон Ариго была редактором и менеджером проекта. Дэвид Сьюэлл был редактором, а Клэрмари Фишер О'Лири вычитала книгу. Джейн Эллин и Шерил Авруч выполнили проверки качества. Сет Мэйслин написал указатель. Эрик Рэй, Эллен Сивер и Ленни Мюлльнер работали с инструментами для создания книги. Крис Рейли настроил цифры. Нэнси Прист и Мэри Джейн Уолш разработали внутреннюю компоновку книги, а Эди Фридман разработала переднюю обложку.

Мои родственники, Маршалл и Элейн Хартхольц из Сиэтла, заслуживают особой благодарности за то, что взяли наших детей в поход на неделю, позволив мне добиться значительного прогресса на важном этапе обновления. ☺

Наконец, я хотел бы поблагодарить мою замечательную жену Мириам за терпение во время этого проекта.

Арнольд Роббинс

Благодарности из первого издания

Не будет преувеличением сказать, что эту книгу давно ждали. Я опубликовал три статьи по awk в UNIX/World весной и летом 1987 г., ошибочно утверждая, что эти статьи из готовящегося к выпуску Nutshell Handbook, Sed & Awk. Я предложил Тиму О'Рейли адаптировать статьи и создать книгу как проект, над которым я мог бы работать дома вскоре после рождения моего сына Бенджамина. Я думал доделаю за несколько месяцев. Что ж, моему сыну исполнилось три года, когда я заканчивал первый черновик. Кэти Бреннан и представители службы поддержки клиентов терпеливо обрабатывали запросы на книгу с тех пор, как появились статьи UNIX/World. Кэти сказала, что ей даже звонили и заказывали книгу, клянясь, что она доступна, потому что они знали людей, которые ее читали. Я в долгу перед ней и ее сотрудниками, а также перед читателями, которых я ждал.

Я благодарю Тима О'Рейли за создание отличной компании, в которой можно легко отвлечься на ряд интересных проектов. Как редактор он подтолкнул меня к завершению книги, но не позволил, чтобы она была завершена без ее написания целиком. Как обычно, его предложения заставили меня поработать над улучшением книги. Спасибо всем авторам и производственным редакторам o'Reilly & Associates, которые представили интересные проблемы для решения с помощью sed и awk. Спасибо Элли Катлер, которая была редактором по производству книги и также написала индекс. Спасибо Ленни Мюллнеру за то, что он позволил мне цитировать его на протяжении всей книги. Спасибо также Сью Уиллинг и Донне Вунтейлер за их усилия по выпуску книги в печать. Спасибо Крису Рейли, который сделал иллюстрации. Спасибо отдельным авторам скриптов sed и awk в Главе 13. Спасибо также Кевину К. Кастнеру, Тиму Ирвину, Марку Шальцу, Алексу Хьюмезу, Гленну Сайто, Джеффу Хейгелу, Тони Херсону, Джерри Пику, Майку Тиллеру и Ленни Мюллнеру, которые присылали мне письма с указанием опечаток и ошибок.

Наконец, огромное спасибо Нэнси и Кэти, Бену и Гленде.

Дейл Догерти

Комментарии и вопросы

Мы проверили и проверили информацию в этой книге в меру наших возможностей, но вы можете обнаружить, что функции изменились (или даже что мы допустили ошибки!). Пожалуйста, сообщите нам о любых обнаруженных вами ошибках, а также о ваших предложениях по будущим изданиям, написав по адресу:

O'Reilly & Associates, Inc.

101 Morris Street

Sebastopol, CA 95472

1-800-998-9938 (in the U.S. or Canada)

1-707-829-0515 (international or local)

1-707-829-0104 (FAX)

Вы можете отправлять нам сообщения в электронном виде. Чтобы попасть в список рассылки или запросить каталог, отправьте электронное письмо по адресу:

info@oreilly.com

Чтобы задать технические вопросы или прокомментировать книгу, отправьте электронное письмо по адресу:

bookquestions@oreilly.com

У нас есть веб-сайт для этой книги, где мы перечислим примеры, исправления и любые планы на будущие издания. Вы можете получить доступ к этой странице по адресу:

http://www.oreilly.com/catalog/sed2/

Для получения дополнительной информации об этой и других книгах посетите вебсайт O'Reilly:

http://www.oreilly.com

Глава 1

Мощные инструменты для редактирования

Моя жена не позволяет мне купить электропилу. Она боится несчастного случая, если я ею воспользуюсь. Поэтому я полагаюсь на ручную пилу для различных проектов выходного дня, таких как сооружения полок. Однако если бы я зарабатывал себе на жизнь плотничеством, мне пришлось бы пользоваться электропилой. Скорость и эффективность, обеспечиваемые электроинструментами, были бы необходимы для того, чтобы быть продуктивным. [Д.Д.]

Для людей, которые создают и изменяют текстовые файлы, sed и awk — это мощные инструменты для редактирования. Большинство вещей, которые вы можете сделать с помощью этих программ, можно сделать в интерактивном режиме с помощью текстового редактора. Однако использование sed и awk может сэкономить много часов повторяющейся работы для достижения одного и того же результата.

Sed и awk своеобразны, и для их изучения требуется время, но возможности, которые они предоставляют, могут окупить обучение во много раз, особенно если редактирование текста является обычной частью вашей профессии.

1.1 Вы сможете решать интересные проблемы

Основной мотивацией для изучения sed и awk является то, что они полезны для разработки общих решений при редактировании текста[1]. Для некоторых людей, включая меня, удовлетворение от решения проблемы — это разница между работой и тяжелой работой. Учитывая выбор использования vi или sed для выполнения серии повторных правок в нескольких файлах, я выберу sed просто потому, что это делает проблему более интересной для меня. Я уточняю решение вместо того, чтобы повторять серию нажатий клавиш. Кроме того, как только я выполню свою задачу, я поздравляю себя с тем, что я умный. Я чувствую себя так, словно немного поколдовал и избавил себя от скучного труда.

Поначалу использование sed и awk будет казаться долгим путем для выполнения задачи. После нескольких попыток вы можете прийти к выводу, что эту задачу было бы проще выполнить вручную. Будьте терпеливы. Вам нужно не только научиться использовать sed и awk, но и научиться распознавать ситуации, когда их использование окупается. По мере приобретения опыта, вы будете решать проблемы быстрее и решать более широкий круг проблем.

Вы также начнете видеть возможности для поиска общих решений конкретных проблем. Существует способ взглянуть на проблему так, чтобы вы увидели, что она связана с классом проблем. Затем вы можете разработать решение, которое может быть повторно использовано в других ситуациях.

Позвольте мне привести вам пример (не показывая никакого программного кода). В одной из наших книг использовалась схема перекрестных ссылок, в которой ссылка была определена и обработана нашим программным обеспечением форматирования (sqtroff). В текстовом файле ссылка на главу про обработку ошибок может быть закодирована следующим образом:

\*[CHerrorhand]CHerrorhand — это имя, дающее ссылку, а \*[ и ] — вызывающие последовательности, которые разграничивают ссылки от другого текста. В центральном файле имена, используемые для перекрестных ссылок в документе, определяются как строки sqtroff. Например, CHerrorhand определяется как Глава 16, Ошибка обращения. (Преимущество использования символической схемы перекрестных ссылок, подобной этой, вместо явных ссылок заключается в том, что если главы добавляются, удаляются или переупорядочиваются, то редактировать нужно только центральный файл, чтобы отразить новую организацию.) Когда программное обеспечение форматирования обрабатывает документ, ссылки правильно разрешаются и расширяются.

Проблема, с которой мы столкнулись, заключалась в том, что нам пришлось использовать одни и те же файлы для создания онлайн-версии книги. Поскольку наше программное обеспечение форматирования sqtroff не будет использоваться, нам нужен был какой-то способ расширить перекрестные ссылки в файлах. Другими словами, мы не хотели, чтобы файлы содержали \*[CHerrorhand]; вместо этого нам нужно было получить то, что подразумевалось под CHerrorhand.

Было три возможных способа решить эту проблему:

-

Использовать текстовый редактор для поиска всех ссылок и замены каждой из них соответствующим строкой.

-

Использовать sed для внесения правок. Это похоже на внесение правок вручную, только быстрее.

-

Использовать awk для написания программы, которая (а) читает центральный файл, чтобы составить список имен ссылок и их определения, (b) читает документ, ища ссылочную вызывающую последовательность, и (c) ищет имя ссылки в списке и заменяет его определением.

Очевидно, что первый способ трудоемкий (и не очень интересный!). Второй способ, использующий sed, имеет то преимущество, что создает инструмент для выполнения этой работы. Довольно просто написать сценарий sed, который ищет \*[CHerrorhand] и заменяет его, например, на Глава 16, Обработка ошибок. Такой же скрипт можно использовать для изменения каждого из файлов документа. Недостаток в том, что замены жестко запрограммированы; то есть для каждой перекрестной ссылки вам нужно написать команду, которая делает замену. Третий метод, использующий awk, создает инструмент, который работает с любой перекрестной ссылкой, имеющей такой же синтаксис. Этот скрипт также можно использовать для расширения перекрестных ссылок в других книгах. Это спасает вас от необходимости составлять список конкретных замен. Это наиболее общее решение из трех и разработано для максимально возможного повторного использования в качестве инструмента.

Частью решения проблемы является знание того, какой инструмент следует создать. Бывают случаи, когда сценарий sed является лучшим выбором, потому что проблема не поддается или не требует более сложного сценария awk. Вы должны иметь в виду, какие приложения лучше всего подходят для sed и awk.

-

Полагаю, что название этого раздела представляет собой комбинацию древнего китайского проклятия «чтоб ты жил в эпоху перемен» и того, что Тим О'Рейли однажды сказал мне, что кто-то решит проблему, если найдет ее интересной. [Д.Д.]

1.2 Потоковый редактор

Sed — «неинтерактивный» потоковый редактор. Он ориентирован на потоки, потому что, как и многие UNIX-программы, ввод проходит через программу и направляется на стандартный вывод. (vi, например, не ориентирован на поток. Как и большинство приложений DOS.) Ввод обычно поступает из файла, но может быть направлен с клавиатуры[2]. По умолчанию вывод выводится на экран терминала, но вместо этого может быть записан в файл. Sed работает, интерпретируя сценарий, определяющий действия, которые необходимо выполнить.

Sed предлагает возможности, которые кажутся естественным расширением интерактивного редактирования текста. Например, он предлагает функцию поиска и замены, которая может быть применена глобально к одному файлу или группе файлов. Вы обычно не используете sed для изменения термина, который появляется один раз в конкретном файле, но вам будет очень полезно внести ряд изменений в несколько файлов. Подумайте о том, что вы можете сделать 20 различных правок в более чем 100 файлах за считанные минуты, и вы получите представление о том, насколько мощным может быть sed.

Использование sed аналогично написанию простых сценариев оболочки (или пакетных файлов в DOS). Вы задаете последовательность действий, которые должны выполняться последовательно. Большинство этих действий можно было бы выполнить вручную из vi: замена текста, удаление строк, вставка нового текста и т.д. Преимущество sed заключается в том, что вы можете указать все инструкции по редактированию в одном месте, а затем выполнить их за один проход через файл. Вам не нужно заходить в каждый файл, чтобы внести каждое изменение. Sed также можно эффективно использовать для редактирования очень больших файлов, которые будут медленно редактироваться в интерактивном режиме.

Существует множество вариантов использования sed в процессе создания и ведения документа, особенно когда документ состоит из отдельных глав, каждая из которых помещена в отдельный файл. Как правило, после того, как проект документа вернулся из проверки, есть ряд изменений, которые могут быть применены ко всем файлам. Например, во время выполнения проекта документации по программному обеспечению название программного обеспечения или его компонентов может измениться, и вам придется отслеживать и вносить эти изменения. С sed это простой процесс.

Sed можно использовать для достижения согласованности во всем документе. Вы можете искать все различные способы использования определенного термина и сделать их все одинаковыми. Вы можете использовать sed для вставки специальных наборных кодов или символов перед форматированием troff. Например, он может быть использован для замены кавычек кодами символов ASCII для прямых и обратных двойных кавычек («фигурные кавычки» вместо «квадратных»).

Sed также может использоваться в качестве фильтра редактирования. Другими словами, вы можете обработать входной файл и отправить выходные данные в другую программу. Например, вы можете использовать sed для анализа обычного текстового файла и вставки макросов troff, прежде чем направлять выходные данные в troff для форматирования. Это позволяет вам вносить изменения на лету, возможно, те, которые являются временными.

Автор или издатель может использовать sed для написания многочисленных программ преобразования — например, для преобразования кодов форматирования в файлах Scribe или TeX в troff или для преобразования файлов текстовых редакторов ПК, таких как WordStar. Позже мы рассмотрим сценарий sed, который преобразует макрос troff в теги таблицы стилей для использования в Ventura Publisher. (Возможно, sed можно было бы использовать для перевода программы, написанной в синтаксисе одного языка, в синтаксис другого языка.) Когда Sun Microsystems впервые выпустила Xview, они выпустили программу преобразования для преобразования программ SunView в XView, и программа в основном состояла из sed-скриптов, конвертирующих имена различных функций.

Sed имеет несколько рудиментарных программных конструкций, которые могут быть использованы для построения более сложных сценариев. Он также имеет ограниченную способность работать с более чем одной строкой одновременно.

Все сценарии sed, кроме простейших, обычно вызываются из «оболочки» (shell wrapper), сценария оболочки, который вызывает sed и также содержит команды, которые выполняет sed. Оболочка — это простой способ назвать и выполнить команду из одного слова. Пользователям команды даже не нужно знать, что используется sed. Одним из примеров такой оболочки является скрипт phrase, который мы рассмотрим позже в этой книге. Он позволяет сопоставить шаблон, который может занимать две строки, устраняя конкретное ограничение grep.

Таким образом, используйте sed:

-

Для автоматизации действий редактирования, выполняемых с одним или несколькими файлами.

-

Чтобы упростить задачу выполнения одних и тех же правок в нескольких файлах.

-

Чтобы написать программы конвертации.

-

Однако это не особенно полезно.

1.3 Язык программирования с сопоставлением шаблонов

Определение awk как языка программирования отпугивает некоторых людей от него. Если вы один из них, подумайте об awk как о другом подходе к решению проблем, при котором у вас больше контроля над тем, что вы хотите получить от компьютера.

Sed можно рассматривать как оборотную сторону интерактивного редактирования. Процедура sed достаточно близко соответствует тому, как применить команды редактирования вручную. Sed ограничивает вас методами, которые вы используете в текстовом редакторе. Awk предлагает более общую вычислительную модель для обработки файла.

Типичным примером программы awk является программа, преобразующая данные в форматированный отчет. Данные могут быть файлом журнала, созданным программой UNIX, такой как uucp, и отчет может суммировать данные в формат, полезный для системного администратора. Другой пример — приложение для обработки данных, состоящее из отдельных программ ввода и извлечения данных. Ввод данных — это процесс структурированной записи данных. Извлечение данных — это процесс извлечения данных из файла и создания отчета.

Ключ ко всем этим операциям в том, что данные имеют некую структуру. Проиллюстрируем это с помощью аналогии с бюро. Комод состоит из нескольких ящиков, и каждый ящик имеет определенный набор содержимого: носки в одном ящике, нижнее белье в другом и свитера в третьем ящике. Иногда ящики имеют отделения, позволяющие хранить вместе разные вещи. Это все конструкции, которые позволяют определить, куда идут вещи, когда вы сортируете белье, и где вещи можно найти, когда вы одеваетесь. Awk позволяет вам использовать структуру текстового файла при написании процедур для ввода и извлечения вещей.

Таким образом, преимущества awk лучше всего проявляются, когда данные имеют какую-то структуру. Текстовый файл может быть слабо или плотно структурирован. Глава, содержащая основные и второстепенные разделы, имеет определенную структуру. Хорошо посмотрите на сценарий, который извлекает заголовки разделов и пронумеровывает их для создания схемы. Таблица, состоящая из элементов, разделенных табуляцией в столбцах можно считать очень структурированной. Вы можете использовать сценарий awk для переупорядочивания столбцов данных или даже преобразования столбцов в строки и строк в столбцы.

Как и сценарии sed, сценарии awk обычно вызываются с помощью оболочки. Это сценарий оболочки, который обычно содержит командную строку, которая вызывает awk, а также сценарий, который интерпретирует awk. Простые однострочные скрипты awk можно вводить из командной строки.

Вот некоторые из вещей, которые позволяет вам делать awk:

-

Просматривать текстовый файл как текстовую базу данных, состоящую из записей и полей.

-

Использовать переменные для управления базой данных.

-

Использовать арифметические и строковые операторы.

-

Использовать общие программные конструкции, такие как циклы и условные выражения.

-

Создавать форматированные отчеты.

-

Определять функции.

-

Выполнять команды UNIX из сценария.

-

Обрабатывать результат команд UNIX.

-

Более изящно обрабатывать аргументы командной строки.

-

Упрощать работу с несколькими входными потоками.

Благодаря этим функциям awk обладает мощностью и диапазоном, на которые пользователи могут рассчитывать при выполнении задач, выполняемых сценариями оболочки. В этой книге вы увидите примеры генератора команд на основе меню, интерактивной проверки орфографии и программу обработки индексов, каждая из которых использует указанные выше функции.

Возможности awk расширяют идею редактирования текста до вычислений, делая возможным выполнение множества задач обработки данных, включая анализ, извлечение и создание отчетов. Это действительно наиболее распространенное использование awk, но есть и много необычных приложений: awk использовался для написания интерпретатора Lisp и даже компилятора!

1.4 Четыре препятствия на пути к освоению sed и awk

Существует ряд вводных книг по UNIX, которые познакомят вас с sed и awk. Цель этой книги продвинуть вас намного дальше — помочь вам освоить sed и awk и сократить время и усилия, необходимые для достижения этой цели.

На пути к освоению sed и awk есть четыре препятствия. Вы должны научиться:

-

Использовать sed и awk. Это относительно небольшое препятствие, которое нужно преодолеть, потому что, к счастью, sed и awk работают очень похожим образом, основываясь на строчном редакторе

ed. Глава 2, Понимание основных операций, описывает механику использования sed и awk. -

Применять синтаксис регулярных выражений UNIX. Использование синтаксиса регулярных выражений UNIX для шаблона сопоставления характерно как для sed, так и для awk, а также для многих других программ UNIX. Это может быть трудное препятствие по двум причинам: синтаксис непонятен, и хотя у многих есть некоторый опыт использования регулярных выражений, немногие усердно овладели синтаксисом. Чем проще вам использовать этот синтаксис, тем проще использовать sed и awk. Вот почему много времени посвящено регулярным выражениям в Главе 3, Понимание синтаксиса регулярных выражений.

-

Взаимодействовать с оболочкой. Хотя это напрямую не связано с самими sed и awk, управление взаимодействием с командной оболочкой часто является неприятной проблемой, поскольку оболочка использует ряд специальных символов для обеих программ. По возможности избегайте проблемы, поместив свой скрипт в отдельный файл. Если нет, используйте для своих скриптов оболочку, совместимую с Bourne (правила цитирования более просты), и используйте одинарные кавычки для включения сценария. Если вы используете

cshв качестве интерактивной оболочки, не забывайте экранировать восклицательные знаки обратной косой чертой (\!). Нет другого способа заставитьcshоставить восклицательный знак в покое[3]. -

Писать скрипты. Это самое сложное, скорее похожее на серию высоких препятствий. Из-за этого основная часть книги посвящена написанию скриптов. С помощью sed вы должны изучить набор однобуквенных команд. С awk вы должны изучить операторы языка программирования. Однако, чтобы получить навык написания скриптов, вы просто должны изучить множество примеров и, конечно же, попробовать свои силы в написании скриптов самостоятельно.

Если вы практиковали бег с препятствиями, то знаете, что просто способность преодолевать препятствия не позволит выиграть гонку — нужно научиться преодолевать их быстро. При написании скриптов изучение набора команд или языка сценариев просто устраняет препятствие. Приобретение способности решать интересные проблемы с помощью ваших скриптов приобретается достаточно быстро, чтобы конкурировать.

-

Ну, еще вы можете установить переменную

histchars. См. Справочную страницуcsh.

Глава 2

Понимание основных операций

Если вы только начинаете изучать sed и awk, вам будет полезно посмотреть, сколько у них общего.

-

Они вызываются с использованием аналогичного синтаксиса.

-

Обе утилиты ориентированы на поток, считывая ввод из текстовых файлов по одной строке за раз и направляя результат в стандартный вывод.

-

Они используют регулярные выражения для сопоставления с образцом.

-

Они позволяют пользователю указывать инструкции в сценарии.

Одна из причин, по которой у них так много общего, заключается в том, что их происхождение можно найти в одном строковом редакторе, ed. В этой главе мы начнем с краткого обзора ed и покажем, как sed и awk были логическими шагами к созданию программируемого редактора.

Отличия sed и awk заключаются в типах инструкций, контролирующих выполняемую ими работу. Не ошибитесь — это серьезное различие, и оно влияет на типы задач, которые лучше всего выполнять этими программами.

В этой главе рассматривается синтаксис командной строки sed и awk и базовая структура скриптов. Также в ней предлагается учебное пособие с использованием списка рассылки, которое даст вам представление о написании сценария. Ценно увидеть скрипты sed и awk бок о бок, прежде чем вы сосредоточитесь на одном из них.

2.1 Awk — от sed и grep, sed и grep — от ed

Происхождение awk можно ретроспективно проследить до sed и grep, а через эти две программы — до ed, исходного строкового редактора UNIX.

Вы когда-нибудь использовали строковый редактор? Если это так, то вам будет гораздо легче понять строчную ориентацию sed и awk. Если вы использовали vi, полноэкранный редактор, то вы знакомы с рядом команд, производных от его базового строкового редактора ex (который, в свою очередь, является надмножеством функций в ed).

Давайте рассмотрим некоторые основные операции с помощью строкового редактора ed. Не волнуйтесь — это упражнение предназначено, чтобы помочь вам узнать sed и awk, а не попытаться убедить вас в чудесах строковых редакторов. Команды ed, показанные в этом упражнении, идентичны командам sed, которые вы узнаете позже. Не стесняйтесь экспериментировать с ed самостоятельно, чтобы получить представление о том, как это работает. (Если вы уже знакомы с ed, можете спокойно переходить к следующему разделу.)

При использовании строкового редактора вы работаете с одной строке за раз. Важно знать, на какой строке вы находитесь в файле. Когда вы открываете файл с помощью ed, он отображает количество символов в файле и помещает вас в последнюю строку.

$ ed test

339

Других подсказок нет. Если вы вводите команду, которую ed не понимает, он выводит знак вопроса как сообщение об ошибке. Вы можете ввести команду печати, p, чтобы отобразить текущую строку.

$ p

label on the first box.

По умолчанию команда влияет только на текущую строку. Чтобы внести изменения, вы переходите к нужной строке для редактирования, а затем применяете команду. Чтобы перейти к строке, вы указываете ее адрес. Адрес может состоят из номера строки, символа, указывающего конкретную позицию в файле, или регулярного выражения. Вы можете перейти к первой строке, введя номер строки 1. Затем вы можете ввести команду удаления, чтобы удалить эту строку.

1

You might think of a regular expression

d

Ввод 1 делает первую строку текущей строкой, отображая ее на экране. Команда delete в ed — это d, и здесь она удаляет текущую строку. Вместо того чтобы переходить к строке и затем редактировать ее, вы можете приставить к команде редактирования адрес, указывающий, какая строка или диапазон строк является объектом команды. Если вы введете 1d, то первая строка будет удалена.

Вы также можете указать регулярное выражение в качестве адреса. Чтобы удалить строку, содержащую слово regular, вы можете выполнить эту команду:

/regular/dгде косые черты разделяют регулярное выражение, а regular — это строка, которую вы хотите сопоставить. Эта команда удаляет первую строку, содержащую regular, и делает следующую за ней строку текущей строкой.

NOTE: Убедитесь, что вы понимаете, что команда delete удаляет всю строку. Она не просто удаляет слово

regularв строке.

Чтобы удалить все строки, содержащие регулярное выражение, нужно в начале выражения ввести букву g, означающую global.

g/regular/dГлобальная команда делает все строки, соответствующие регулярному выражению, объектами указанной команды.

Удаление текста может увести вас далеко. Подстановка текста (замена одного фрагмента текста другим) намного интереснее. Команда подстановки в ed — это s:

[address]s/pattern/replacement/flagpattern — это регулярное выражение, которое соответствует фрагменту в текущей строке, который нужно заменить на replacement. Например, следующая команда заменяет первое вхождение слова regular на complex в текущей строке.

s/regular/complex/Адрес не указан, поэтому он влияет только на первое вхождение в текущей строке. Если в текущей строке не найден regular, это ошибка. Чтобы найти несколько вхождений в одной строке, вы должны указать флаг g:

s/regular/complex/gЭта команда изменяет все вхождения в текущей строке. Адрес должен быть указан, чтобы эта команда действовала не только на текущую строку. Следующая команда подстановки указывает адрес:

/regular/s/regular/complex/gЭта команда влияет на первую строку, которая соответствует адресу в файле. Помните, что первый regular — это адрес, а второй — шаблон для подстановки команды. Чтобы применить его ко всем строкам, используйте глобальную команду, поставив g перед адресом.

g/regular/s/regular/complex/gТеперь замена производится везде — все вхождения во всех строках.

NOTE: Обратите внимание на разные значения

g. Букваgв начале — это глобальная команда, которая означает внесение изменений во все строки, соответствующие адресу. Букваgв конце — это флаг, который означает изменение каждого вхождения в строке, а не только первого.

Адрес и образец не обязательно должны совпадать.

g/regular expression/s/regular/complex/gВ любой строке, содержащей строку regular expression, замените regular на complex. Если адрес и шаблон совпадают, вы можете сказать об этом редактору ed, указав два последовательных разделителя (//).

g/regular/s//complex/gВ этом примере regular указан как адрес, а шаблон, который должен быть сопоставлен для замены, — им же. Если кажется, что мы слишком поверхностно рассмотрели эти команды, не беспокойтесь. Позже мы рассмотрим их еще раз.

Знакомая утилита grep для UNIX является производной от следующей глобальной команды в ed:

g/re/pчто означает global regular expression print. Grep — это команда редактирования строки, извлеченная из ed и ставшая доступной как внешняя программа. Она запрограммирована на выполнение одной команды редактирования. Она принимает регулярное выражение как аргумент в командной строке и использует его как адрес строк для печати. Вот пример поиска строк, соответствующих box:

$ grep 'box' test

You are given a series of boxes, the first one labeled "A",

label on the first box.

Она печатает все строки, соответствующие регулярному выражению.

Еще одна интересная особенность ed — это возможность записывать ваши правки, помещая их в отдельный файл и направляя их как ввод в строковый редактор. Например, если последовательность команд была помещена в файл с именем ed-script, следующая команда выполняет сценарий:

ed test < ed-scriptЭта функция делает ed программируемым редактором, то есть вы можете записать любое действие, которое можете выполнить вручную.

Sed был создан как специализированный редактор, предназначенный исключительно для выполнения скриптов; в отличие от ed, его нельзя использовать в интерактивном режиме. Sed отличается от ed прежде всего тем, что он ориентирован на поток. По умолчанию все входные данные sed проходят через стандартный вывод. Сам входной файл не изменяется. Если вы действительно хотите изменить входной файл, вы обычно используете механизм оболочки для перенаправления вывода, и когда вас устраивают внесенные вами изменения, заменяете исходный файл на измененную версию.

ed не ориентирован на поток, и изменения вносятся в сам файл. Скрипт ed должен содержать команды для сохранения файла и выхода из редактора. Он не выводит на экран никаких результатов, кроме тех, которые может сгенерировать конкретная команда.

Ориентация sed на поток имеет большое влияние на то, как применяется адресация. В ed команда без адреса влияет только на текущую строку. Sed просматривает файл, строка за строкой, так что каждая строка становится текущей строкой, и к ней применяются команды. В результате sed применяет команду без адреса к каждой строке файла.

Посмотрите на следующую команду подстановки:

s/regular/complex/Если вы введете эту команду в интерактивном режиме в ed, вы замените первое вхождение regular на complex в текущей строке. В сценарии ed, если это первая команда в сценарии, это будет применяется только к последней строке файла (текущая строка ed по умолчанию). Однако в сценарии sed та же самая команда применяется ко всем строкам. То есть команды sed неявно глобальны. В sed предыдущий пример имеет тот же результат, что и следующая глобальная команда в ed:

g/regular/s//complex/NOTE: Понимание разницы между адресацией текущей строки в

edи глобальной адресацией строк в sed очень важна. Вedвы используете адресацию, чтобы расширить число строк, являющихся объектом команды; в sed вы используете адресацию, чтобы ограничить число строк, затронутых командой.

Sed также был разработан с рядом дополнительных команд, поддерживающих написание сценариев. Мы посмотрим на многие из этих команд в Главе 6. Расширенные команды sed.

Awk был разработан как программируемый редактор, который, как и sed, ориентирован на поток и интерпретирует сценарий команды редактирования. В чем awk отличается от sed, так это в отказе от набора команд строчного редактора. Вместо этого он предлагает язык программирования, созданный по образцу языка C. Например, оператор print заменяет команду p. Концепция адресации сохраняется, так что:

/regular/ { print }печатает те строки, которые соответствуют regular. Фигурные скобки ({}) оборачивают серию из одного или нескольких операторов, которые применяются к одному и тому же адресу.

Преимущество использования языка программирования в сценариях состоит в том, что он предлагает множество дополнительных способов управления тем, что может делать программируемый редактор. Awk предлагает выражения, условные операторы, циклы и другие программные конструкции.

Одной из наиболее отличительных особенностей awk является то, что он парсит или разбивает каждую строку ввода и делает отдельные слова, доступными для обработки скриптом. (Такой редактор, как vi, также распознает слова, позволяя вам перемещать слово за словом или делать слово объектом действия, но эти функции могут использоваться только в интерактивном режиме.)

Хотя awk был разработан как программируемый редактор, пользователи обнаружили, что сценарии awk также могут выполнять ряд других задач. Авторы awk даже представить себе не могли, что с его помощью можно писать большие программы. Но, осознав, что awk использовался таким образом, авторы пересмотрели язык, создав nawk, чтобы обеспечить большую поддержку для написания более крупных программ и решения задач программирования общего назначения. Эта новая версия с незначительными улучшениями теперь кодифицирована стандартом POSIX.

2.2 Синтаксис командной строки

Вы вызываете sed и awk примерно так:

command [options] script filenameКак и почти все программы UNIX, sed и awk могут принимать входные данные из стандартного ввода и отправлять выходные данные на стандартный вывод. Если filename указан, то входные данные берутся из этого файла. Выходные данные содержат обработанную информацию. Стандартный вывод — это экран дисплея, и обычно вывод из этих программ направляется туда. Он также может быть отправлен в файл с использованием перенаправления ввода-вывода в оболочке, но он не должен идти в тот же файл, который предоставляет входные данные для программы.

options для каждой команды различны. Мы продемонстрируем многие из этих вариантов в следующих разделах. (Полный список опций командной строки для sed можно найти в Приложении A. Краткий справочник по sed; полный список опций для awk находится в Приложении B. Краткий справочник по awk.)

script определяет, какие инструкции выполнять. Если он указан в командной строке, то сценарий должен быть заключен в одинарные кавычки — в том случае, если он содержит пробел или любые символы, которые могут быть интерпретированы оболочкой (например, $ и *).

Один из вариантов, общих для sed и awk, — это параметр -f, который позволяет указать имя файла сценария. По мере увеличения размера скрипта его удобно размещать в файле. Таким образом, вы можете вызвать sed следующим образом:

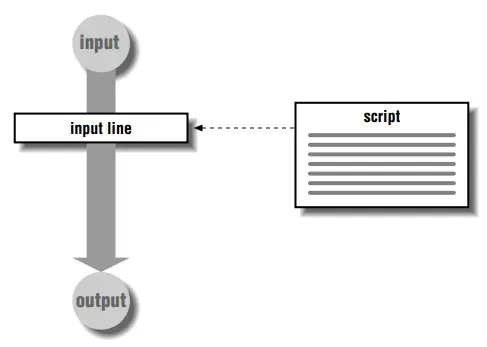

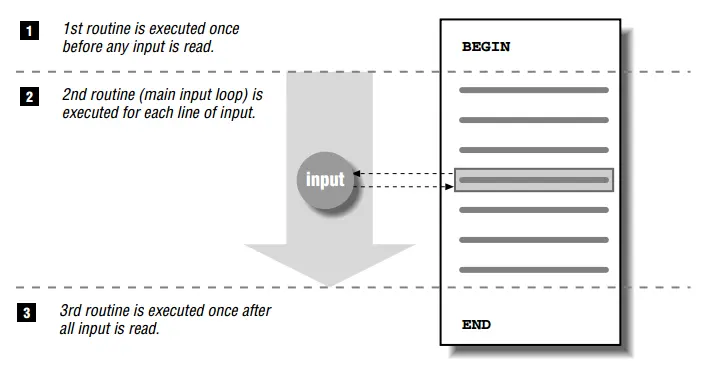

sed -f scriptfile inputfileНа Рис. 2.1 показана основная работа sed и awk. Каждая программа считывает одну входную строку за раз из входного файла, создает копию входной строки и выполняет инструкции, указанные в скрипте на этой копии. Таким образом, изменения, внесенные во входную строку, не влияют на фактический входной файл.

Рис. 2.1: Как работают sed и awk

2.2.1 Создание сценариев

Сценарий — это когда вы говорите программе, что делать. Требуется по крайней мере одна строка инструкции. Короткие сценарии могут быть заданы в командной строке; более длинные сценарии обычно помещаются в файл, где они могут легко пересматриваться и тестироваться. При написании сценария имейте в виду последовательность, в которой будут выполняться инструкции, и как каждая инструкция изменяет входную строку.

В sed и awk каждая инструкция состоит из двух частей: шаблона и процедуры. Шаблон является регулярным выражением, разделенным косой чертой (/). Процедура определяет одно или несколько действий, которые необходимо выполнить.

По мере чтения каждой строки входных данных программа считывает первую инструкцию в скрипте и проверяет шаблон в текущей строке. Если совпадение отсутствует, процедура игнорируется и читается следующая инструкция. Если есть совпадение, то следует действие или действия, указанные в процедуре. Так читаются все инструкции, а не только первая, соответствующая строке ввода.

Когда все применимые инструкции будут интерпретированы и применены для одной строки, sed выводит строку и повторяет цикл для каждой входной строки. Awk, с другой стороны, автоматически не выводит строки; инструкции в вашем сценарии управляют тем, что в конечном итоге с ними делается.

Содержание процедуры очень отличается в sed и awk. В sed процедура состоит из команд редактирования, подобных тем, что используются в строчном редакторе. Большинство команд состоят из одной буквы.

В awk процедура состоит из программных операторов и функций. Процедура должна быть в скобках.

В следующих разделах мы рассмотрим несколько сценариев, которые обрабатывают пример списка рассылки.

2.2.2 Пример списка рассылки

В следующих разделах в примерах используется образец файла с именем list. Он содержит список имен и адреса, как показано ниже.

$ cat list

John Daggett, 341 King Road, Plymouth MA

Alice Ford, 22 East Broadway, Richmond VA

Orville Thomas, 11345 Oak Bridge Road, Tulsa OK

Terry Kalkas, 402 Lans Road, Beaver Falls PA

Eric Adams, 20 Post Road, Sudbury MA

Hubert Sims, 328A Brook Road, Roanoke VA

Amy Wilde, 334 Bayshore Pkwy, Mountain View CA

Sal Carpenter, 73 6th Street, Boston MA

Если хотите, создайте этот файл в своей системе или используйте аналогичный файл собственного изготовления. Потому что большинство примеров в этой главе короткие и интерактивные, вы можете ввести их с клавиатуры и проверить полученные результаты.

2.3 Использование sed

Вызвать sed можно двумя способами: либо вы указываете инструкции по редактированию в командной строке, либо помещаете их в файл и указываете имя файла.

2.3.1 Указание простых инструкций

Вы можете указать простые команды редактирования в командной строке.

sed [-e] 'instruction' fileПараметр -e необходим только в том случае, если вы вводите более одной инструкции в командной строке. Он указывает sed, что нужно интерпретировать следующий аргумент как инструкцию. Когда есть одна инструкция, sed может сделать это определение самостоятельно. Давайте посмотрим на несколько примеров.

Используем входной файл list, в следующем примере используется команда s для замены подстроки MA на Massachusetts.

$ sed 's/MA/Massachusetts/' list

John Daggett, 341 King Road, Plymouth Massachusetts

Alice Ford, 22 East Broadway, Richmond VA

Orville Thomas, 11345 Oak Bridge Road, Tulsa OK

Terry Kalkas, 402 Lans Road, Beaver Falls PA

Eric Adams, 20 Post Road, Sudbury Massachusetts

Hubert Sims, 328A Brook Road, Roanoke VA

Amy Wilde, 334 Bayshore Pkwy, Mountain View CA

Sal Carpenter, 73 6th Street, Boston Massachusetts

Инструкция влияет на три строки, но отображаются все строки.

Заключать инструкцию в одинарные кавычки обязательно не во всех случаях, но вы должны привыкнуть всегда это делать. Заключение в одинарные кавычки не позволяет оболочке интерпретировать специальные символы или пробелы, найденные в инструкции по редактированию. (Оболочка использует пробелы для определения отдельных аргументов, передаваемых программе; символы, которые являются специальными для оболочки, разворачиваются перед вызовом команды.)

Например, первый пример можно было бы ввести без них, но в следующем примере они требуется, так как команда подстановки содержит пробелы:

$ sed 's/ MA/, Massachusetts/' list

John Daggett, 341 King Road, Plymouth, Massachusetts

Alice Ford, 22 East Broadway, Richmond VA

Orville Thomas, 11345 Oak Bridge Road, Tulsa OK

Terry Kalkas, 402 Lans Road, Beaver Falls PA

Eric Adams, 20 Post Road, Sudbury, Massachusetts

Hubert Sims, 328A Brook Road, Roanoke VA

Amy Wilde, 334 Bayshore Pkwy, Mountain View CA

Sal Carpenter, 73 6th Street, Boston, Massachusetts

Чтобы поставить запятую между городом и штатом, инструкция заменила пробел перед двубуквенным сокращением на запятую и пробел.

Есть три способа указать несколько инструкций в командной строке:

-

Разделить инструкции точкой с запятой.

sed 's/ MA/, Massachusetts/; s/ PA/, Pennsylvania/' list -

Перед каждой инструкцией поставить

-e.sed -e 's/ MA/, Massachusetts/' -e 's/ PA/, Pennsylvania/' list -

Использовать возможность многострочного ввода оболочки Bourne[1]. Нажмите RETURN после ввода одинарной кавычки, появится вторичное приглашение (

>) для многострочного ввода.$ sed ' > s/ MA/, Massachusetts/ > s/ PA/, Pennsylvania/ > s/ CA/, California/' list John Daggett, 341 King Road, Plymouth, Massachusetts Alice Ford, 22 East Broadway, Richmond VA Orville Thomas, 11345 Oak Bridge Road, Tulsa OK Terry Kalkas, 402 Lans Road, Beaver Falls, Pennsylvania Eric Adams, 20 Post Road, Sudbury, Massachusetts Hubert Sims, 328A Brook Road, Roanoke VA Amy Wilde, 334 Bayshore Pkwy, Mountain View, California Sal Carpenter, 73 6th Street, Boston, MassachusettsЭтот метод не будет работать в оболочке C. Вместо этого используйте точку с запятой в конце каждой инструкции, и вы можете вводить команды на нескольких строках, заканчивая каждую строку обратной косой чертой. (Или можно временно войти в оболочку Bourne, введя

shи затем набрав команду.)

В приведенном выше примере изменения были внесены в пять строк и, конечно же, были отображены все строки. Помните, что во входном файле ничего не изменилось.

-

В наши дни существует множество оболочек, совместимых с оболочкой Борна и работающих так, как описано здесь:

ksh,bash,pdkshиzsh, и это лишь некоторые из них.

2.3.1.1 Искажение команды

Синтаксис команды sed может быть пространным, и легко допустить ошибку или пропустить обязательный элемент. Обратите внимание, что происходит при вводе неполного синтаксиса:

$ sed -e 's/MA/Massachusetts' list

sed: command garbled: s/MA/Massachusetts

Sed обычно отображает любую строку, которую не может выполнить, но не сообщает вам, что не так с командой[2]. В данном случае ошибка в том, что слэш, который отмечает поиск и замену частей команды, отсутствует в конце команды замены. GNU sed более полезен:

$ gsed -e 's/MA/Massachusetts' list

gsed: Unterminated ‘s' command

(В современных версиях GNU sed сообщения более подробны и даже могут быть локализованы, напр: sed: -e выражение #1, символ 21: незавершенная команда `s' (Прим. пер.))

-

Некоторые поставщики, кажется, улучшили ситуацию. Например, в SunOS 4.1.x sed сообщает

sed: Ending delimiter missing on substitution: s/MA/Massachusetts

2.3.2 Файлы сценариев

Вводить более длинные сценарии редактирования в командную строку нецелесообразно. Поэтому обычно лучше создавать файл сценария, содержащий инструкции по редактированию. Скрипт редактирования — это просто список команд sed, который выполняется в том порядке, в котором они появляются. Эта форма, использующая параметр -f, требует указания имени файла скрипта в командной строке.

sed -f scriptfile fileВсе команды редактирования, которые мы хотим выполнить, помещаются в файл. Мы придерживаемся соглашения о создании временных файлов сценариев с именем sedscr.

$ cat sedscr

s/ MA/, Massachusetts/

s/ PA/, Pennsylvania/

s/ CA/, California/

s/ VA/, Virginia/

s/ OK/, Oklahoma/

Следующая команда считывает все команды подстановки в sedscr и применяет их к каждой строке во входном файле list:

$ sed -f sedscr list

John Daggett, 341 King Road, Plymouth, Massachusetts

Alice Ford, 22 East Broadway, Richmond, Virginia

Orville Thomas, 11345 Oak Bridge Road, Tulsa, Oklahoma

Terry Kalkas, 402 Lans Road, Beaver Falls, Pennsylvania

Eric Adams, 20 Post Road, Sudbury, Massachusetts

Hubert Sims, 328A Brook Road, Roanoke, Virginia

Amy Wilde, 334 Bayshore Pkwy, Mountain View, California

Sal Carpenter, 73 6th Street, Boston, Massachusetts

И снова результат оказывается эфемерным, отображаемым только на экране. Во входном файле не производится никаких изменений.

Если сценарий sed можно использовать снова, его следует переименовать и сохранить. Проверенные скрипты могут храниться в личной или общесистемной библиотеке.

2.3.2.1 Сохранение вывода

Если вы не перенаправляете вывод sed в другую программу, вам нужно будет записать вывод в файл. Это делается путем указания одного из символов перенаправления ввода-вывода оболочки, за которым следует имя файла:

$ sed -f sedscr list > newlistНе перенаправляйте вывод в файл, который вы редактируете, иначе вы его испортите. (Оператор перенаправления > усекает файл до того, как оболочка сделает что-либо еще.) Если вы хотите, чтобы выходной файл заменял входной файл, вы можете сделать это как отдельный шаг, используя команду mv. Но сначала убедитесь, что ваш скрипт редактирования работает правильно!

В Главе 4, Написание сценариев sed мы рассмотрим сценарий оболочки с именем runsed, который автоматизирует процесс создания временного файла и использования mv для перезаписи исходного файла.

2.3.2.2 Подавление автоматического отображения строк ввода

По умолчанию sed выводит каждую строку ввода. Параметр -n подавляет автоматический вывод. При указании этой опции каждая инструкция, предназначенная для вывода, должна содержать команду печати, p. Взгляните на следующий пример.

$ sed -n -e 's/MA/Massachusetts/p' list

John Daggett, 341 King Road, Plymouth Massachusetts

Eric Adams, 20 Post Road, Sudbury Massachusetts

Sal Carpenter, 73 6th Street, Boston Massachusetts

Сравните этот вывод с первым примером в этом разделе. Здесь только те строки, которые были затронуты командой sed.

2.3.2.3 Параметры смешивания (POSIX)

Вы можете создать сценарий, объединив в командной строке параметры -e и -f. Сценарий — это комбинация всех команд в указанном порядке. Похоже, это поддерживается в версиях UNIX sed, но эта функция четко не задокументирована на странице руководства. Стандарт POSIX явно требует это поведение.

2.3.2.4 Список параметров

В Таблице 2.1 приведены параметры командной строки sed.

Таблица 2.1: Параметры командной строки sed

| Опция | Описание |

|---|---|

| -e | Далее следует инструкция по редактированию. |

| -f | Далее следует имя файла сценария. |

| -n | Подавить автоматический вывод входных строк. |

2.4 Использование awk

Как и sed, awk выполняет набор инструкций для каждой строки ввода. Вы можете указать инструкции в командной строке или создать файл сценария.

2.4.1 Запуск awk

Для запуска в командной строке синтаксис таков:

awk 'instructions' filesВходные данные считываются по строке за раз из одного или нескольких files или из стандартного ввода. Инструкции должны быть заключены в одинарные кавычки, чтобы защитить их от оболочки. (Инструкции почти всегда содержат фигурные скобки и/или знаки доллара, которые интерпретируются оболочкой как специальные символы.) Несколько командных строк можно вводить таким же образом, как показано для sed: разделяя команды точками с запятой или используя возможность многострочного ввода оболочки Bourne.

Программы Awk обычно помещаются в файл, где они могут быть протестированы и изменены. Синтаксис вызова awk с файлом скрипта таков:

awk -f script filesОпция -f работает так же, как и в sed.

В то время как инструкции awk имеют ту же структуру, что и sed, состоящие из разделов шаблона и процедуры, сами процедуры совершенно различны. Вот где awk выглядит меньше как редактор и больше как язык программирования. Вместо одно- или двухсимвольных командных последовательностей существуют операторы и функции. Например, оператор print используется для печати значения выражения или для печати содержимого текущей строки ввода.

Awk, в обычном случае, интерпретирует каждую входную строку как запись, а каждое слово в этой строке, разделенное пробелами или табуляциями, как поле. (Эти значения по умолчанию можно изменить.) Один или несколько последовательных пробелов или табуляций считаются одним разделителем. Awk позволяет ссылаться на эти поля либо в шаблонах, либо в процедурах. $0 представляет собой вся входная строка. $1, $2, ... обращение к отдельным полям в строке ввода. Awk разбивает входную запись перед применением скрипта. Давайте рассмотрим несколько примеров, используя пример списка входных файлов list.

Первый пример содержит одну инструкцию, которая печатает первое поле каждой строки входного файла.

$ awk '{ print $1 }' list

John

Alice

Orville

Terry

Eric

Hubert

Amy

Sal

$1 относится к значению первого поля в каждой строке ввода. Поскольку шаблон не задан, оператор print применяется ко всем строкам. В следующем примере задается шаблон «/MA/», но нет никакой процедуры. По умолчанию выполняется печать каждой строки, соответствующей шаблону.

$ awk '/MA/' list

John Daggett, 341 King Road, Plymouth MA

Eric Adams, 20 Post Road, Sudbury MA

Sal Carpenter, 73 6th Street, Boston MA

Печатаются три строки. Как уже упоминалось в первой главе, программа awk может использоваться скорее как язык запросов, извлекая полезную информацию из файла. Можно сказать, что паттерн поставил условие выбора записей для включения в отчет, а именно, что они должны содержать строку «MA». Теперь мы также можем указать, какую часть записи включить в отчет. В следующем примере оператор print используется для ограничения вывода первым полем каждой записи.

$ awk '/MA/ { print $1 }' list

John

Eric

Sal

Если мы попробуем прочитать вышеприведенную инструкцию вслух, это поможет ее понять: Печатать первое слово каждой строки, содержащей строку «MA». Мы можем сказать «слово», потому что по умолчанию awk разделяет входные данные на поля, используя либо пробелы, либо табуляции в качестве разделителя полей.

В следующем примере мы используем опцию -F, чтобы изменить разделитель полей на запятую. Это позволяет нам получить любое из трех полей: полное имя, адрес улицы или город и штат.

$ awk -F, '/MA/ { print $1 }' list

John Daggett

Eric Adams

Sal Carpenter

Не путайте опцию -F для изменения разделителя полей с опцией -f для указания имени файла скрипта.

В следующем примере мы печатаем каждое поле в отдельной строке. Несколько команд разделяются точками с запятой.

$ awk -F, '{ print $1; print $2; print $3 }' list

John Daggett

341 King Road

Plymouth MA

Alice Ford

22 East Broadway

Richmond VA

Orville Thomas

11345 Oak Bridge Road

Tulsa OK

Terry Kalkas

402 Lans Road

Beaver Falls PA

Eric Adams

20 Post Road

Sudbury MA

Hubert Sims

328A Brook Road

Roanoke VA

Amy Wilde

334 Bayshore Pkwy

Mountain View CA

Sal Carpenter

73 6th Street

Boston MA

Наши примеры использования sed изменили содержание входных данных. Наши примеры с использованием awk переставляют данные. В предыдущем примере awk обратите внимание, что начальный пробел теперь считается частью второго и третьего полей.

2.4.2 Сообщения об ошибках

Каждая реализация awk выдает разные ошибки или сообщения при обнаружении проблем в вашей программе. Поэтому мы не будем здесь цитировать сообщения конкретной версии; это будет очевидно, когда возникнет проблема. Сообщения могут быть вызваны любой из следующих причин:

-

Не заключили процедуру в фигурные скобки (

{}) -

Не заключили инструкции в одинарные кавычки (

'') -

Не заключили регулярные выражения в косые черты (

//)

2.4.3 Список параметров

В Таблице 2.2 приведены параметры командной строки awk.

Таблица 2.2: Параметры командной строки awk

| Параметр | Описание |

|---|---|

| -f | Далее следует имя файла сценария. |

| -F | Изменить разделитель полей. |

| -v | Далее следует var=value. |

Параметр -v для инструкций в строке обсуждается в Главе 7. Написание скриптов для awk.

2.5 Совместное использование sed и awk

Каналы в UNIX могут использоваться для передачи вывода одной программы в качестве ввода в следующую программу. Давайте рассмотрим несколько примеров, в которых sed и awk используются для создания отчета. Сценарий sed, который заменил почтовую аббревиатуру штата на его полное имя, является достаточно общим, чтобы его можно было снова использовать как файл сценария с именем nameState:

$ cat nameState

s/ CA/, California/

s/ MA/, Massachusetts/

s/ OK/, Oklahoma/

s/ PA/, Pennsylvania/

s/ VA/, Virginia/

Конечно, вы хотите обрабатывать все штаты, а не только пять, и если вы запускаете его в документах, отличных от списков рассылки, вы должны убедиться, что он не делает ненужных замен.

Вывод этой программы, с использованием входного файла list, такой же, как мы уже видели. В следующем примере выходные данные, полученные с помощью nameState, передаются в программу awk, которая извлекает название штата из каждой записи.

$ sed -f nameState list | awk -F, '{ print $4 }'

Massachusetts

Virginia

Oklahoma

Pennsylvania

Massachusetts

Virginia

California

Massachusetts

Программа awk обрабатывает выходные данные, полученные сценарием sed. Помните, что сценарий sed заменяет аббревиатуру запятой и полным названием штата. По сути, он разбивает третье поле, содержащее город и штат, на два поля. $4 относится к четвертому полю.

То, что мы делаем здесь, можно было бы сделать полностью в sed, но, вероятно, с большей трудностью и меньшей обобщенностью. Кроме того, поскольку awk позволяет вам заменить соответствующую строку, вы можете полностью достичь этого результата с помощью скрипта awk.

Хотя результат этой программы не очень полезен, его можно было бы передать в sort | uniq -c, который сортировал бы штаты в алфавитный список с подсчетом количества вхождений каждого штата.

Теперь мы займемся чем-то более интересным. Мы хотим подготовить отчет, который сортирует имена по штатам и перечисляет названия штата, за которыми следует имя каждого человека, проживающего в этом штате. В следующем примере показана программа byState.

#! /bin/sh

awk -F, '{

print $4 ", " $0

}' $* |

sort |

awk -F, '

$1 == LastState {

print "\t" $2

}

$1 != LastState {

LastState = $1

print $1

print "\t" $2

}'

Этот сценарий оболочки состоит из трех частей. Программа вызывает awk для получения входных данных для программы sort, а затем снова вызывает awk для проверки отсортированных входных данных и определения того, совпадает ли имя штата в текущей записи с именем предыдущей записи. Давайте посмотрим сценарий в действии:

$ sed -f nameState list | ./byState

California

Amy Wilde

Massachusetts

Eric Adams

John Daggett

Sal Carpenter

Oklahoma

Orville Thomas

Pennsylvania

Terry Kalkas

Virginia

Alice Ford

Hubert Sims

(При нормальных настройках безопасности без указания текущего каталога byState не вызовется, поэтому вызывать нужно так ./byState (Прим. пер.))

Имена сортируются по штатам. Это типичный пример использования awk для создания отчета из структурированных данных.