Практическая загрузка

Изучите процесс загрузки Linux, Windows и Unix

Йогеш Бабар

Кембриджский университет, 2020

перевод В.Айсин

Эта книга в другом переводе — с подстветкой синтаксиса кода — выложена здесь:

http://onreader.mdl.ru/HandsonBooting/content/index.html

Эта книга посвящена Red Hat. Его удивительная культура работы доказала, что делиться – значит заботиться.

Об авторе

Йогеш Бабар работает в Red Hat последние десять лет. В настоящее время он является главным инженером технической поддержки в области ядра Linux. Он специализируется на устранении неполадок и настройке производительности корпоративных серверов Linux. Процесс загрузки Linux — его сильная сторона, и он регулярно выступает на конференциях и форумах по открытому коду. Он также проводит семинары по операционным системам для студентов-инженеров.

О техническом рецензенте

Марк Сандаски — инженер встраиваемого программного обеспечения с 28-летним опытом низкоуровневого программирования. Он работал в таких отраслях, как BIOS для ПК, медицинское оборудование и оборона. У него есть опыт работы со встроенными ОС (Linux, Windows Embedded Compact), RTOS (uCOS/II, FreeRTOS) и физическими системами. В настоящее время он живет в южной Калифорнии со своей женой и тремя детьми. Вы можете связаться с ним по адресу marc_sandusky@outlook.com или www.linkedin.com/in/marc-sandusky-67852b2/.

Благодарности

Я хотел бы поблагодарить Харальда Хойера за написание dracut и Леннарта Пёттеринга за написание systemd. Харальд, ты проявил огромное терпение, отвечая на мои вопросы.

Также спасибо: Шиталу, Раме и Шумику, которые посоветовали мне задокументировать процедуру загрузки; Партх Госвами, который помог мне написать об этом краткую статью; Рангану и Рагвендре Паю за регулярную просьбу предоставлять обновленную информацию; и Гохале Сир за то, что зажег во мне искру, а также за то, что показал мне, в чем я действительно хорош.

Спасибо всей команде Apress, особенно редактору по закупкам Селестине Джон, координатору проекта Адите Мираши и редактору по развитию Мэтью Муди, которые приложили огромные усилия для разработки этой книги. Особая благодарность Марку Сандаски за техническую рецензию книги. Поскольку это была моя первая книга, я допустил много ошибок, но вся команда Apress поддерживала меня на протяжении всего процесса.

И последнее, но не менее важное: спасибо моей красивой, сильной и удивительной жене. Даршана, какое терпение ты проявила! Иногда я удивляюсь, как тебе удалось остаться с кем-то вроде меня, который всегда гонится за каким-то проектом.

Введение

В первую неделю я работал на новой работе и увидел, как один из наших клиентов просил помощи по проблеме «невозможно загрузиться». Я был новичком и неопытным. Я хотел помочь, но не смог. Заказчик был в панике, поскольку это привело к остановке производства. Для них была на счету каждая минута, потому что тысячи пользователей не могли получить доступ к этой системе, поскольку она не загружалась. Все были в панике. В конце концов некоторые из наших старших инженеров решили проблему. Им потребовалось почти пять часов, чтобы вернуть систему в эксплуатацию. В конце концов все сложилось хорошо, но эта напряженная ситуация породила во мне что-то — желание учиться. Я решил изучить всю последовательность загрузки.

Когда я начал искать книги и статьи в Интернете, меня постигло разочарование. По операционным системам доступны тысячи книг и бесчисленное количество статей, но я не смог найти ни одной книги, которая подробно объясняла бы всю последовательность загрузки.

В мире открытого исходного кода есть поговорка: если вы что-то ищете, но оно недоступно, создайте это. Итак, я решил изучить последовательность загрузки самостоятельно. Мне потребовались годы, чтобы понять всю последовательность загрузки. Лучшее, что я делал в своем путешествии, — это вел записи, а также начал преподавать то, чему научился, другим. В конце концов, делиться — значит заботиться. Мои сессии загрузки стали популярны среди студентов-инженеров и системных администраторов. Некоторые из них действительно подтолкнули меня к написанию настоящей книги по этой теме. Я обратился в Apress, и идея им понравилась, так что сегодня у вас в руках первая книга по загрузке.

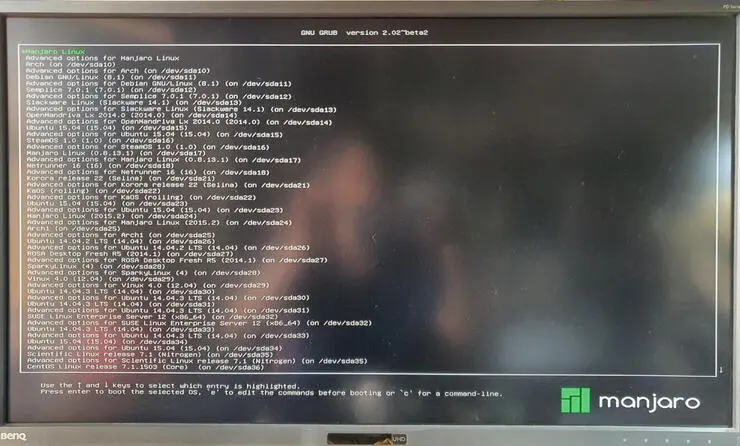

В этой книге использован уникальный подход. Сначала я расскажу, почему вам следует изучить загрузку. Другими словами, почему это важно? Далее я объясню, как работают разные загрузчики, установив почти 100+ операционных систем на один компьютер. О загрузчике Linux есть отдельная глава. Фактически, для каждого компонента, участвующего в последовательности загрузки, есть отдельные главы. Далее я объясню роль ядра в последовательности загрузки. Ядро играет жизненно важную роль наряду с systemd. Поскольку systemd — это первый процесс, запускаемый ядром, в конечном итоге он берет на себя всю последовательность загрузки. В нескольких главах рассматривается systemd, поэтому эта книга — хороший ресурс для тех, кто хочет прочитать о systemd. Я также рассмотрел наиболее распространенные сценарии «не могу загрузить» в Linux. Это делает книгу отличным ресурсом и для системных администраторов. Это не значит, что эта книга предназначена только для экспертов по Linux. Если вы знаете основы Linux, то эта книга для вас. Книга — отличный мост между новичками и экспертами Linux. Надеюсь, вам понравятся эти усилия.

Есть старая поговорка: ни одна книга не идеальна. Если вы обнаружите какие-либо ошибки в этой книге или просто хотите связаться со мной, напишите мне по адресу yogeshbabar420@gmail.com.

Спасибо,

Йогеш Бабар

Глава 1

Введение

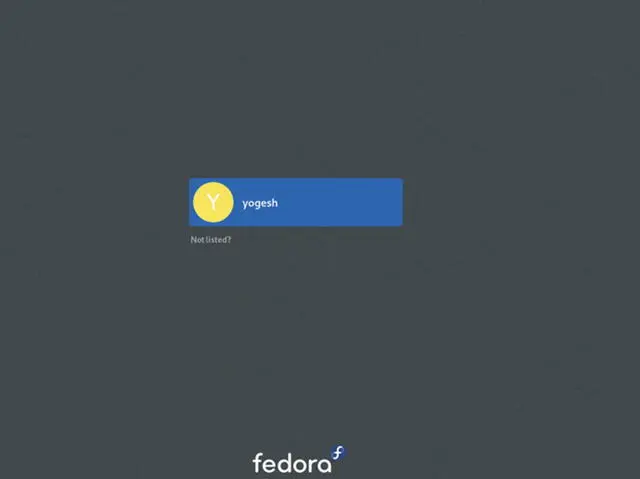

Не все знают Fedora. Однажды кто-то задал мне вопрос:

Студент: Что такое Fedora?

Я: Fedora — это Linux.

Студент: Что такое Linux?

Я: Linux — это операционная система.

Студент: Что такое операционная система?

Я: Она управляет компьютерами.

Студент: Что такое компьютер?

Я: Компьютеры помогают пользователям.

Студент: Что такое пользователь?

Я: Пользователь такой же, как я.

Студент: Кто ты, черт возьми, такой?

Я: Ну, меня зовут Йогеш Бабар. Я работаю в Red Hat последние десять лет и люблю рассказывать о том, как загружаются операционные системы.

Зачем?

Всем известно, что загрузка операционной системы занимает примерно 20–30 секунд. Итак, почему я написал 486-страничную книгу о 30-секундной загрузке? Ответ прост.

-

Не существует подходящего документа/статьи/книги, объясняющей полную последовательность загрузки. Вы найдете сотни хороших книг по операционным системам, но ни одной о том, как загружается система.

-

Вы можете решить проблемы с загрузкой, только если знаете, как загружается система.

-

Если вы системный администратор и приходите на собеседование, интервьюеры спросят, как загружается Linux.

-

Проблемы «невозможно загрузиться» всегда имеют самую высокую степень серьезности, поскольку из-за них выходит из строя вся производственная система. Если система работает медленно, производство все еще работает; хотя оно и затронуто, по крайней мере, оно все еще работает. Сервер, на котором работают 10 000 пользователей, но он не может загрузиться, означает, что вся производственная система не работает. В этом важность загрузки, и, как я уже сказал, вы не сможете решить проблемы с загрузкой, если не знаете, как загружается система.

-

Интересно понять процедуру загрузки.

-

Изучив все это, вы обретете огромное счастье.

Что?

Итак, что именно загружается? Технически процесс копирования ядра с жесткого диска в память и последующего его выполнения называется загрузкой (booting). Но это определение на самом деле не вдохновляет нас на изучение загрузки.

Я скажу своими словами: мать — это супермножество, а ее новорожденный ребенок — ее подмножество. Точно так же операционная система — это надмножество, а загрузка — его подмножество. Подмножество принадлежит своему надмножеству.

Теперь рассмотрим такое утверждение: «Ребенок рождает мать».

Технически это неправильно, но представьте себе, что пока у женщины не родится ребенок, она женщина; в тот момент, когда у нее рождается ребенок, женщина становится матерью. Итак, ребенок рождает мать.

То же самое происходит и в компьютерах. Технически загрузка — это часть операционной системы, и операционная система должна порождать загрузку, но все наоборот. Именно загрузка рождает операционную систему. Следовательно, мы можем сказать, что загрузка — это процедура, в результате которой возникает операционная система.

Цель этой книги

В книге объясняется процедура загрузки настольной или серверной системы на базе архитектуры x86, а также рассматривается процедура загрузки различных операционных систем. Основное внимание уделяется углубленному анализу процедуры загрузки Linux, а вторичное внимание уделяется другим популярным операционным системам, таким как Windows и UNIX. Как вы знаете, существует огромное количество дистрибутивов Linux. Некоторые из них предназначены для пользователей настольных компьютеров, некоторые — для корпоративных клиентов, некоторые — исключительно для игровых целей, а некоторые доступны для пользователей, которые предпочитают использовать подход «сделай сам». Практически невозможно описать последовательность загрузки каждого дистрибутива. Поэтому я решил выбрать дистрибутив Linux, который является первым выбором для корпоративных клиентов, а именно Red Hat Enterprise Linux (RHEL).

RHEL основан на Fedora Linux. Fedora развивается быстро (цикл выпуска составляет шесть месяцев), тогда как RHEL — это медленный дистрибутив (цикл выпуска составляет два-три года). Это означает, что Fedora принимает новейшие разработки, как только команда QE (Quality Engineering) дает им зеленый свет. Поскольку Fedora является испытательной площадкой для популярных корпоративных дистрибутивов Linux, все, что доступно в Fedora, в конечном итоге становится частью RHEL. systemd — лучший пример этого. Вот почему я выбрал Fedora Linux для объяснения последовательности загрузки Linux.

Источник питания

Все начинается, когда вы нажимаете кнопку питания. При нажатии кнопки питания питание поступает на материнскую плату. Материнская плата отправляет сигнал на ваш источник питания (SMPS/PSU), который отвечает за исправность источника питания, и в результате материнская плата пытается запустить процессор.

Процессор

Когда процессор на базе архитектуры x86 запускается, он очищает старые данные из всех регистров и начинается с этого:

IP 0xfff0

CS selector 0xf000

CS base 0xffff0000

0xffff0000 + 0xfff0 = 0xffffff0. Это ячейка памяти, в которой CPU ожидает найти первую команду для выполнения. В этой ячейке содержится команда перехода, указывающая на точку входа в BIOS. Другими словами, именно так запускается BIOS или процессор переходит в BIOS/прошивку.

После этого прошивка и загрузчик являются следующим этапом процедуры загрузки. Задача прошивки — запустить загрузчик операционной системы. В следующей главе я расскажу, что происходит в прошивке и как она выполняет загрузчик.

Глава 2

Мультизагрузка

Разобраться в загрузчике и прошивке сложно. Это не обязательно сложно, но тема может быть сложной. Чтобы читателям было легче усвоить эту книгу, я буду использовать три тестовые системы.

| Номер системы | Имя системы | Цель |

|---|---|---|

| 1 | BIOS | Для демонстрации BIOS |

| 2 | UEFI | Для демонстрации UEFI |

| 3 | Jarvis | Для мультизагрузочного проекта со 100+ ОС |

Поскольку загрузчики и прошивка тесно взаимодействуют друг с другом, я начну с установки определенного списка операционных систем в каждой системе и при этом объясню связь между загрузчиком и прошивкой. Такой подход сделает сложные темы более понятными, интересными и увлекательными. Короче говоря, я объясню загрузчик и прошивку (BIOS/UEFI) вместе, хотя это разные понятия.

Список операционных систем

Мы будем устанавливать следующие операционные системы в нашу первую систему BIOS, то есть в систему, в которой установлено встроенное ПО BIOS:

Sun OpenSolaris 2009

Fedora Linux 15

PC-BSD 9.0

Windows 7

Red Hat Enterprise Linux 6.0

Windows Server 2003 (2k3)

Windows XP

Я знаю, что эти операционные системы довольно старые, но я выбрал их не просто так.

Видите ли, BIOS сам по себе является устаревшей прошивкой, поэтому, если вы хотите разобраться в BIOS, вам придется использовать только старые операционные системы. Помните, вы сможете понять UEFI (текущую прошивку), только если разбираетесь в BIOS. Это похоже на то, что вы лучше поймете Java, если хорошо знаете C. Кроме того, использование этих старых операционных систем даст мне возможность коснуться загрузчиков Windows и Unix. Кроме того, это даст мне возможность объяснить устаревший загрузчик Linux GRUB (GRUB Legacy).

Идея заключается в мультизагрузке нашей системы BIOS со всеми операционными системами, упомянутыми ранее. Для этого нам нужно следовать правилам и предписаниям каждой операционной системы.

| OS | Правила |

|---|---|

| Unix | Операционные системы Unix (OpenSolaris и BSD) необходимо устанавливать только в основной раздел. |

| Linux | В Linux нет каких-либо правил установки. Его можно установить в любой основной или логический раздел. |

| Windows | Операционную систему Windows можно установить в любой раздел (основной или логический), но предшественник семейства Windows должен присутствовать в первом основном разделе. Это означает, что вы можете установить Windows 7 в логический раздел, но ее предшественник, XP или win2k3, должен присутствовать в первом основном разделе. Также нельзя нарушить последовательность установки операционной системы Windows. Например, нельзя сначала установить Windows 7, а затем более старую версию Win2k3 или XP. Должно быть в такой последовательности: 98, потом 2000, потом XP. |

Потратьте некоторое время и попытайтесь подготовить последовательность установки вашей ОС. Проверьте последовательность загрузки сейчас.

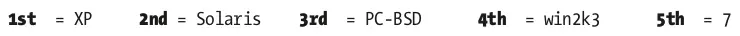

Окончательная последовательность установки операционной системы показана здесь:

- Windows XP

- Sun OpenSolaris 2008

- PC-BSD 9.0

- Windows Server 2003

- Windows 7

- Red Hat Enterprise Linux 6

- Fedora 15

Установка операционных систем

Теперь поговорим об установке операционных систем.

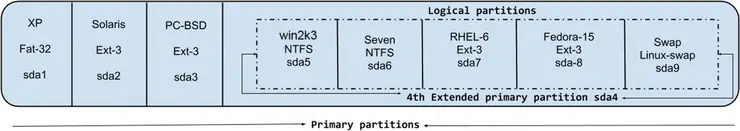

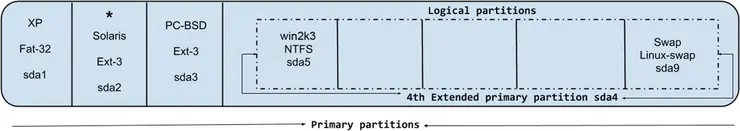

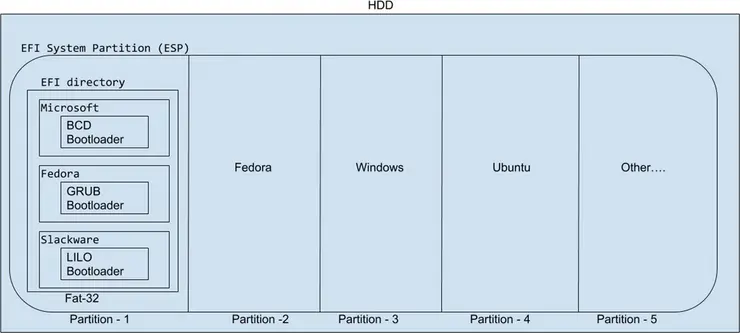

Первичные(основные)/логические разделы

С помощью BIOS мы можем создать только четыре раздела. Но, конечно, вы, вероятно, видели, что используется больше разделов. Итак, позвольте мне немного изменить мое утверждение. В системе на базе BIOS вы можете создать на диске только четыре первичных (основных) (primary) раздела. Если вам нужно больше, вам нужно сделать четвертый основной раздел дополнительным (secondary) (также называемым расширенным (extended)) разделом. Расширенный раздел будет работать как контейнер, и внутри этого контейнера вы можете создать столько логических (logical) разделов, сколько захотите. Почему эти разделы называются логическими, ведь они не видны BIOS? Кроме того, почему BIOS может создать только четыре основных раздела? Ответы на эти вопросы будут даны при обсуждении главной загрузочной записи (MBR).

Разбиение на разделы

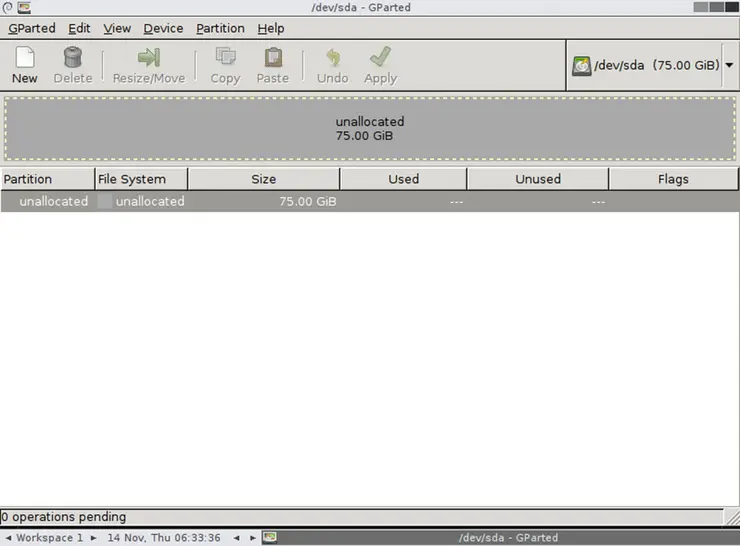

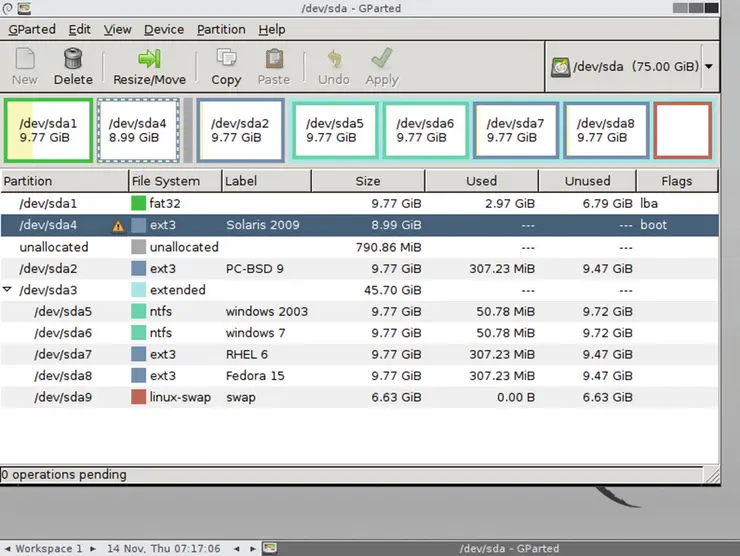

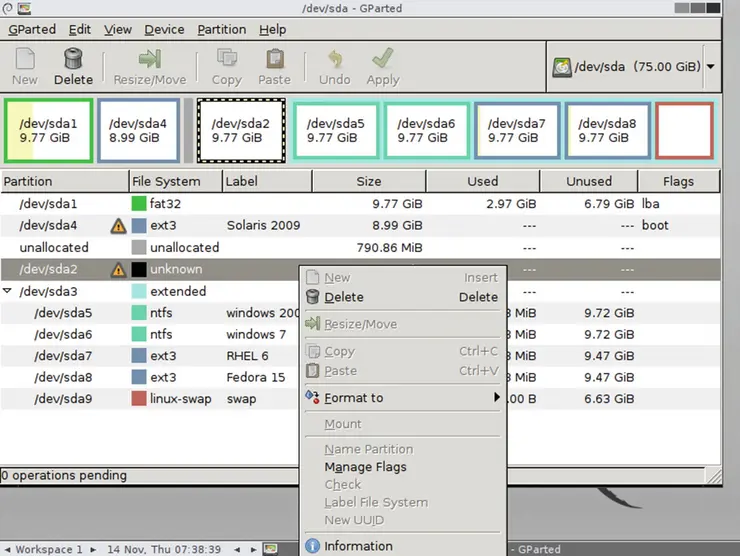

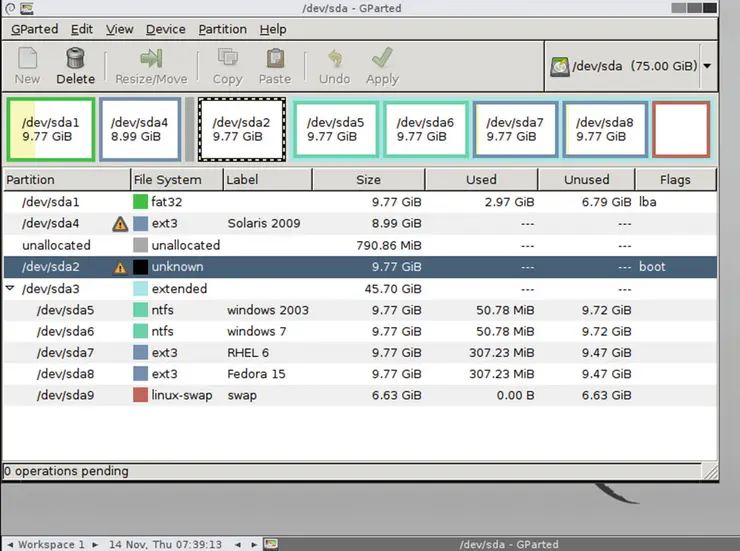

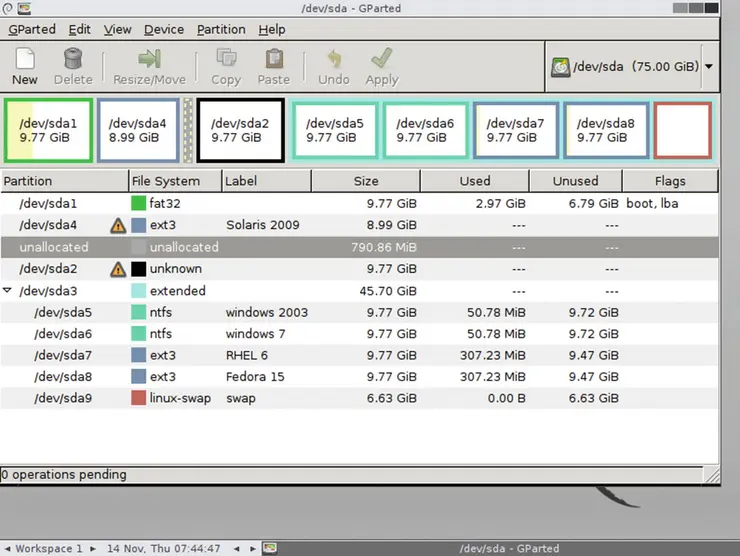

Давайте сначала разобьем жесткий диск системы BIOS. Для этого мы будем использовать Live CD GParted. GParted — это инструмент сообщества GNU. Это бесплатный live-образ ISO на базе Debian Linux с открытым исходным кодом. На рисунке 2-1 показано расположение разделов нашей системы BIOS.

Рисунок 2-1. Структура разделов BIOS в GParted

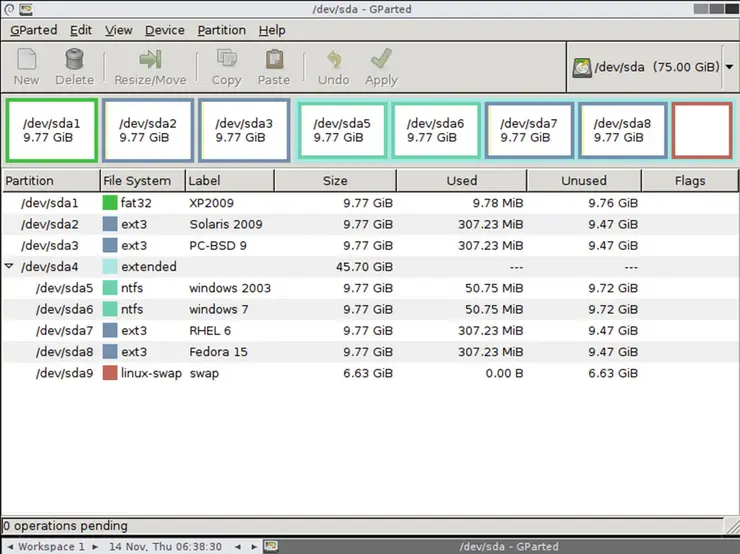

Операция GParted по разделению жесткого диска проста. Мы создадим структуру разделов, показанную на рисунке 2-2, на 75 ГБ дискового пространства.

Рисунок 2-2. Структура раздела, созданного Gparted

Для получения дополнительной информации о том, как использовать GParted для разделения жесткого диска, обратитесь к документации GParted по адресу https://gparted.org/articles.php.

На рисунке 2-3 вы можете увидеть имя диска, размер раздела, используемую файловую систему и связанные с ней флаги (если есть).

Рисунок 2-3. Структура файловой системы, созданная GParted

Давайте установим нашу первую операционную систему в первый основной раздел.

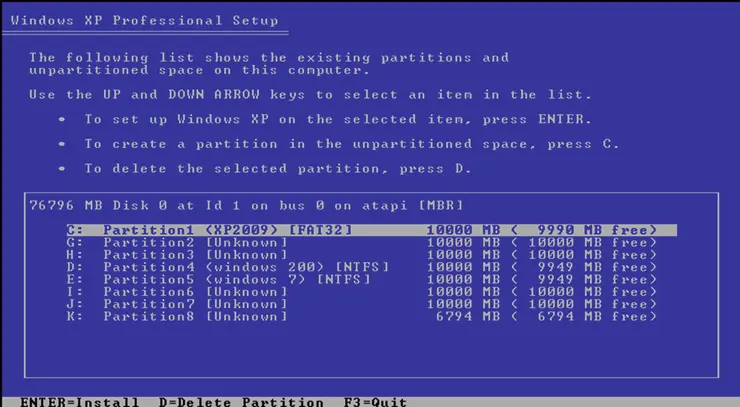

Первая установка ОС: XP

На рисунке 2-4 вы можете увидеть структуру разделов, показанную установщиком Windows XP.

Рисунок 2-4. Схема разделов, показанная установщиком XP

Мы устанавливаем XP на первый основной раздел. С точки зрения Windows это диск C:, как показано на рисунке 2-4. После завершения установки и перезагрузки системы на нашем экране появится Windows XP (рисунок 2-5).

Рисунок 2-5. XP после успешной установки

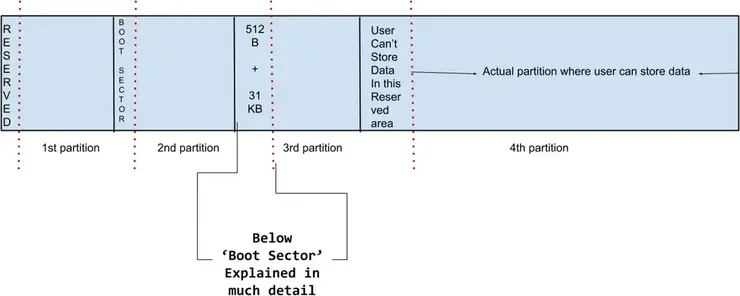

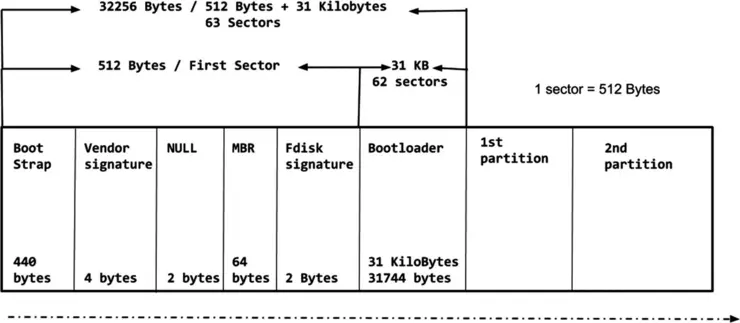

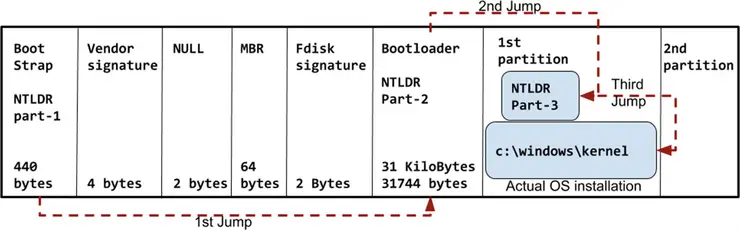

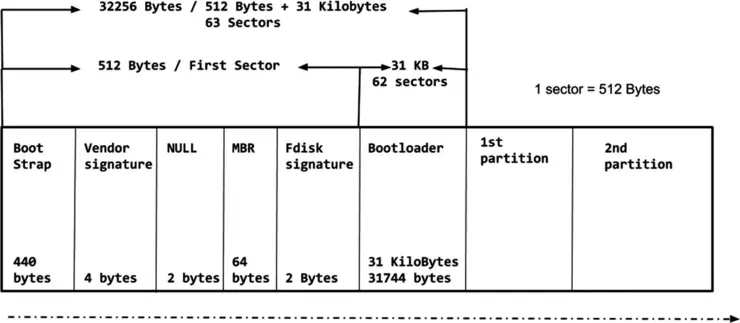

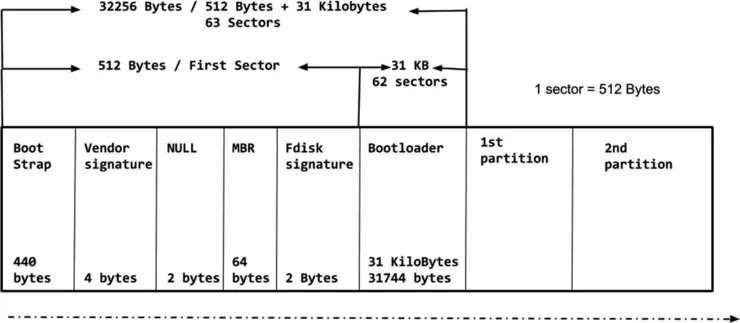

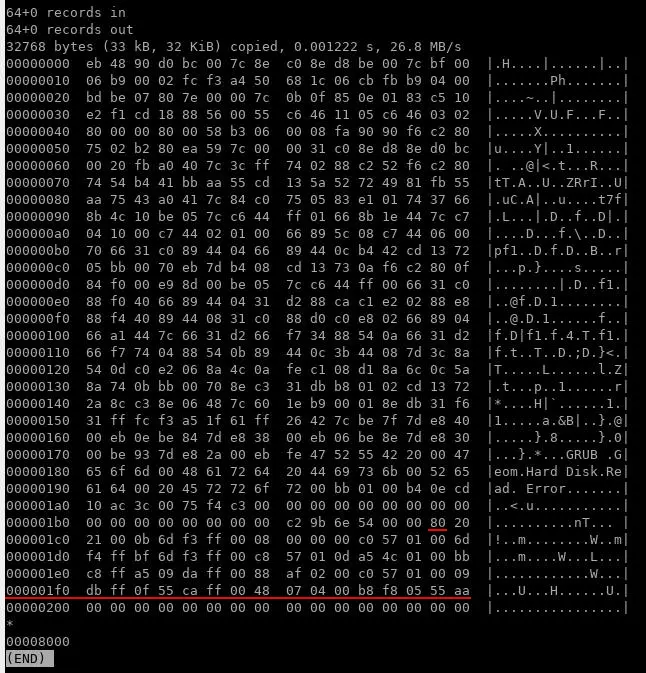

Пришло время разобраться, как загружалась Windows XP, но перед этим нам необходимо разобраться с загрузочным сектором. Загрузочный сектор (boot sector) — это первый сектор каждого жесткого диска (512 байт) плюс 31 КБ пространства; другими словами, это первые 63 сектора загрузочного носителя (от 0 до 62). Или вы можете учесть, что в загрузочном секторе некоторое пространство (512 байт + 31 КБ) каждого раздела будет зарезервировано для хранения информации, связанной с загрузчиком. Это пространство (опять же 512 байт + 31 КБ) не будет показываться пользователям ОС. Фактическое хранение данных в разделе начинается после этого зарезервированного пространства. Обратитесь к рисунку 2-6 для лучшего понимания этого.

Рисунок 2-6. Схема диска в системе на базе BIOS

Загрузочный сектор

На санскрите есть одна удивительная поговорка, которая звучит так: "एकम सत वगाः बहु्ाः वदन्ति सत्य". Это означает, что есть только одна истина, но есть разные способы достичь ее. Как показано на рисунке 2-7, загрузочный сектор называется по-разному, но в конечном итоге концепция остается той же. Люди называют эту структуру следующими именами:

Главная загрузочная запись (MBR) (Master boot record)

Загрузочная запись (Boot record)

Загрузочный сектор (Boot sector)

Загрузчик (Bootloader)

Рисунок 2-7. Загрузочный сектор

В этой книге мы будем называть его загрузочным сектором (boot sector), поскольку жесткий диск (HDD) всегда разделен на сектора, и каждый сектор имеет размер либо 512 байт, либо 4 КБ. Большинство жестких дисков имеют размер сектора 512 байт.

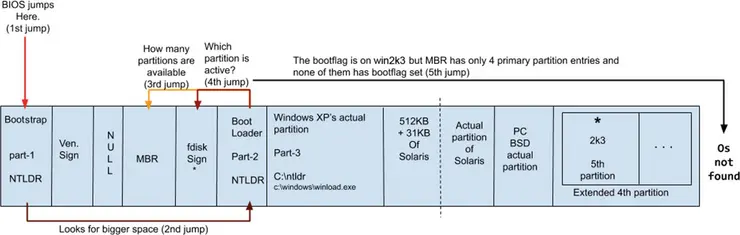

В системе на базе BIOS каждый поставщик ОС (неважно, Windows, Unix или Linux) должен разделить загрузчик на три части. Часть-1 загрузчика будет храниться в первых 440 байтах кода первого сектора диска (это Bootstrap). Часть-2 будет храниться в разделе загрузчика размером 31 КБ (т.е. в следующих 62-х секторах диска, это Bootloader), а последняя часть-3 будет храниться внутри фактического раздела, где установлена конкретная ОС. Проще говоря, всякий раз, когда устанавливается операционная система (в нашем случае это Windows XP), она делит свой загрузчик New Technology Loader (NTLDR) на три части.

| Расположение | Размер | Часть | Информация |

|---|---|---|---|

| Bootstrap (MBR, stage 1) | 440 байт | NTLDR, часть-1 | Самая маленькая часть |

| Bootloader (post-MBR gap, stage 1.5) | 31 КБ | NTLDR, часть-2 | Больше по сравнению с частью-1 |

| Внутри реального раздела ОС, stage 2 | Нет ограничений по размеру | NTLDR, часть-3 | Самая большая часть |

Но почему загрузчик разделен на три части?

Это обусловлено историческими причинами. BIOS имеет технические ограничения: он не может получить доступ к более чем 512 байтам или читать дальше первого сектора. Итак, очевидно, что когда BIOS завершает свою задачу, он переходит к первым 512 байтам жесткого диска, и что бы там ни находилось, он просто запускает этот код. К счастью, эта программа будет нашим загрузчиком bootstrap (440 байт). Поскольку загрузчик bootstrap крошечный по размеру, он делает только одну вещь: переходит на большее пространство, которое является загрузчиком bootloader второй части. Его размер составляет 31 КБ. Эти 31 КБ опять же очень крохотные, и bootloader'у предстоит найти еще больший размер. Он перейдет к части-3, которая находится уже внутри раздела. Этот файл части-3 будет находиться на диске C: под именем NTLDR. Файл части-3 загрузчика XP показан на рисунке 2-8.

Рисунок 2-8. Файл части-3 загрузчика XP

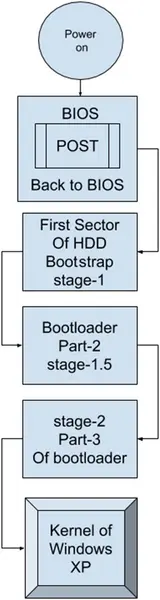

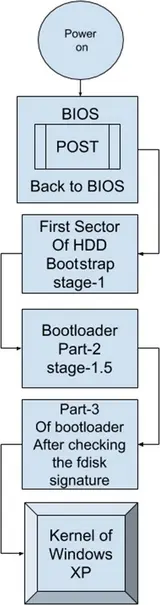

Как видите, размер файла намного больше (245 КБ). Этот файл (он знает, где находится ядро XP) будет выполнять тяжелую работу загрузчика, а именно копировать ядро Windows XP под названием winload.exe из C:\windows в память. Как только ядро будет скопировано в память, работа загрузчика считается завершенной и он исчезает. Помните, OS==kernel==OS. Как только ядро окажется в памяти, оно позаботится об остальной части последовательности загрузки. Вы можете увидеть последовательность загрузки XP на рисунке 2-9.

Рисунок 2-9. Последовательность загрузки Windows XP

Я знаю, что у вас, вероятно, много вопросов. Но продолжайте читать, и на все ваши вопросы будут даны ответы. Давайте продолжим и обсудим поля загрузочного сектора, которые я еще не объяснил. Для этого вы можете обратиться к рисунку 2-10.

Рисунок 2-10. Загрузочный сектор

Поле сигнатуры производителя предназначено для поставщиков жестких дисков. Упомянутые здесь данные говорят нам, какой поставщик изготовил этот жесткий диск, например Seagate, Western Digital, Samsung и т. д. Таким образом, по сути, они содержат информацию о производителе жесткого диска.

NULL имеет только 2 байта пространства. NULL означает NULL. Если это значение не NULL, то BIOS во время процедуры POST будет считать этот жесткий диск неисправным/поврежденным, и загрузка будет остановлена. Итак, оно должно быть NULL. Всякий раз, когда ОС внезапно перезагружается или сама ОС или жесткий диск обнаруживает поврежденный сектор или какое-либо серьезное повреждение, это поле будет помечено как ненулевое.

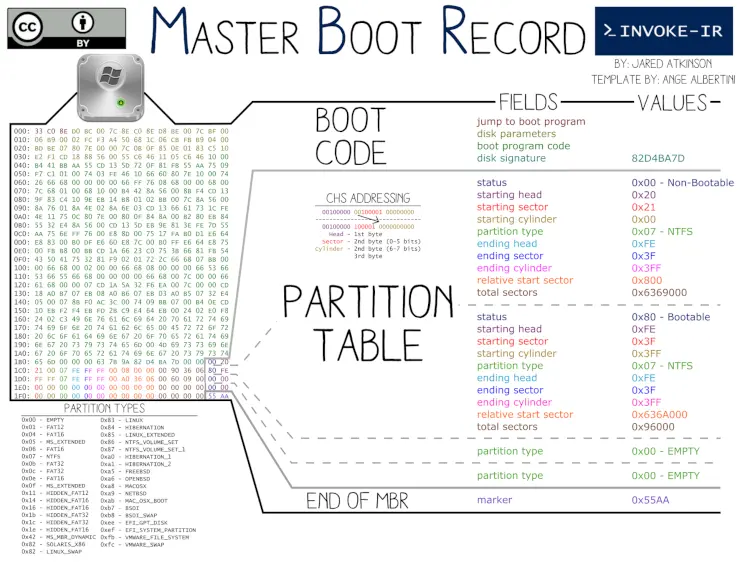

Поле MBR (как уже упоминалось, чаще всего его называют PT (Partititon Table)) может быть самым популярным разделом из всех этих полей. MBR означает «master boot record» и имеет размер 64 байта. MBR далее разделен на четыре части. Размер каждой части составляет 16 байт, и каждая часть содержит информацию об одном разделе.

| Размер | Часть | Хранит |

|---|---|---|

| 16 байт | Часть-1 | Информация первого раздела |

| 16 байт | Часть-2 | Информация второго раздела |

| 16 байт | Часть-3 | Информация третьего раздела |

| 16 байт | Часть-4 | Информация четвертого раздела |

Это означает, что 64 байта MBR могут содержать только четыре записи раздела, и именно по этой причине вы можете создать только четыре основных раздела в системе на базе BIOS.

Сигнатура fdisk также называется флагом загрузки (boot flag); некоторые люди называют его просто звездочкой *, или в стиле Windows его еще называют флагом активности/неактивности (active/inactive flag). fdisk важен в случае мультизагрузки разных операционных систем, о чем мы сейчас говорить не будем.

А пока я хочу, чтобы вы запомнили эти два правила:

Логический раздел не может быть активным.

ОС не может загружаться с логического раздела.

На данный момент эти два правила не будут иметь для вас никакого смысла, но мы обсудим их в подходящее время. На рисунке 2-11 показана полная последовательность загрузки Windows XP.

Рисунок 2-11. Последовательность загрузки Windows XP

Теперь мы установим и загрузим новую ОС, а именно OpenSolaris 2008.

OpenSolaris 2008

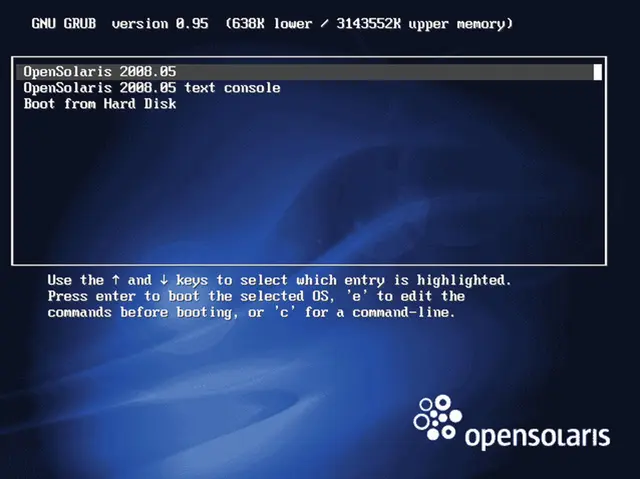

На рисунке 2-12 показан экран при загрузке с установочного носителя OpenSolaris 2008.

Рисунок 2-12. Экран приветствия установочного носителя OpenSolaris 2008

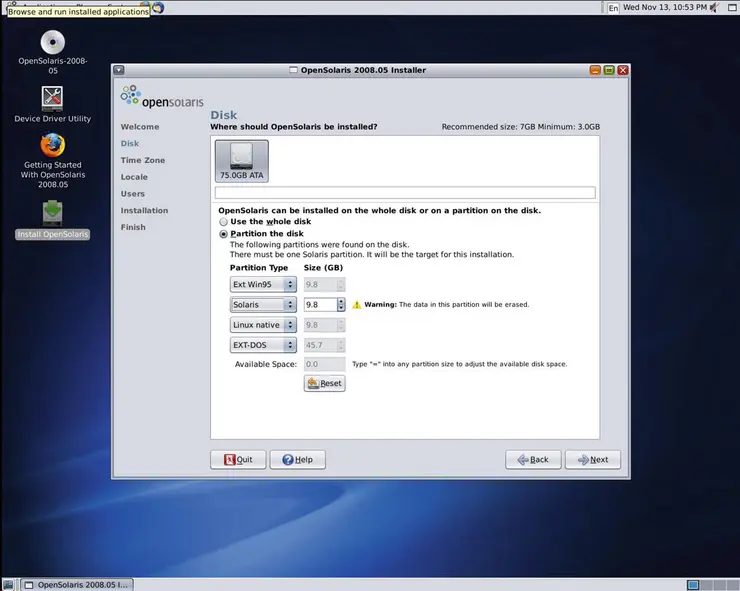

Нам нужно установить OpenSolaris на второй раздел. На рисунке 2-13 вы можете видеть, что мы выбрали второй основной раздел для установки.

Рисунок 2-13. Структура диска, показанная установщиком OpenSolaris 2008

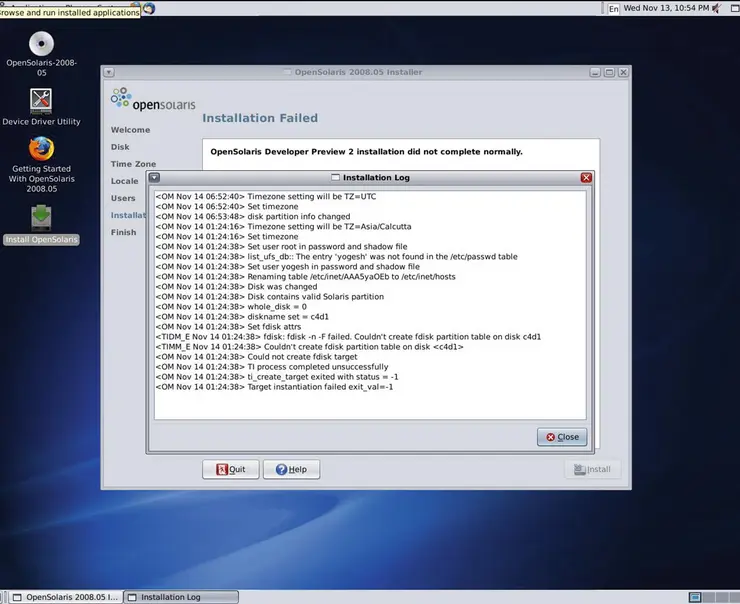

Но, как вы можете видеть на рисунке 2-14, установка завершается неудачей с некоторыми сообщениями об ошибках.

Рисунок 2-14. Установка завершается неудачей с появлением некоторых сообщений об ошибках

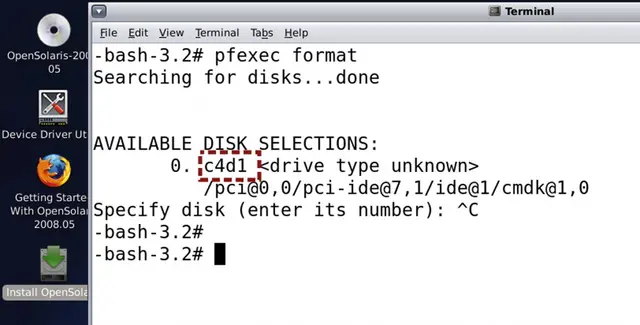

Сообщения об ошибках связаны с файловой системой. Итак, подготовим файловую систему вручную с помощью утилиты fdisk; однако перед этим вы должны знать, какое имя жесткого диска было назначено OpenSolaris. Вывод команды pfexec format (показанный на рисунке 2-15) покажет нам имя жесткого диска.

Рисунок 2-15. Имя жесткого диска, назначенное OpenSolaris

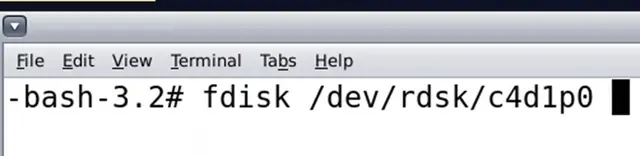

Итак, имя назначенного жесткого диска — c4d1. Нам нужно передать это имя устройства утилите fdisk. Полную команду смотрите на рисунке 2-16.

Рисунок 2-16. Команда fdisk

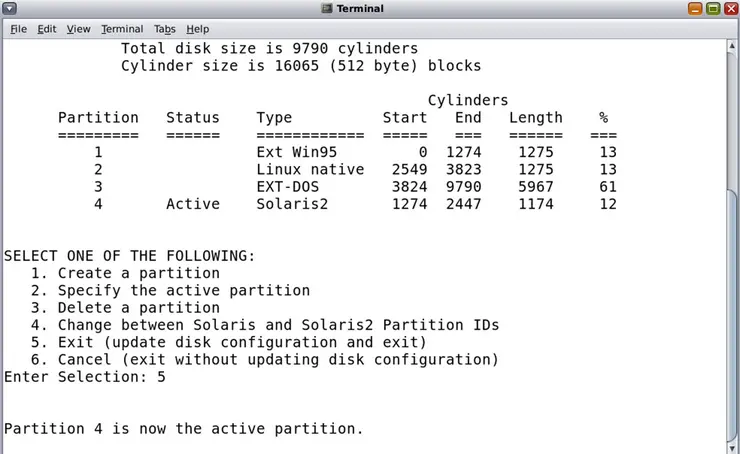

Имя диска указывает номер контроллера 4, номер диска 1 и номер раздела 0. С помощью утилиты fdisk мы сначала удалили второй раздел (который был родным для ext3/Linux) и создали новый раздел с файловой системой Solaris2. Новый раздел становится разделом номер 4. Кроме того, он автоматически становится активным разделом (см. рисунок 2-17). Мы еще не говорили об «активности или fdisk-сигнатуре», но поговорим об этом в ближайшее время.

Рисунок 2-17. Изменения, внесенные с помощью команды fdisk

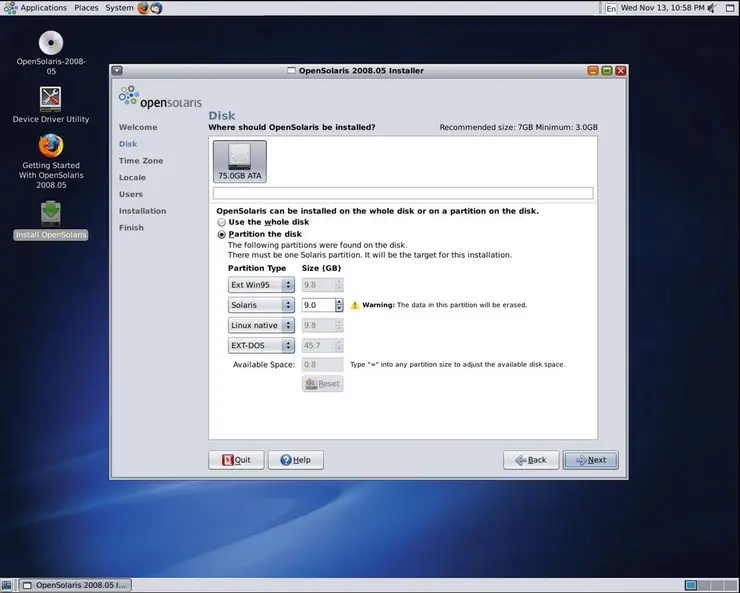

Возвращаясь к нашей установке, давайте перезапустим установку, и, как вы можете видеть на рисунке 2-18, на этот раз мы выбрали раздел, отформатированный в файловой системе OpenSolaris, для установки нашего OpenSolaris 2008.

Рисунок 2-18. Установка OpenSolaris в раздел файловой системы OpenSolaris

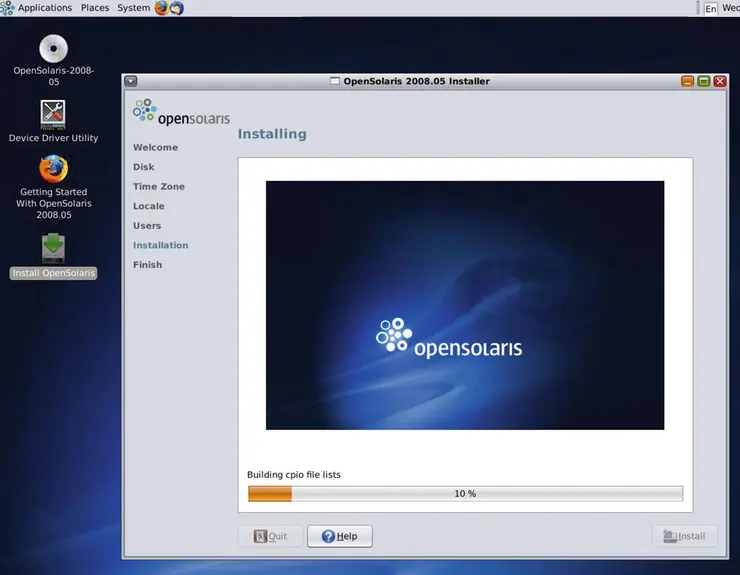

На этот раз установка завершится удачно (см. рисунок 2-19), и OpenSolaris 2008 будет установлен.

Рисунок 2-19. Программа установки не завершится удачно

После установки мы перезагрузим нашу систему BIOS. Как вы думаете, какая ОС будет загружаться?

Windows XP?

OpenSolaris?

XP и OpenSolaris вместе?

Ни одна из них?

Потратьте некоторое время и подумайте, прежде чем продолжить...

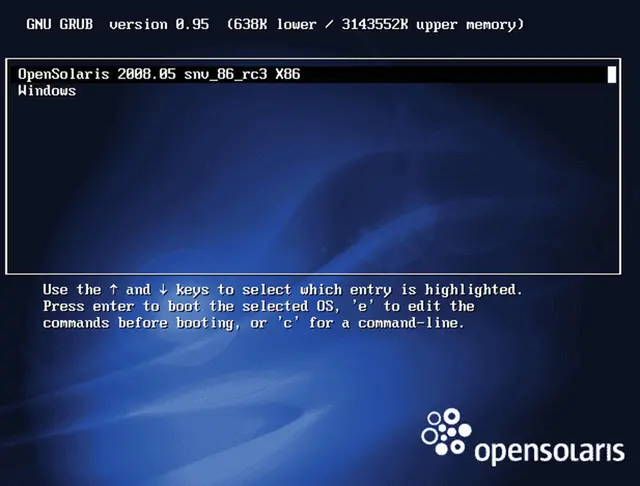

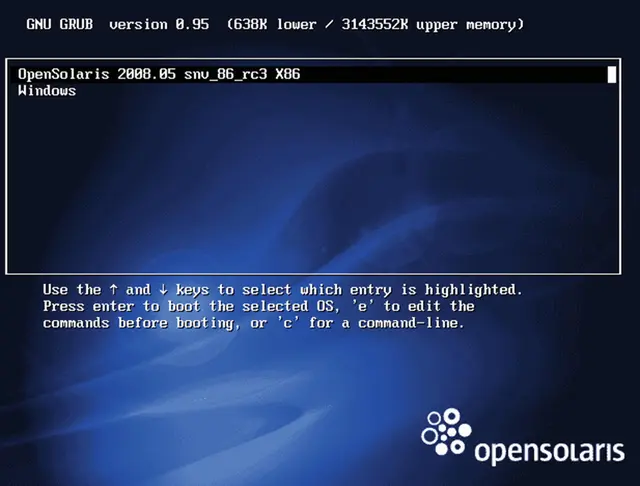

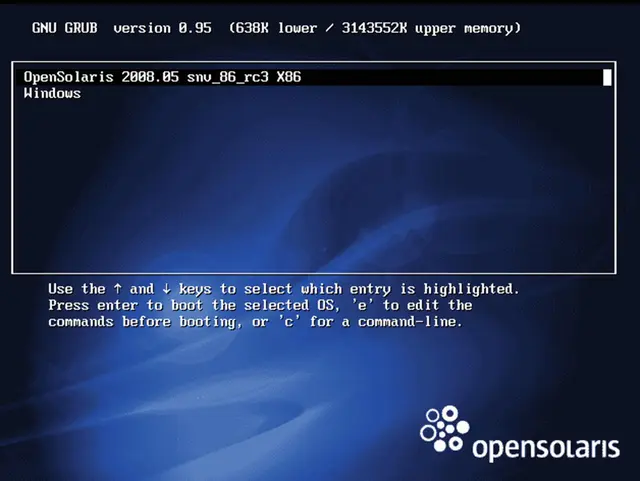

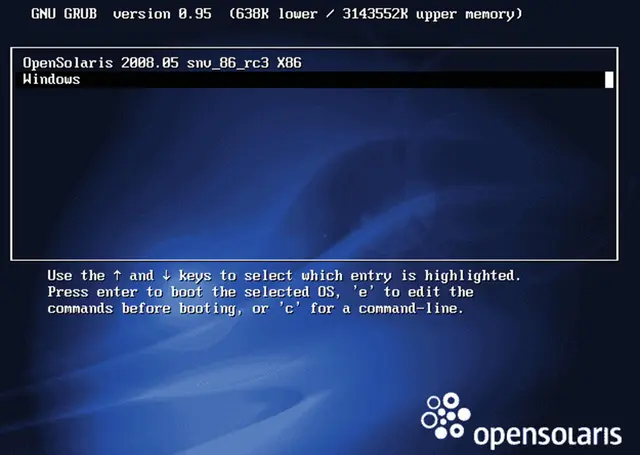

На рисунке 2-20 показано, что мы видим на экране после перезагрузки.

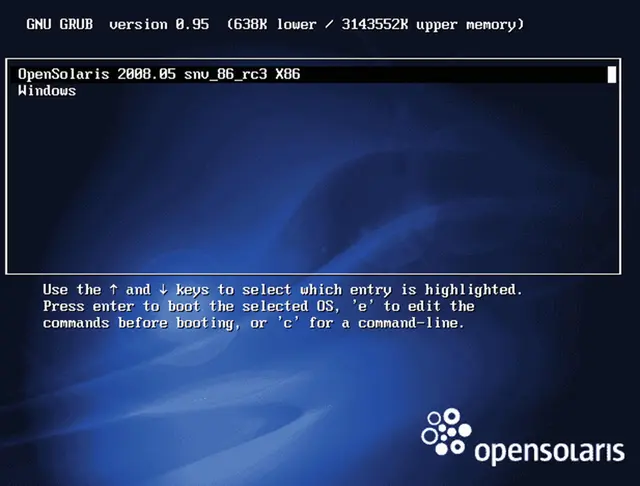

Рисунок 2-20. Экран приветствия после перезагрузки

Итак, здесь загружается ОС OpenSolaris, и она также дает нам возможность загрузить XP. Давайте прольем свет на то, что произошло на заднем плане. OpenSolaris увидел, что он устанавливается в свой собственный раздел (второй), но в первом разделе доступна другая операционная система — Windows (или, по крайней мере, «non-Unix ОС»).

Но как OpenSolaris узнал, что в первом основном разделе установлена другая ОС?

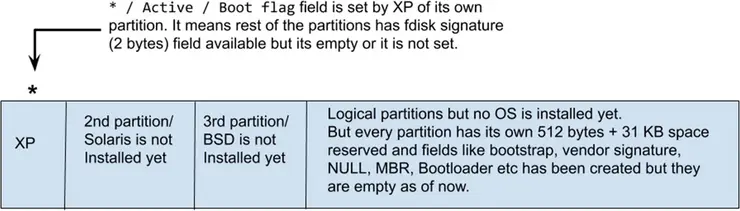

Когда OpenSolaris был установлен в отдельный раздел, он увидел, что сигнатура fdisk установлена в первом основном разделе. (Опять же, подпись fdisk также называется флагом активности или просто флагом *.) Как мы видели и ранее на диаграмме спецификации загрузочного сектора (рисунок 2-21), каждый раздел имеет 512 байт + 31 КБ пространства, зарезервированного для целей загрузки, и это пространство скрыто от пользователя.

Рисунок 2-21. Загрузочный сектор

Другими словами, когда мы создали структуру разделов с помощью GParted, инструмент создал следующие отсеки для каждого раздела:

Загрузчик Bootstrap

Сигнатура производителя

NULL

MBR (PT)

Сигнатура fdisk (признак активности)

Загрузчик Bootloader

Но он заполнял данные только в полях сигнатуры производителя и MBR (PT). Поле сигнатуры производителя будет содержать данные производителя жесткого диска, тогда как в случае поля MBR (PT) данные будут следующими:

Начало и конец первого основного раздела

Начало и конец второго основного раздела

Начало и конец третьего основного раздела

Начало и конец четвертого основного раздела

По сути, будет четыре записи, и каждая запись будет занимать 16 байт. Остальные поля, кроме подписи поставщика и MBR (PT), будут пустыми. Также обратите внимание, что GParted подготовит все отсеки (512 байт + 31 КБ), но заполнит только поля подписи поставщика и MBR для первого основного раздела.

Возвращаясь к полю сигнатуре fdisk, при установке Windows XP было установлено следующее:

Часть-1 NTLDR в загрузчике bootstrap

Часть-2 NTLDR в загрузчике bootloader

Часть-3 NTLDR внутри первого основного раздела

Затем он установил сигнатуру fdisk (признак активности раздела) в свой раздел (2 байта).

Итак, структура диска будет примерно такой, как показано на рисунке 2-22.

Рисунок 2-22. Структура диска после установки XP

OpenSolaris нашел эту структуру диска. Когда установка OpenSolaris была завершена и он захотел установить свой загрузчик (GRUB), он увидел звездочку (*) на первом основном разделе и тогда понял, что уже установлена операционная система Windows. Теперь у GRUB (загрузчика OpenSolaris) есть два варианта.

Установить часть-1 (загрузчик bootstrap) и часть-2 (загрузчик bootloader) GRUB'a в первый основной раздел, а часть-3 GRUB'a в отдельный раздел (второй раздел, где установлен OpenSolaris).

Или установить часть-1 (загрузчик bootstrap) в первые 512 байт своего собственного раздела, часть-2 в 31 КБ своего собственного раздела, а часть-3 также в свой собственный раздел; затем поместить * в свой собственный второй раздел (см. рисунок 2-23).

Рисунок 2-23. Структура диска в GParted после установки OpenSolaris

Обратите внимание, что флаг загрузки вернулся к разделу OpenSolaris. Кроме того, GParted не понимает раздел Solaris2; следовательно, в качестве имени файловой системы отображается ext3.

Если OpenSolaris выберет вариант 1, то ему придется очистить часть-1 и часть-2 загрузчика Windows XP. Это также означает, что будет загружаться только OpenSolaris, а XP загрузиться не сможет. Следовательно, OpenSolaris выбирает вариант 2, предоставляющий равные возможности для загрузки Windows XP. OpenSolaris также создает запись Windows XP в одном из своих файлов (об этом файле мы поговорим позже в этой главе). Всякий раз, когда OpenSolaris начинает загружаться, GRUB обращается к этому файлу и находит в нем запись Windows, которая отображается на экране. На рисунке 2-24 показан экран приветствия OpenSolaris.

Рисунок 2-24. Экран приветствия OpenSolaris

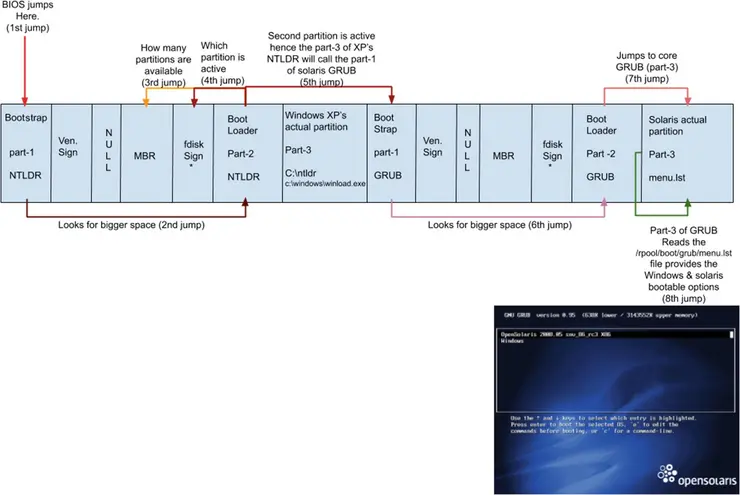

Итак, полная последовательность загрузки OpenSolaris выглядит следующим образом:

-

Включение системы.

-

Процессор переходит в BIOS.

-

BIOS запускает процедуру POST.

-

Возвращаемся в BIOS.

-

BIOS какой-то туповатый; он проверит приоритет загрузки, установленный пользователем.

-

Когда я говорю приоритет загрузки (boot priority), я имею в виду устройство, через которое будет загружаться система.

-

Это может быть CDROM, USB, HDD, PXE и т. д.

-

-

BIOS переходит к первым 512 байтам HDD или к первому сектору загрузочного устройства.

-

Загрузочным устройством может быть что угодно, но на данный момент мы рассматриваем HDD.

-

-

BIOS передаст управление тому двоичному коду, который присутствует в загрузчике bootstrap.

-

Как вы думаете, кто там? Загрузчик Windows (NTLDR) или OpenSolaris (GRUB)? Подумайте немного, а затем продолжайте.

-

Загрузочный сектор, хранящийся в первых 512 байтах, представляет собой NTLDR Windows XP.

-

Вы, должно быть, заметили, что 440 байт пространства загрузчика bootstrap очень малы, и ни один код не может загрузить из него ОС. Следовательно, часть-1 NTLDR (загрузчик bootstrap) просто переходит в большее пространство, то есть в часть-2 (загрузчик bootloader / 31 КБ / виртуальную загрузочную запись). Часть-2 проверяет MBR (PT) (64 байта) и находит в нем четыре записи. Это означает, что на диске четыре основных раздела. Но здесь есть проблема: на каком из четырех основных разделов установлена ОС? Вы, конечно, скажете, что это первый и второй раздел, но откуда загрузчик bootloader знает, где находится ОС? И какая из них должна загружаться? Это реальный вопрос, и для решения этой проблемы было создано поле сигнатуры fdisk. В каком бы разделе ни были заполнены или установлены эти 2 байта, в этом разделе есть операционная система. Итак, когда устанавливалась Windows XP или OpenSolaris, эта ОС обязана заполнить 2 байта поля сигнатуры fdisk или установить

*на своем собственном разделе, чтобы загрузчик bootloader знал, на каком разделе находится ОС. В нашем случае*находится на втором разделе (OpenSolaris сохранил ее во время установки). Таким образом часть-2 NTLDR узнает, что ей нужно перейти на второй раздел.

-

-

Часть-2 NTLDR переходит ко второму разделу, что означает просто переход к части-1 загрузчика GRUB во втором разделе (загрузчик bootstrap).

-

Часть-1 GRUB (загрузка bootstrap / 440 байт) снова крошечная, поэтому она снова перейдет в большее пространство, которое является частью-2 GRUB (загрузчик bootloader).

-

Часть-2 знает, где находится часть-3. Местоположение части-3 будет жестко запрограммировано в части-2, поэтому она просто перейдет к части-3. Часть-3 прочитает текстовый файл

/rpool/boot/grub/menu.lst(см. рисунок 2-25); это тот же файл, который был создан OpenSolaris при обнаружении XP на первом основном разделе.

Рисунок 2-25. Файл

menu.lstOpenSolaris -

Часть-3 GRUB прочитает этот текстовый файл и распечатает все, что написано после переменной

title, и именно так мы доберемся до экрана, показанного на рисунке 2-26.

Рисунок 2-26. Экран приветствия OpenSolaris.

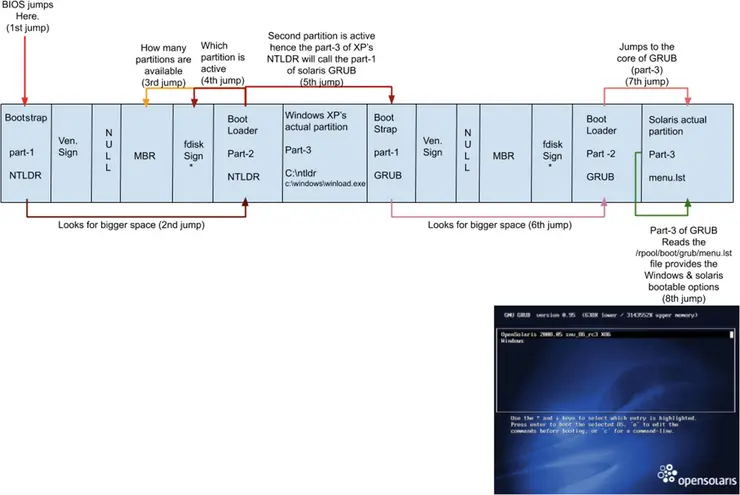

На рисунке 2-27 показана полная последовательность загрузки OpenSolaris.

Рисунок 2-27. Последовательность загрузки OpenSolaris

Если пользователь выбирает для загрузки вариант OpenSolaris, то часть-3 OpenSolaris GRUB знает, где находится ядро OpenSolaris — в каталоге /boot. GRUB скопирует ядро из /boot в память и передаст управление ядру. На этом задача загрузчика GRUB заканчивается и он исчезает. Теперь ядро OpenSolaris позаботится об остальной части загрузки. Мы поговорим о ядре в главе 4.

Если пользователь выбирает вариант загрузки Windows XP, то часть-3 OpenSolaris GRUB вернется к части-1 NTLDR (загрузчик bootstrap). Часть-1 NTLDR перейдет в часть-2 NTLDR. Часть-2 перейдет в часть-3. Часть-3 NTLDR загрузит winload.exe в память. Файл winload.exe знает, где находится ядро XP. В конечном итоге NTLDR скопирует или загрузит его в память. Как только ядро окажется в памяти, работа NTLDR будет завершена (помните, kernel=OS=kernel). Поскольку ядро XP находится в памяти, оно позаботится об остальной части последовательности загрузки.

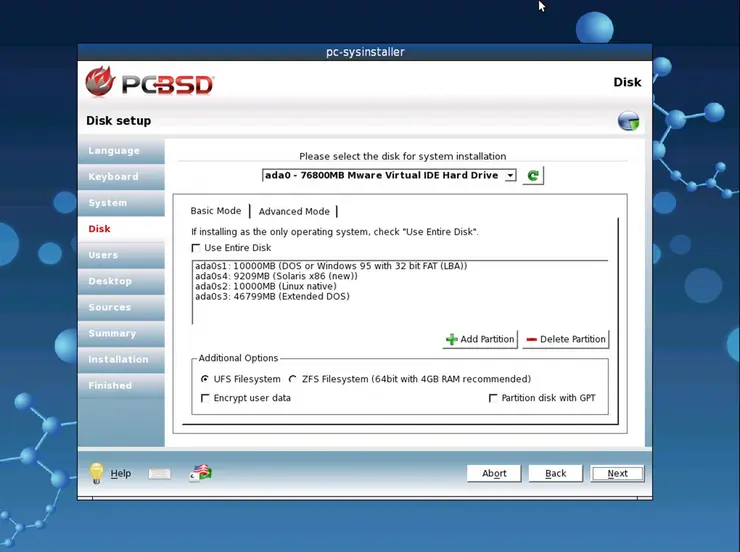

PC-BSD 9.0

Звездочка * или флаг загрузки находится в разделе OpenSolaris, поэтому теперь мы установим PC-BSD 9.0. На рисунке 2-28 программа установки PC-BSD показывает количество разделов, на которые можно установить PC-BSD 9.0.

Рисунок 2-28. Количество разделов

Как видите, соглашение об именах жестких дисков в BSD отличается от более ранних ОС. Нам нужно установить BSD на третий раздел — ada0s2. Это означает «Адаптер номер ноль и номер слайса 2». Слайс можно рассматривать как раздел. На рисунке 2-29 показана структура диска и соглашения об именовании дисков.

Рисунок 2-29. Структура диска и соглашения об именовании дисков

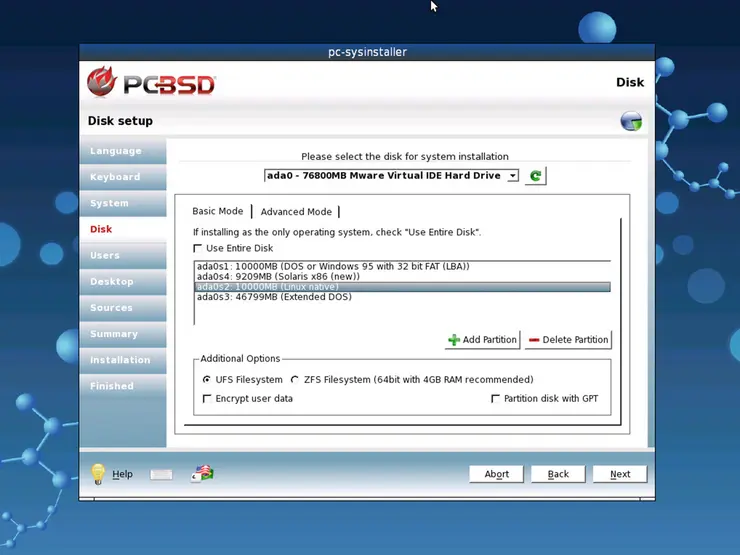

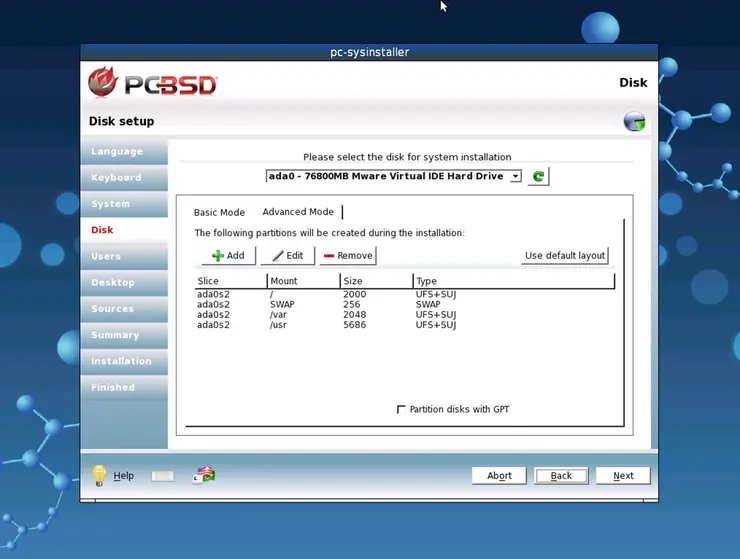

Назначьте пространство ada0s2 как / (корневая файловая система). На рисунке 2-30 показана структура разделов PC-BSD 9.0. Вы также заметите, что файловая система BSD — UFS, то есть файловая система Unix.

Рисунок 2-30. Структура разделов PC-BSD 9.0

После установки система перезагрузится. Теперь потратьте немного времени и подумайте, какая ОС будет загружаться.

Какой из нижеперечисленных вариантов это будет?

OpenSolaris, который даст возможность загружать Windows и BSD.

Будет ли это PC-BSD, который даст возможность загружать две другие ОС?

Будет ли это только PC-BSD?

Будет ли это только Windows XP?

Будет ли это только OpenSolaris?

Или ни одна операционка не загрузится?

Ознакомьтесь с блок-схемами загрузки более ранних операционных систем и попытайтесь придумать собственную последовательность загрузки.

Как вы можете видеть на рисунке 2-31, будет загружаться ОС OpenSolaris, что позволит загрузить дополнительно только Windows.

Рисунок 2-31. PC-BSD не загружается

PC-BSD не загружается. Прежде чем перейти к следующей странице, снова выделите немного времени и подумайте о том, что произошло.

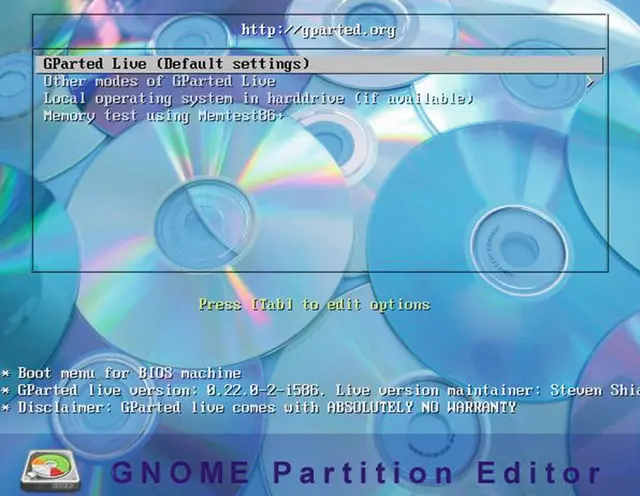

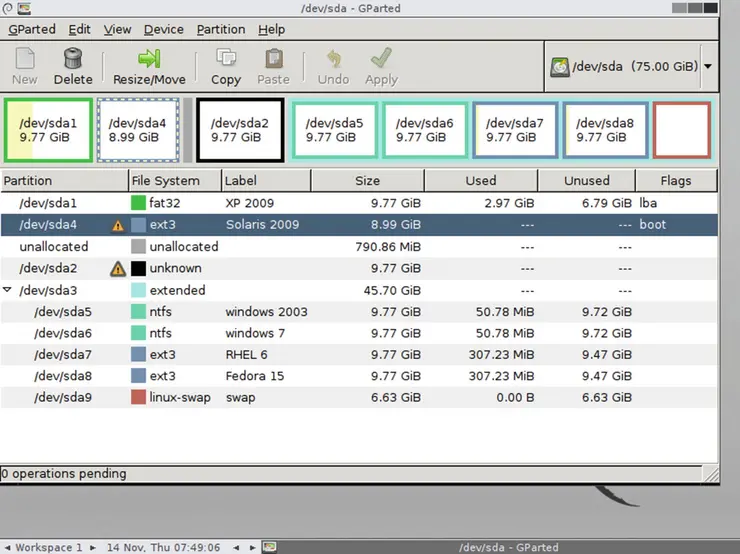

Вы правы: есть вероятность, что PC-BSD не сохранила сигнатуру * флага активности для своего собственного раздела. Посмотрим, так ли это. Мы загрузимся с помощью GParted (рисунок 2-32) и проверим нашу теорию.

Рисунок 2-32. Экран приветствия GParted

Как вы можете видеть на рисунке 2-33, PC-BSD не имеет установленного значения * в собственном разделе.

Рисунок 2-33. Структура диска в GParted

Итак, последовательность загрузки выглядит так, как показано на рисунке 2-34.

Рисунок 2-34. Последовательность загрузки и почему PC-BSD не может загрузиться

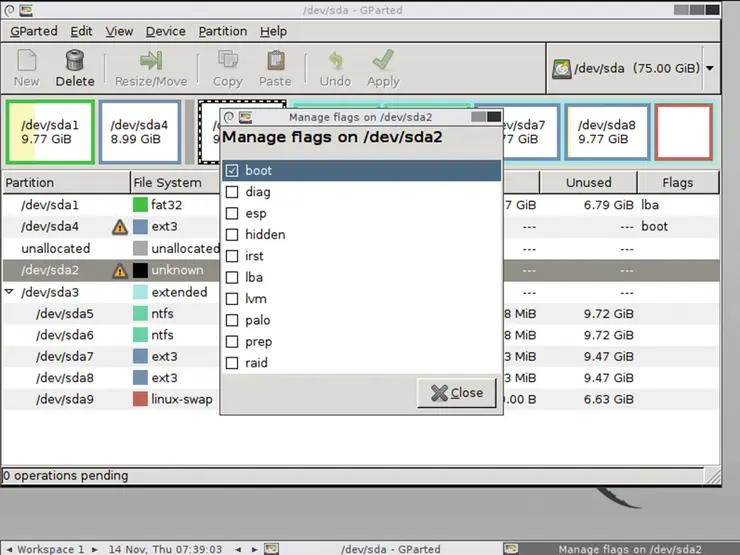

Это означает, что OpenSolaris не знает, что BSD установлен в третьем разделе. Следовательно, запись PC-BSD не относится к OpenSolaris. Что, если мы сохраним флаг загрузки на разделе BSD? Будет ли он загружаться? Но как нам сохранить флаг загрузки на третьем разделе? Все просто — GParted дает нам такую возможность. Щелкните правой кнопкой мыши третий раздел и выберите флаг загрузки, как показано на рисунке 2-35.

Рисунок 2-35. Установка флага загрузки на PC-BSD

На рисунке 2-36 показано, как выглядит структура диска после установки флага загрузки в третьем разделе BSD.

Рисунок 2-36. Схема диска

Как вы думаете, какая ОС будет загружаться?

Только PC-BSD?

PC-BSD, который даст возможность загружать любую другую ОС?

Опять OpenSolaris, который позволит загружать Windows?

Только OpenSolaris?

Только Windows XP?

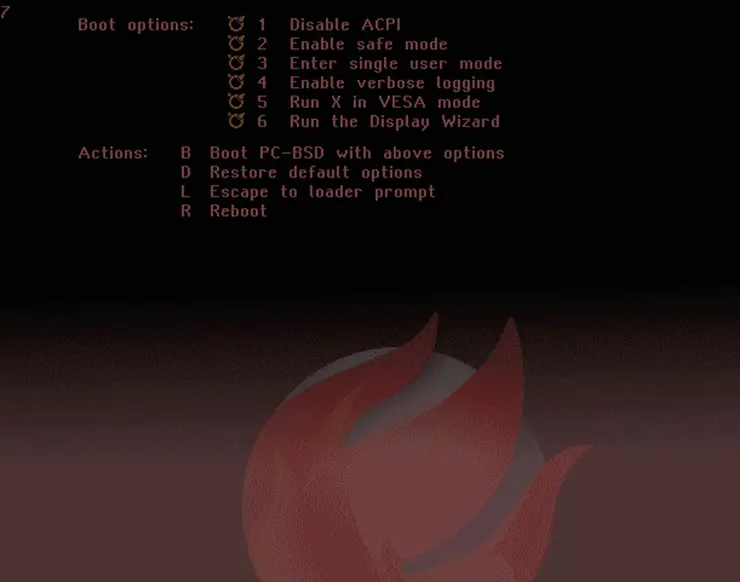

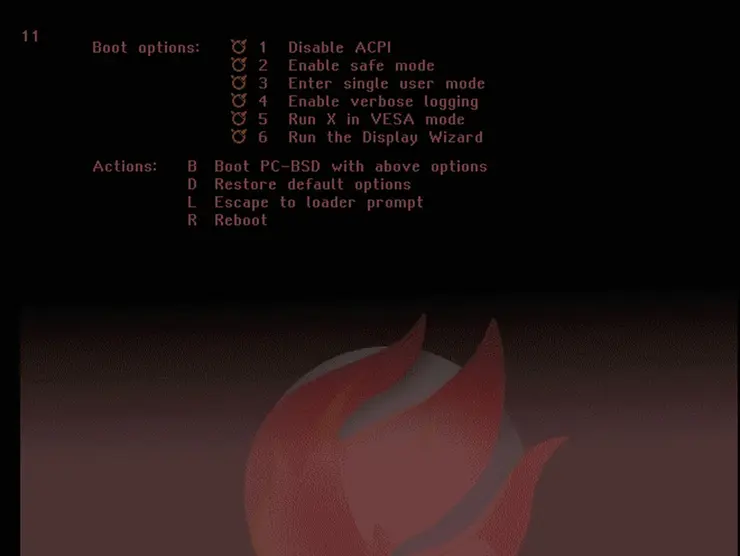

На рисунке 2-37 показан ответ; после перезагрузки загружается только PC-BSD, и он не дает возможности загрузить какую-либо другую ОС.

Рисунок 2-37. Экран приветствия PC-BSD

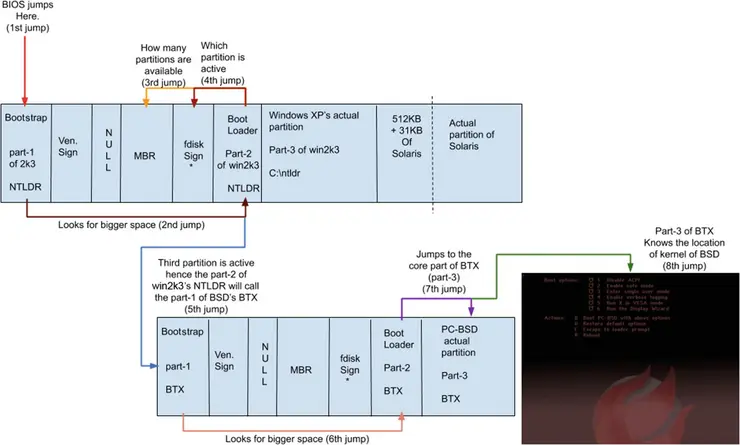

Давайте попробуем понять, как удалось загрузиться PC-BSD.

-

Включение системы.

-

BIOS выполняет процедуру POST. POST проверяет состояние оборудования и подает звуковой сигнал, если все в порядке, и возвращается в BIOS.

-

BIOS тупой, и он просто перескакивает на первый сектор всего HDD, который является загрузчиком bootstrap Windows XP.

-

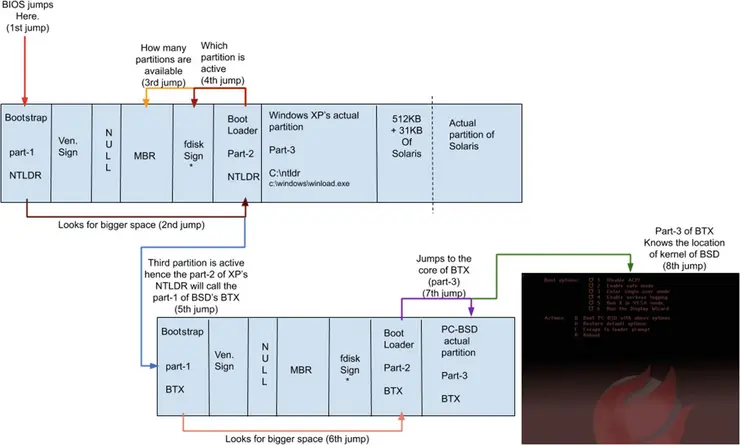

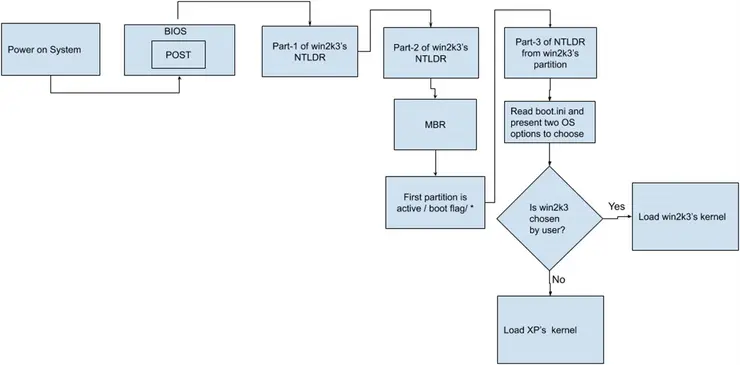

XP часть-1 (NTLDR) переходит в большее пространство, которое является частью-2 NTLDR (загрузчик bootloader). Загрузчик проверяет MBR и обнаруживает, что существует четыре основных раздела, но какой из них активен? Чтобы это проверить, загрузчик проверяет сигнатуру fdisk первого основного раздела, которая не установлена, а затем проверяет флаг загрузки второго раздела, который также не установлен. Следовательно, он переходит к третьему разделу, где обнаруживает установленный флаг загрузки. Загрузчик bootloader (часть-2) NTLDR переходит к разделу BSD и запускает загрузчик bootstrap загрузчика bootloader BSD. Загрузчиком bootloader BSD является BTX, что означает Boot Extended. BTX переходит ко второй части и, в конечном итоге, к третьей части. Третья часть BTX знает, где находится ядро BSD. Часть-3 BTX копирует образ ядра BSD в память, и на этом этапе BTX останавливается, а PC-BSD начинает загружаться и показывает нам экран приветствия. На рисунке 2-38 показана блок-схема последовательности загрузки PC-BSD.

Рисунок 2-38. Последовательность загрузки PC-BSD

Интересная часть загрузки BSD заключается в том, что при установке PC-BSD флаг загрузки был обнаружен на втором разделе, то есть разделе OpenSolaris. И у BSD есть три варианта:

-

Сохранить флаг загрузки в собственном третьем разделе.

-

Сохранить флаг загрузки в собственном третьем разделе и сделать запись OpenSolaris в некоторых его файлах.

-

Сохранить флаг загрузки на прежнем месте, на втором разделе.

Если BSD выберет первый вариант (а), то только BSD сможет загрузиться, и это будет несправедливо по отношению к другим установленным операционным системам. Мы хотим, чтобы BSD выбрала второй вариант (b), поскольку это позволит загружать любую другую ОС, но BTX — это старый загрузчик, и он не имеет возможности мультизагрузки других операционных систем. Следовательно, BSD выбирает третий вариант (c). Таким образом, загружается только OpenSolaris, и он предоставляет возможность загрузки XP. Помните, XP сразу не загружается. Загружается только OpenSolaris, и, прочитав файл menu.lst, он дает возможность загрузить XP. Это также означает, что сам BSD решил не загружаться.

Что, если мы вернемся и сохраним флаг загрузки на первом разделе Windows XP? Тогда какая ОС будет загружаться? На рисунке 2-39 мы добились этого.

Рисунок 2-39. Последовательность загрузки PC-BSD

Будет загружаться только Windows XP, и последовательность загрузки проста. На рисунке 2-40 показано, как загружается Windows XP.

Рисунок 2-40. Последовательность загрузки Windows XP

Перед установкой новой ОС нам необходимо переместить флаг загрузки из третьего раздела BSD во второй раздел OpenSolaris. На рисунке 2-41 показано изменение флага загрузки с раздела XP на раздел OpenSolaris.

Рисунок 2-41. Структура диска из GParted

После этого изменения начнет загружаться OpenSolaris, а вместе с этим будет загружаться и Windows XP, но BSD загрузиться не сможет. Означает ли это, что каждый раз, когда мы загружаем BSD, нам нужно возвращать флаг загрузки в раздел BSD? На данный момент да, но мы автоматизируем все это с помощью загрузчиков.

Windows Server 2003

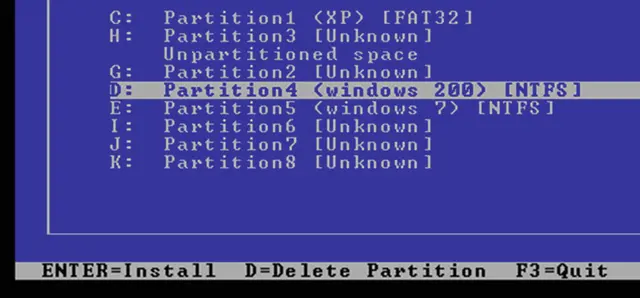

Как вы можете видеть на рисунке 2-42, мы установим Windows Server 2003 (win2k3) в первый логический раздел. Для win2k3 это диск D:.

Рисунок 2-42. Схема диска, показанная установщиком win2k3

Как вы думаете, после установки какая ОС будет загружаться?

Только Win2k3?

Будет ли win2k3 предоставлять возможность загрузки любой другой ОС?

win2k3 и OpenSolaris?

PC-BSD?

Только XP?

Win2k3 и XP?

Прежде чем продолжить, подумайте немного и придумайте свой ответ.

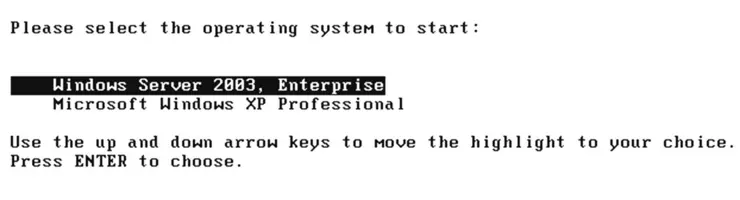

Как вы можете видеть на рисунке 2-43, будет загружаться операционная система win2k3.

Рисунок 2-43. Экран приветствия win2k3 после перезагрузки

И win2k3 дает возможность загружать Windows XP. Это означает, что загружается только семейство операционных систем Windows. Кроме того, вот несколько вопросов, которые нам следует рассмотреть:

-

Где сейчас находится флаг загрузки?

-

Какая ОС загрузится, если мы сохраним флаг загрузки на втором разделе?

-

Какая ОС загрузится, если мы сохраним флаг загрузки на третьем разделе?

-

Какая ОС будет загружаться, если мы сохраним флаг загрузки на логическом разделе (разделе win2k3)?

-

Есть ли способ загрузить только Windows XP?

Все ответы на эти вопросы вы получите в следующем обсуждении.

Здесь ясно одно: win2k3 — единственная загружающаяся ОС. Прежде чем обсуждать, как она может загружаться, нам нужно проверить, какой сценарий win2k3 создал на диске для успешной загрузки.

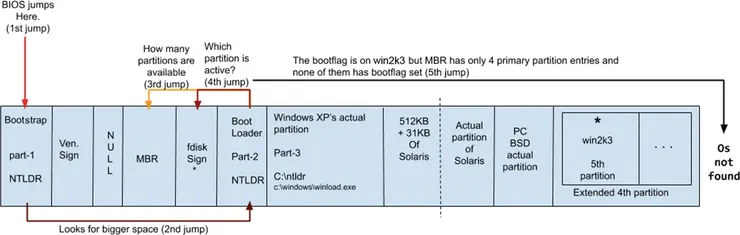

Когда win2k3 устанавливался, он увидел, что он устанавливается в логический раздел и что флаг загрузки находится в разделе OpenSolaris (см. рисунок 2-44).

Рисунок 2-44. Структура диска при установке Win2k3

Для загрузки win2k3 должен установить флаг загрузки в свой собственный раздел, установив часть-1 и часть-2 своего загрузчика (опять же NTLDR) в свои собственные 512 байт + 31 КБ. Но здесь есть проблема. Помните правила, которые мы видели во время установки Windows XP?

Логический раздел не может быть активным.

ОС не может загружаться с логического раздела.

Из-за этих двух правил win2k3 не может сохранять флаг загрузки на своем собственном разделе и, в конечном итоге, не может загружаться с логического раздела. На рисунке 2-45 показана последовательность загрузки, объясняющая, почему Win2k3 не может загрузиться с логического раздела. Но в чем причина таких правил?

Рисунок 2-45. Последовательность загрузки Win2k3, если он пытается загрузиться из логического раздела

Все просто: в MBR всего четыре записи, а именно:

Первый основной = sda1

Второй основной = sda2

Третий основной = sda3

Четвертый основной = расширенный раздел (не логический раздел) = sda4

Раздел win2k3 — sda5. Другими словами, это SATA диск a (первый) и раздел номер 5. Поскольку в MBR нет записи для логического раздела, часть-2 NTLDR XP не знает, что доступен пятый раздел. Таким образом, даже если win2k3 сохраняет флаг загрузки в своем собственном разделе, NTLDR XP не может его увидеть. Следовательно, win2k3 никогда не загрузится. Теперь почему в MBR не может быть более пяти записей? Это потому, что 64 байта могут хранить только четыре записи. Почему бы не увеличить размер MBR? На самом деле, даже если разработчики захотят увеличить размер MBR, они просто не смогут. Вы поймете причину, когда мы поговорим о прошивке UEFI далее в этой главе.

Теперь для Win2k3 это стало проблемой курицы и яйца. Он хочет загрузиться, но для этого ему необходимо сохранить флаг загрузки на своем собственном разделе, но если он это сделает, то BIOS не сможет увидеть этот раздел. Как нам решить эту проблему?

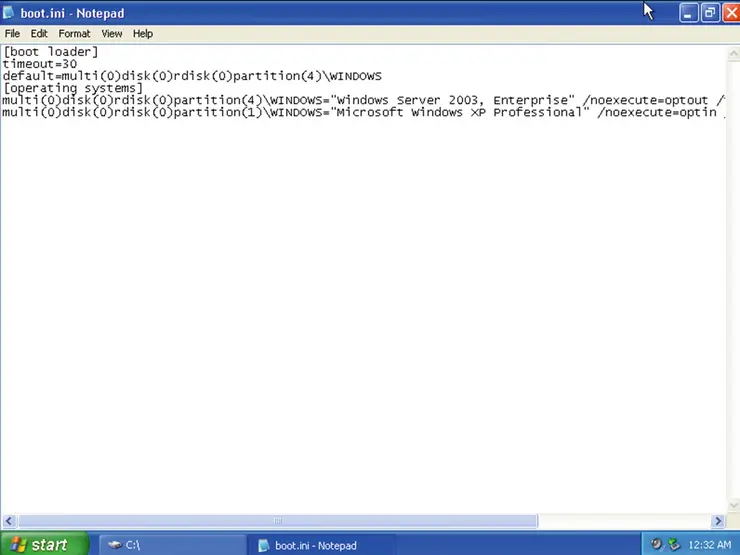

Некоторые замечательные разработчики решили эту проблему, а тот, кто придумал эту идею, просто легенда. win2k3 переносит свой загрузчик NTLDR на первый основной раздел, что означает часть-1, часть-2 и часть-3. Это также означает, что win2k3 удалит все части XP NTLDR, поскольку пространство (512 байт + 31 КБ) очень маленькое и оба загрузчика туда не поместятся. (Здесь есть некая точка, называемая VBR, которая выходит за рамки этой книги.) Однако при удалении загрузчик XP win2k3 вносит запись XP в один из своих текстовых файлов и сохраняет ее в первом основном разделе. Файл называется boot.ini, как показано на рисунке 2-46.

Рисунок 2-46. Файл boot.ini

При этом win2k3 сохраняет флаг загрузки только для первого основного раздела. Итак, вот как загружается win2k3:

-

Включение системы.

-

Процессор переходит в BIOS. BIOS запускает POST.

-

POST проверяет, оборудование подает звуковой сигнал и возвращается в BIOS.

-

BIOS переходит к первым 512 байтам первого основного раздела.

-

Начнется загрузка, которая является частью NTLDR для Win2k3.

-

Часть-1 находит часть-2 NTLDR.

-

Часть-2 проверяет MBR и подпись fdisk.

-

Сигнатура fdisk устанавливается на первом первичном разделе, что означает, что часть-2 перейдет внутрь первого основного раздела XP и будет запускать часть-3 NTLDR Win2k3. Чтобы дать вам представление: часть-3 — это новая версия, а не старый NTLDR XP. Здесь я привожу два изображения.

-

Обратите внимание на размер NTLDR (часть-3) на рисунке 2-47. Это когда мы установили Windows XP.

Рисунок 2-47. Размер файла NTLDR части-3 для Windows XP

-

На рисунке 2-48 обратите внимание на размер NTLDR (часть-3) после установки win2k3.

Рисунок 2-48. Размер файла NTLDR части-3 для win2k3

Как видите, часть-3 NTLDR в Windows XP составляла 245 КБ, но теперь с win2k3 она составляет 291 КБ.

-

-

Часть-3 NTLDR (win2k3) будет читать файл

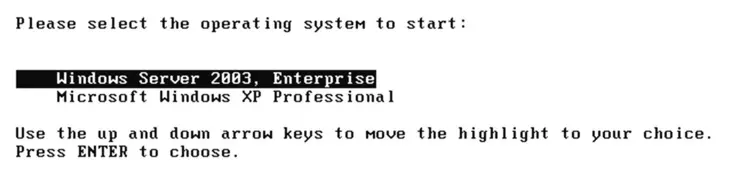

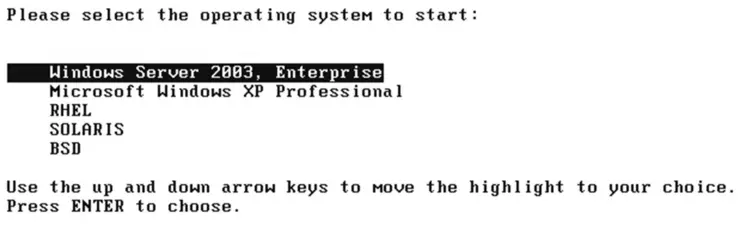

boot.iniиз того же раздела (первого основного) и напечатает все, что написано в кавычках. На рисунке 2-49 показано, что будет напечатано на экране.

Рисунок 2-49. Экран приветствия, отображаемый win2k3

-

Если пользователь выбирает вариант Windows Server 2003, Enterprise, то третья часть NTLDR Win2k3 знает, где находится ядро Win2k3. Это пятый раздел, где установлена Win2k3. Она копирует ядро в память, и NTLDR win2k3 исчезает.

-

Если пользователь выбирает вариант Microsoft Windows XP Professional, то часть-3 NTLDR также знает, где находится ядро Windows XP. Это первый основной раздел. Сначала запускается

winload.exe; в конечном итогеwinload.exeкопирует ядро XP в память, и NTLDR исчезает. На рисунке 2-50 показана полная последовательность загрузки Windows XP.

Рисунок 2-50. Последовательность загрузки Windows XP

Итак, вот как могут загружаться Windows XP и win2k3. Давайте вернемся к обсуждению сигнатур fdisk; поскольку загружается только Win2k3, а другие ОС не могут загружаться, у меня есть несколько вопросов:

Можем ли мы загрузить только Windows XP?

Что, если мы сохраним флаг загрузки в OpenSolaris?

Что, если мы сохраним флаг загрузки в PC-BSD?

Что, если мы нигде не сохраним флаг загрузки?

Не торопитесь, подумайте, просмотрите блок-схемы и придумайте свой ответ.

Готовы? Мы не можем загрузить только Windows XP. Это просто невозможно, поскольку в загрузчиках Windows XP все части заменены на NTLDR Win2k. Кроме того, теперь только Win2k3 знает, где находится XP, и только Win2k3 может загружать Windows XP. Это также означает, что если часть-1 загрузчика Win2k3 будет повреждена или удалена, мы потеряем XP навсегда. Но если мы сохраним флаг загрузки на PC-BSD, то он загрузится как обычно. На рисунке 2-51 показана последовательность загрузки PC-BSD.

Рисунок 2-51. Последовательность загрузки PC-BSD

Если мы не сохраним флаг загрузки ни на одном из разделов, то никто просто не загрузится. Это похоже на ситуацию, которую мы обсуждали, говоря о том, что произойдет, если на логическом разделе будет установлен флаг загрузки. На рисунке 2-52 показана последовательность загрузки, объясняющая, почему ни одна из операционных систем не может загрузиться.

Рисунок 2-52. Последовательность загрузки, показывающая, почему ни одна из ОС не может загрузиться

Установка флага загрузки в логическом разделе так же эффективна, как и отсутствие установки флага загрузки где-либо еще.

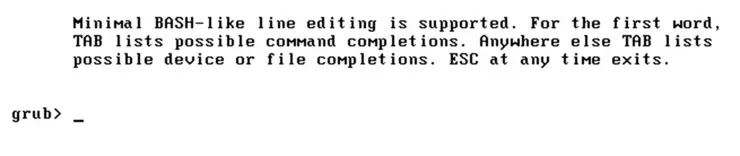

Теперь главный вопрос: что, если мы сохраним флаг загрузки на разделе OpenSolaris? OpenSolaris не сможет загрузиться. Загрузчик OpenSolaris, которым является GRUB, выдаст сообщение об ошибке, показанное на рисунке 2-53.

Рисунок 2-53. GRUB удален по запросу

Но почему? Он должен загрузиться, верно? В OpenSolaris ничего не менялось (512 байт + 31 КБ). Просто win2k3 перенесла флаг загрузки с раздела OpenSolaris на первый основной. Итак, в идеале он должен загрузиться, но не получается, и причина в поведении win2k3. Когда устанавливалась ОС win2k3, она столкнулась с ситуацией, аналогичной той, с которой столкнулись OpenSolaris и PC-BSD. Другими словами, флаг загрузки находится на другом разделе, и на этом разделе установлена другая ОС. Что OpenSolaris сделал в этой ситуации, так это переместил флаг загрузки из раздела XP на свой второй раздел, но, поскольку это сделает XP незагружаемой, он великодушно сделал запись для XP в своем собственном файле (menu.lst). OpenSolaris каждый раз читает этот файл и дает XP равные шансы на загрузку.

В случае PC-BSD он обнаруживает, что флаг загрузки установлен на OpenSolaris, и если его переместить в отдельный раздел, OpenSolaris станет незагружаемым. Следовательно, BSD великодушно решила не ставить флаг загрузки на свой раздел, чтобы другая ОС не стала незагружаемой. Но win2k3 не настолько щедр. Когда win2k3 устанавливался, он увидел, что флаг загрузки находится в ОС, отличной от Windows. Таким образом, он переместил флаг загрузки OpenSolaris, но, поскольку это операционная система, отличная от Windows, он не создал запись в boot.ini. Идя дальше, win2k3 даже повредил/удалил первую часть OpenSolaris GRUB. Следовательно, OpenSolaris сейчас не может загрузиться.

Позже win2k3 пошел дальше и очистил загрузчик XP, но он сделал запись для XP в boot.ini, поскольку это операционная система Windows. Вот почему я сказал, что win2k3 не обладает той щедростью, которую демонстрируют OpenSolaris и PC-BSD. Но мы исправим OpenSolaris в разделе «Настройка GRUB» этой главы.

Windows 7

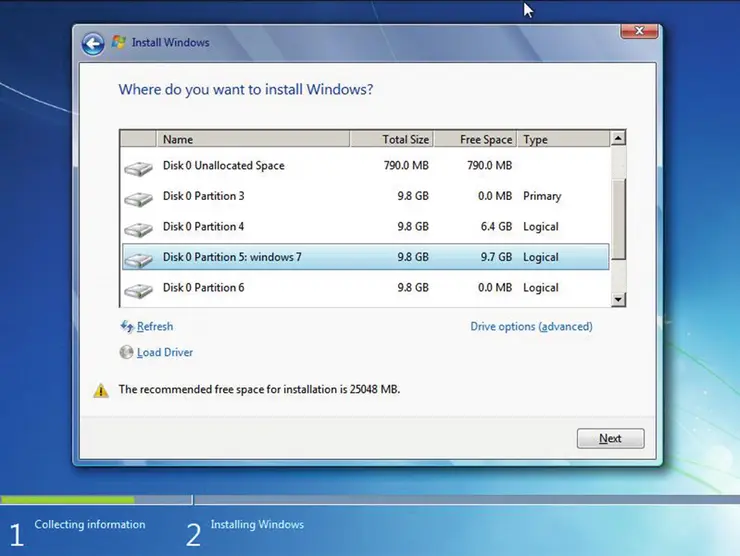

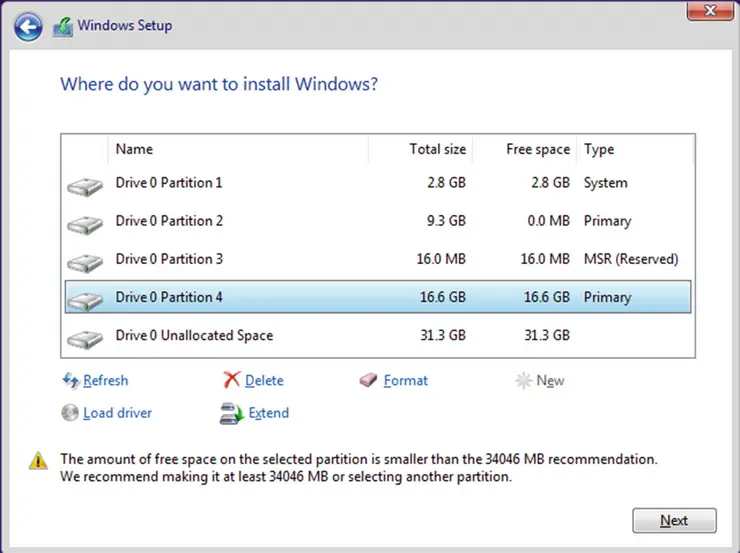

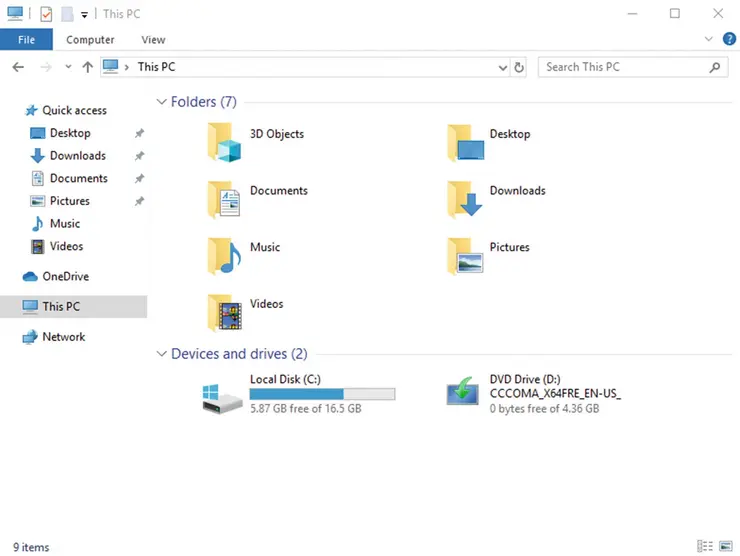

Как вы можете видеть на рисунке 2-54, мы устанавливаем Windows 7 в пятый раздел.

Рисунок 2-54. Схема диска, показанная установщиком Windows 7

Windows не показывает расширенный раздел, чтобы избежать путаницы для простых пользователей настольных компьютеров.

Как вы думаете, какая ОС после установки загрузится? Как обычно, не торопитесь и придумайте свой ответ, прежде чем перейти к рисунку 2-55.

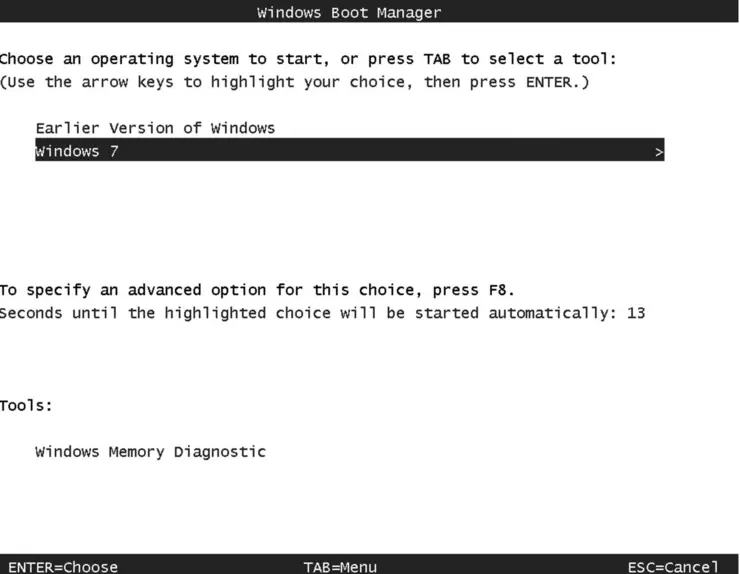

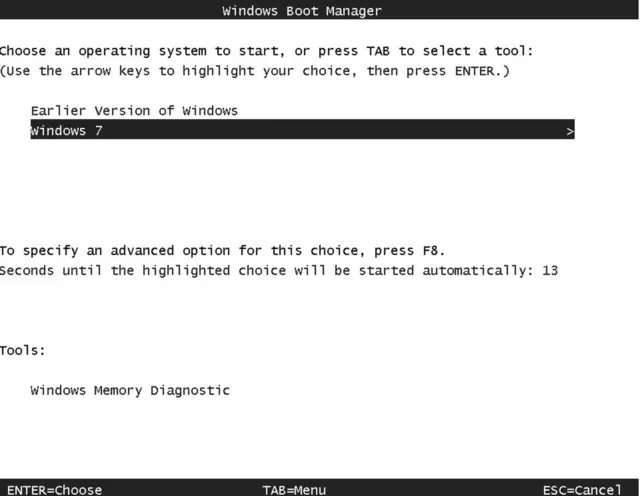

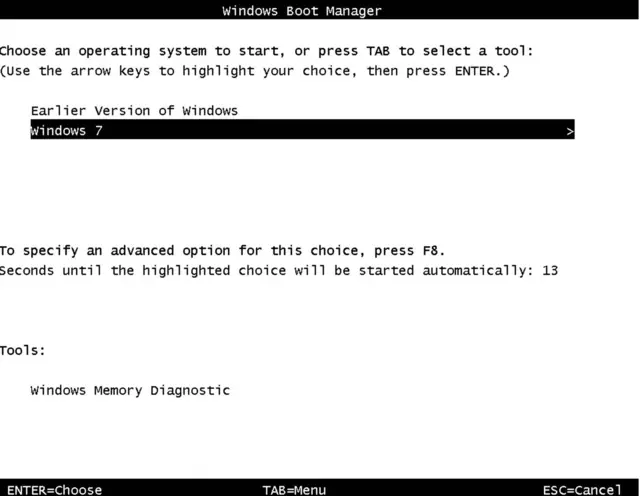

Рисунок 2-55. Экран приветствия в Windows 7

Вы угадали: Windows 7 загрузится. Ниже приведена полная последовательность загрузки Windows 7:

-

Включение системы.

-

Процессор переходит в BIOS.

-

После процедуры POST BIOS переходит к первому сектору всего жесткого диска.

-

Когда устанавливалась Windows 7, символ

*был на первом основном диске, а Windows 7 устанавливалась в логический раздел. Итак, Windows 7 сталкивается с теми же проблемами, что и Win2k3. -

Чтобы сделать себя загружаемой, Windows 7 пойдет по тому же пути, что и win2k3. Windows 7 установит часть-1, часть-2 и часть-3 в первый основной раздел. Часть-3 не обязательно устанавливать на первом основном разделе, поскольку в части-2 жестко запрограммировано расположение части-3, но именно так работает семейство Windows.

-

В процессе установки части-1 и части-2 на первом основном разделе, очевидно, что Windows 7 должна удалить NTLDR win2k3 (часть-1 и часть-2), но при удалении файлов Windows 7 распознает это. win2k3 — операционная система семейства Windows; следовательно, загрузчик Windows 7, называемый Boot Configuration Data (BCD), делает запись для win2k3 в своем собственном файле, который можно увидеть в

bcdedit.exe. Посмотрите на рисунок 2-56, чтобы увидеть выходные данныеbcdedit.exe.«Windows Legacy OS Loader» на рисунке 2-56 означает win2k3.

Рисунок 2-56. Вывод

bcdedit.exe -

Итак, возвращаясь к последовательности загрузки, она выглядит следующим образом: BIOS ➤ POST ➤ BIOS ➤ первый сектор жесткого диска.

-

Первые 440 байт загрузчика bootstrap — это часть-1 загрузчика BCD Windows 7. Он будет искать большее пространство, которое является частью-2 BCD.

-

Часть-2 BCD прочитает MBR и узнает, что на этом жестком диске есть четыре основных раздела, но чтобы проверить, какой из них активен, она начнет проверять сигнатуру fdisk каждого раздела, но обнаружит, что сам же первый основной раздел и активен.

-

Часть-2 перейдет внутрь первого основного раздела, где хранится часть-3 загрузчика BCD Windows 7. Часть-3 прочитает файл конфигурации загрузчика через

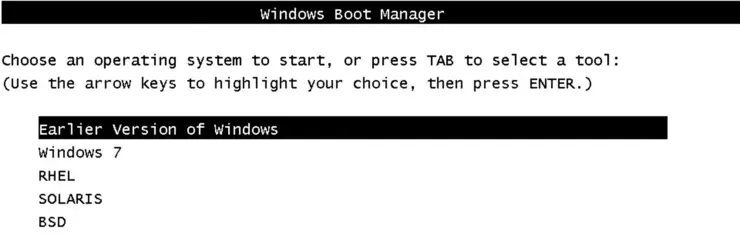

bcdedit.exeи выведет список записей, упомянутых перед переменной описания. На рисунке 2-57 показано, что появится на экране.

Рисунок 2-57. Экран приветствия в Windows 7

-

Если пользователь выбирает Windows 7, то, как вы можете видеть в

bcdedit.exe, часть-3 BCD вызоветwinload.exeизC:\windows\systemd32. Помните, что здесьC:означает раздел Windows 7, который является шестым логическим разделом. -

Файл

winload.exeзнает расположение ядра Windows 7. Начнется загрузка ядра в память, и как только это будет сделано, ядро Windows 7 позаботится о дальнейшей последовательности загрузки. Вы можете увидеть анимацию, показанную Windows 7 после начала загрузки, на рисунке 2-58.

Рисунок 2-58. Анимация, отображаемая Windows 7 во время загрузки

На рисунке 2-59 показана полная блок-схема последовательности загрузки Windows 7.

Рисунок 2-59. Последовательность загрузки Windows 7

-

Если пользователь выберет более раннюю версию Windows, то часть-3 BCD вызовет часть-3 NTLDR, которая находится только в первом основном разделе, и последовательность загрузки продолжится, что мы видели в Win2k3. Рисунок 2-60 объясняет последовательность загрузки win2k3 и XP.

Рисунок 2-60. Последовательность загрузки win2k3 и XP

Red Hat Enterprise Linux 6 (RHEL 6)

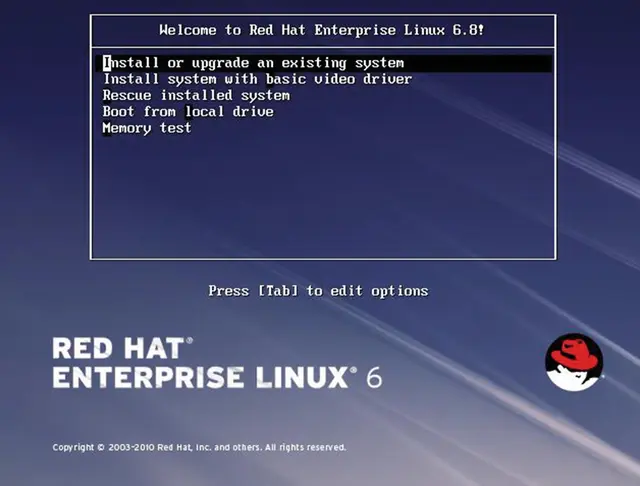

Имя установщика RHEL — Anaconda. Установщик Anaconda используется всеми дистрибутивами на базе Fedora. На рисунке 2-61 мы начали установку RHEL 6.

Рисунок 2-61. Экран приветствия загрузочного носителя RHEL 6

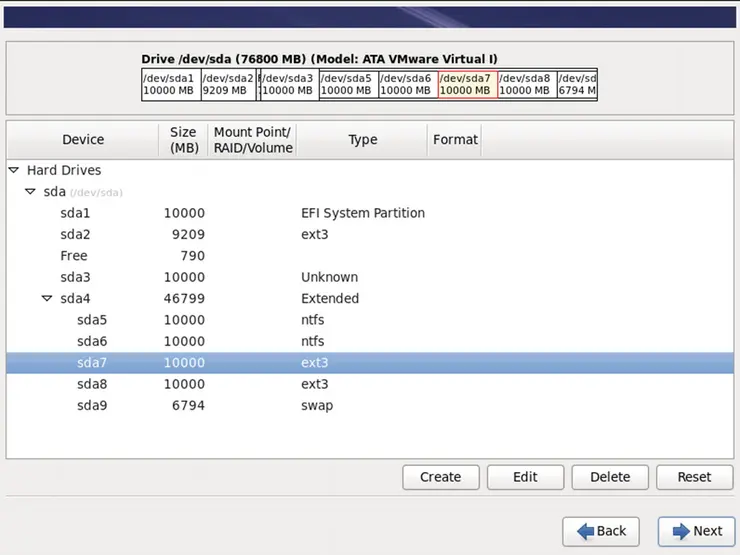

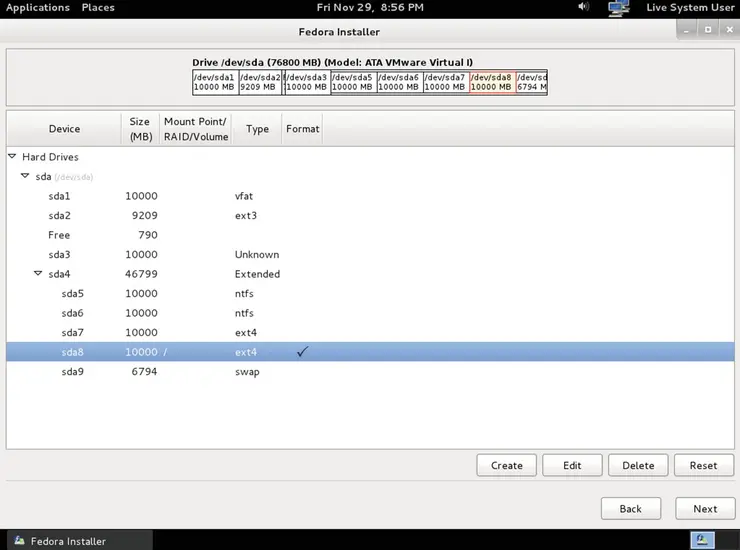

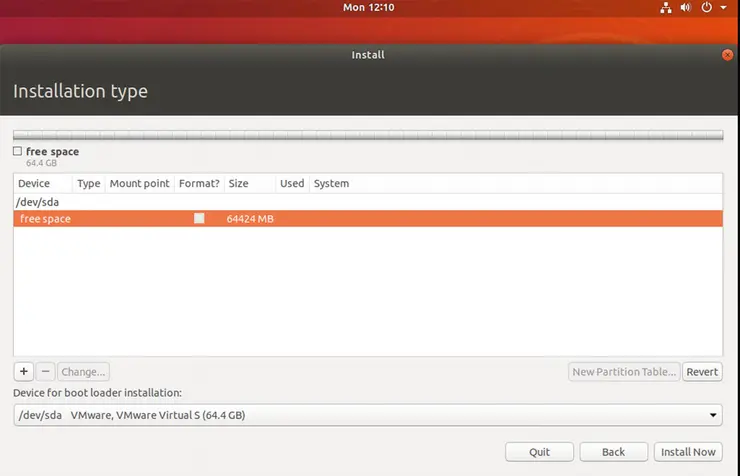

На рисунке 2-62 показано текущее расположение разделов.

Рисунок 2-62. Схема разделов, показанная установщиком Anaconda

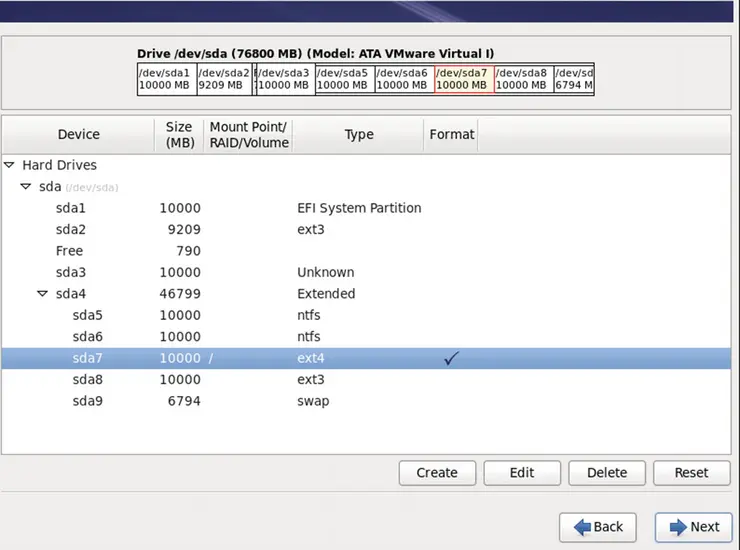

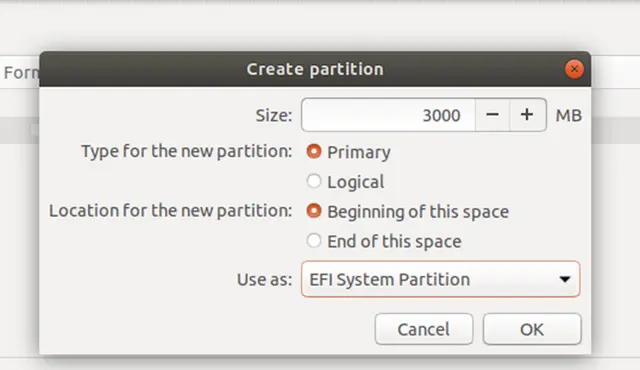

Как показано на рисунке 2-63, нам нужно назначить root (/) разделу sda7 и переформатировать его в ext4, который является выбором файловой системы по умолчанию для RHEL 6.

Рисунок 2-63. Схема разделов, которую реализует Anaconda

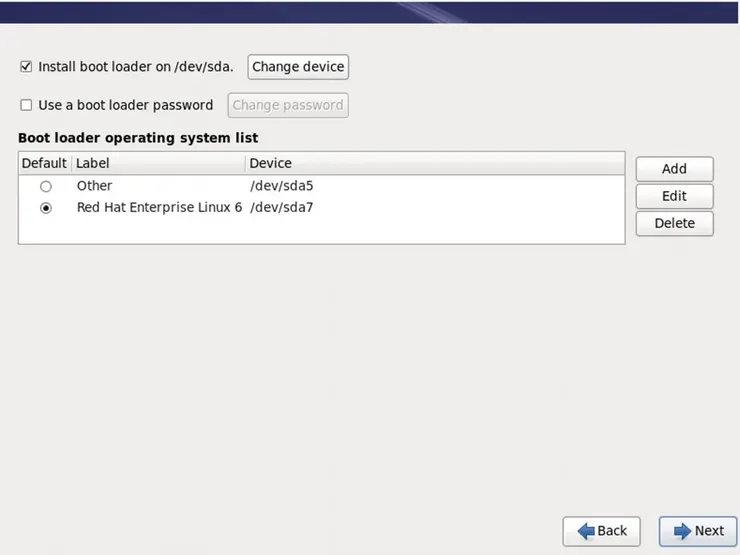

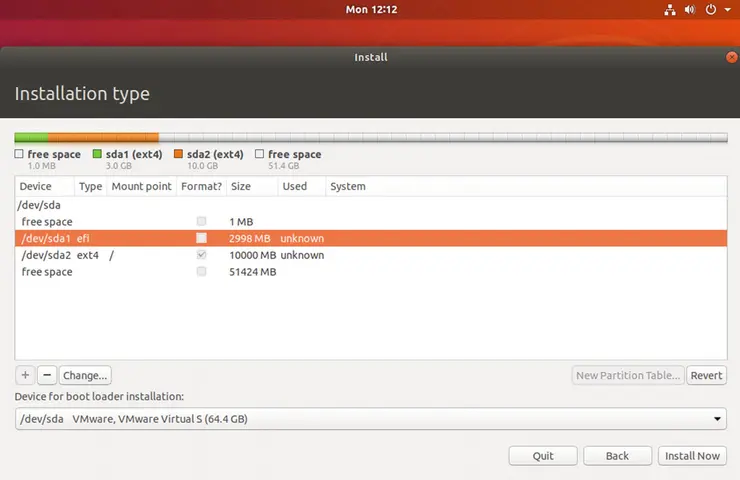

Как видно на рисунке 2-64, RHEL 6 (или Anaconda) обнаружил некоторую ОС и пытается предоставить равные возможности для загрузки другой ОС (указанной как Other). Есть две записи ОС, которые загрузчик RHEL 6 (GRUB) покажет во время загрузки.

Рисунок 2-64. Anaconda обнаруживает другую ОС

Согласно RHEL 6, другая ОС будет загружаться с sda5. Это означает следующее:

sda1 = XP

sda2 = Solaris

sda3 = PC BSD

sda4 = Extended partition

sda5 = Win win2k3 <<<-----------

Если во время загрузки пользователь выбирает вариант Other, предполагается, что загрузится win2k3. Какая ОС загрузится после выбора варианта Other? Не торопитесь и придумайте свою собственную последовательность загрузки.

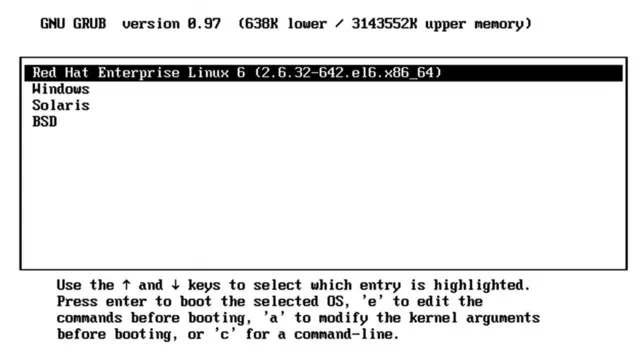

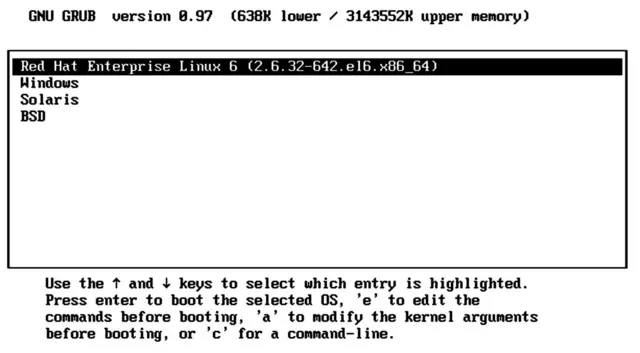

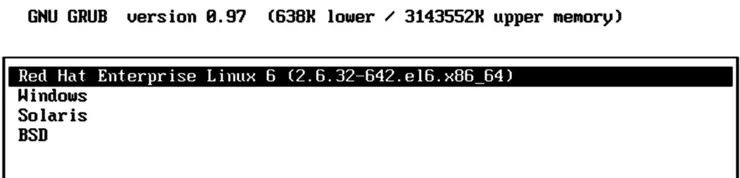

Перезагрузим систему и посмотрим, какая ОС загружается. Как вы можете видеть на рисунке 2-65, загружается RHEL 6, которая дает вам возможность загрузить другую ОС.

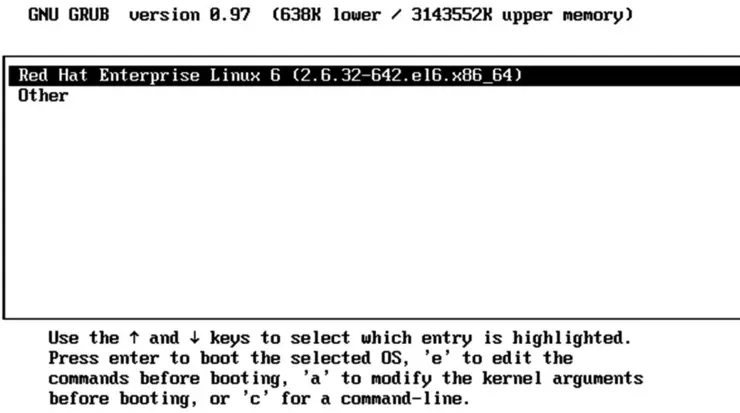

Рисунок 2-65. Экран приветствия RHEL 6

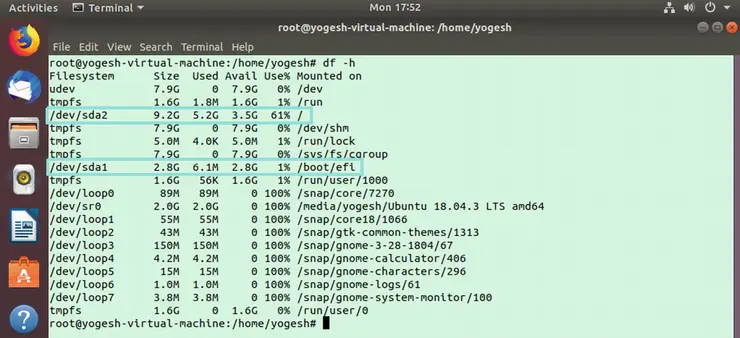

Вот как загружается RHEL 6:

-

Когда система включается, она переходит в BIOS, затем из BIOS в POST и из POST обратно в BIOS.

-

В конечном итоге BIOS попадает в первый сектор всего жесткого диска и запускает загрузку bootstrap.

-

Когда RHEL 6 устанавливался, флаг активного раздела

*был на первом основном разделе. -

Проблема, с которой столкнулись Win2k3 и Windows 7, также встречается и в RHEL 6. RHEL 6 устанавливается в логический раздел, к которому BIOS не может получить доступ или увидеть. Итак, чтобы решить эту проблему, RHEL 6 должен разместить часть-1 и часть-2 загрузчика (GRUB) в первый основной раздел. Помните, что Windows также разместила часть-3 в первый основной раздел, но RHEL (и вообще любая ОС Linux) разместит только первые две части в первый основной раздел, а часть-3 GRUB будет сохранена в собственном разделе; в нашем случае это sda-7.

-

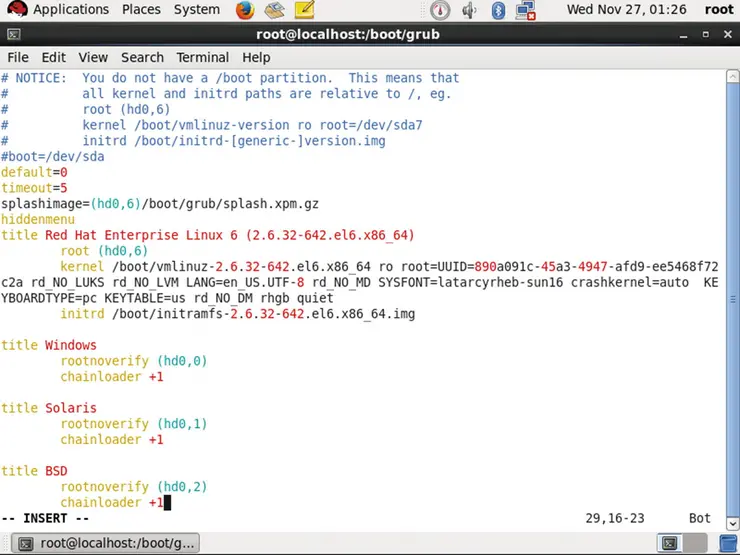

При замене части-1 и части-2 первого основного раздела RHEL заметил, что уже установлена какая-то другая ОС, и, чтобы дать ей равные шансы на загрузку, он сделал запись для нее в файле конфигурации с именем

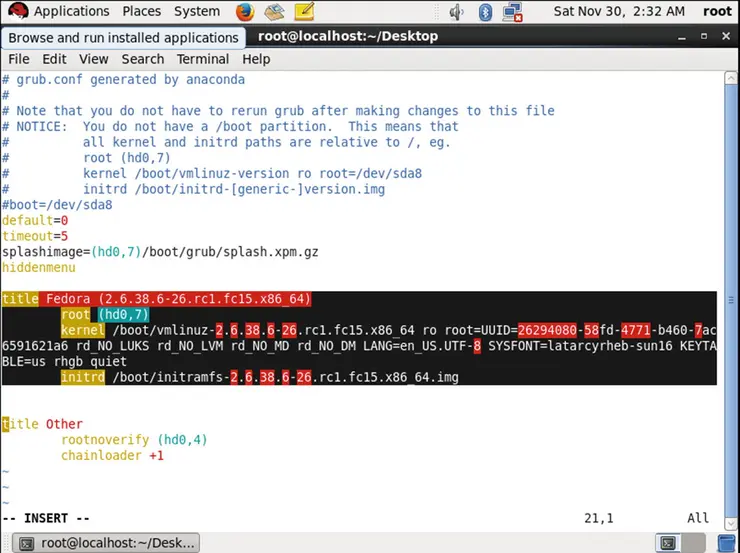

/boot/grub/grub.confсвоего собственного раздела. На рисунке 2-66 показан файлgrub.conf.

Рисунок 2-66. Файл

grub.confКак вы можете видеть, все, что написано после переменной

title, будет напечатано на экране. -

Возвращаясь к последовательности загрузки, загрузка bootstrap в первом основном разделе взята из RHEL.

-

Часть-1 GRUB RHEL перейдет к части-2.

-

В части-2 GRUB жестко запрограммировано расположение части-3 GRUB. Часть-3 GRUB находится в разделе RHEL, sda7.

-

Часть-3 GRUB прочитает файл

grub.confиз каталога/boot/grub, и все, что написано после заголовка, будет напечатано на экране. Рисунок 2-67 показывает это.

Рисунок 2-67. Экран приветствия, отображаемый GRUB в RHEL 6

-

Если пользователь выбирает первую запись, то есть Red Hat Enterprise Linux 6, то третья часть GRUB знает, где находится ядро RHEL. На рисунке 2-68 показан файл

grub.conf.

Рисунок 2-68. Файл

grub.confRHEL 6 -

Двоичный файл ядра будет находиться в

/boot/vmlinuz. (Обратите внимание на переменнуюkernelна рисунке 2-68.) По сути, тот же файлgrub.confсообщает расположение ядра третьей части GRUB. Он скопирует ядро (vmlinuz) в память, и работа загрузчика GRUB будет завершена. Ядро RHEL позаботится о дальнейшей последовательности загрузки. Тем временем, когда система загружается, на экране появится красивая анимация, как показано на рисунке 2-69.

Рисунок 2-69. Анимация для скрытия сложных сообщений журнала

На рисунке 2-70 показана блок-схема полной последовательности загрузки RHEL 6.

Рисунок 2-70. Последовательность загрузки RHEL 6

-

Если же пользователь выберет Other, будет вызываться все, что присутствует в разделе sda5. Как вы можете видеть на рисунке 2-71, sda5 находится в разделе win2k3.

Рисунок 2-71. Другая ОС находится в разделе 5

-

Когда была установлена win2k3, она переместила все части своего загрузчика на первый основной раздел. Это означает, что в разделе win2k3 нет загрузчика, поэтому, конечно, никакая ОС не загрузится. На рисунке 2-72 показано сообщение об ошибке, появляющееся на экране при попытке загрузить другую ОС.

Рисунок 2-72. Сообщение об ошибке

Теперь у меня есть пара вопросов:

-

Где сейчас признак активности раздела

*? -

Если я оставлю

*на втором разделе, какая ОС загрузится? -

Если я оставлю

*на третьем разделе, какая ОС загрузится? -

Если я оставлю

*на пятом (логическом) разделе, какая ОС загрузится? -

Если я не оставлю

*ни на одном из разделов, какая ОС загрузится?

Во всех этих сценариях будет загружаться только одна ОС — RHEL 6 (рисунок 2-73).

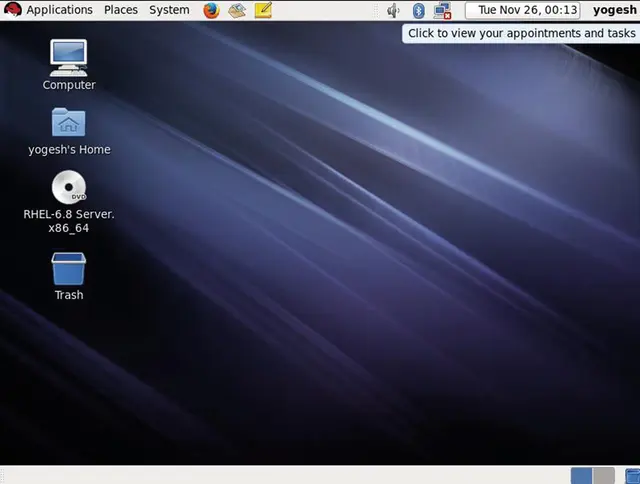

Рисунок 2-73. Экран рабочего стола RHEL 6

Независимо от того, где вы установите * или даже если вы не установите ни на одном разделе, постоянно будет загружаться только RHEL. Причина проста, но она совершенно меняет последовательность загрузки. Загрузчик Red Hat Enterprise Linux, то есть GRUB, не следует за * и не проверяет, какой раздел активен, перед вызовом части-3 своего загрузчика bootloader. На самом деле ни одна из ОС Linux не удосуживается проверять активный раздел. Они просто пропускают этот шаг. Таким образом, последовательность загрузки становится следующей:

-

Сначала система переходит в BIOS, затем POST, затем обратно в BIOS и, наконец, в загрузчик bootstrap первого основного раздела.

-

Часть-1 RHEL GRUB переходит к части-2 GRUB, которая (после пропуска части сигнатуры fdisk) переходит к части-3 GRUB.

-

Часть-3 GRUB переходит в

/boot/grub.conf, где печатаются записи ОС. -

Если пользователь выбирает RHEL, то ядро загружается из

/boot/vmlinuzв память. -

Ядро само позаботится о дальнейшей загрузке ОС, что подробно описано в остальной части книги.

Это также означает, что в данный момент загружается только одна ОС — RHEL 6. Это плохо! Следовательно, нам нужно настроить GRUB для загрузки остальных операционных систем.

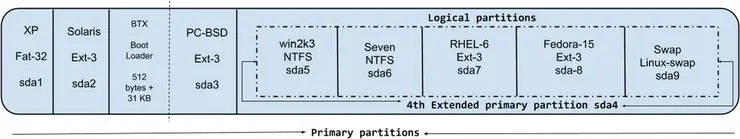

Настройка GRUB

Лучшей особенностью GRUB является то, что он может загружать любую другую ОС, независимо от того, основана она на Linux или нет. Трюк с загрузкой другой ОС, используемой GRUB, прост, но удивителен. Чтобы любой загрузчик мог загрузить ОС, вам не нужно ничего делать, кроме загрузки ядра соответствующей ОС в память. GRUB знает, где находится ядро ОС Linux (/boot/vmlinuz). Но GRUB не знает, где находится ядро Windows или PC-BSD. Хитрость в том, что соответствующие загрузчики этих операционных систем знают расположение своих ядер. Итак, GRUB просто вызывает соответствующие загрузчики; например, если GRUB хочет загрузить BSD, это происходит в третьем основном разделе. Чтобы лучше это понять, обратитесь к рисунку 2-74, на котором показано расположение разделов.

Рисунок 2-74. Структура разделов BIOS

BSD установила свой загрузчик bootloader в зарезервированные 512 байт + 31 КБ своего раздела. Итак, GRUB вызовет часть-1 BTX. Это называется цепной загрузкой (chainloading). Часть-3 загрузчика GRUB будет загружать часть-1 BTX. Часть-1 BTX знает, что делать дальше: искать часть-2. Часть-2 перейдет к части-3 и загрузит ядро BSD в память, после чего BSD начнет загружаться. Чтобы добиться такой цепной загрузки, нам нужно сообщить GRUB расположение первой части BTX через файл grub.conf. Это будет номер жесткого диска 1 и номер раздела 3, но GRUB начинает отсчет с 0, поэтому местом будет номер жесткого диска 0 и номер раздела 2. Запись в /boot/grub/grub.conf выглядит следующим образом:

title pc-bsd <<<---- the os entry title

rootnoverify (hd0,2) <<<---- location of BTX

chainloader +1 <<<---- grub will chainload the BTX

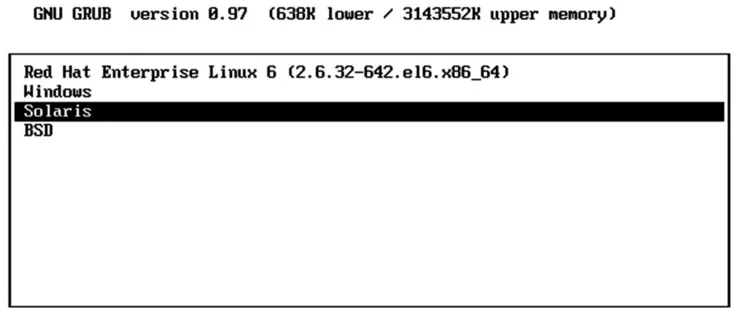

Как вы можете видеть на рисунке 2-75, остальные записи операционной системы аналогичны BSD; изменится только номер раздела.

Рисунок 2-75. Измененный файл grub.conf RHEL 6

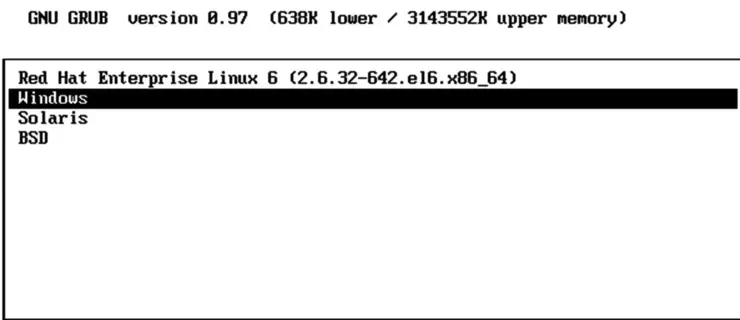

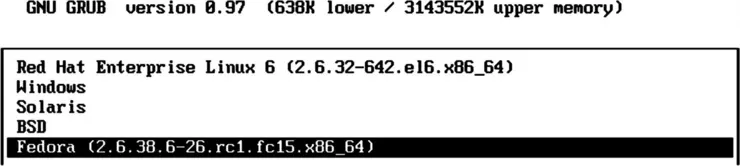

После перезагрузки GRUB покажет упомянутые записи title. См. рисунок 2-76.

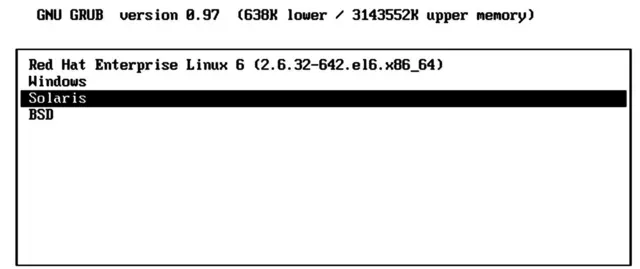

Рисунок 2-76. Экран приветствия GRUB, отображаемый RHEL 6

Если пользователь выберет Windows, он вызовет часть-2 BCD, которая находится в пространстве размером 31 КБ первого основного файла. Это пространство размером 31 КБ также называется volume boot record (загрузочная запись тома) (VBR). Я намеренно пропустил объяснение VBR, поскольку оно излишне создаст путаницу. Итак, в случае с цепной загрузкой Windows просто имейте в виду, что вместо части-1 будет вызываться часть-2. Для тех, кому нужна дополнительная информация о VBR, MBR — это основная загрузочная запись жесткого диска, расположенная в первом секторе жесткого диска. Каждый том (например, раздел) имеет свою собственную загрузочную запись, называемую VBR, в качестве первого сектора раздела. Два названия для двух похожих вещей.

Таким образом, часть-2 BCD вызовет часть-3 BCD, которая находится в первом основном разделе. Она прочитает записи ОС BCD (bcdedit.exe), как показано на рисунке 2-77, и выведет их на экран.

Рисунок 2-77. Записи ОС, отображаемые загрузчиком BCD

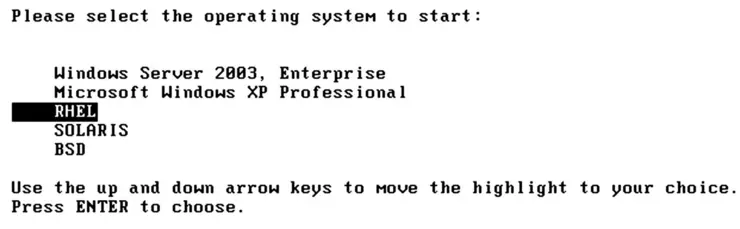

Если пользователь выберет более раннюю версию Windows, как мы видели ранее (во время загрузки Windows 7), он запустит часть-3 NTLDR, которая снова находится в первом основном разделе. Как показано на рисунке 2-78, NTLDR прочитает файл boot.ini с диска C и распечатает записи ОС.

Рисунок 2-78. Записи ОС, отображаемые NTLDR Win2k3

Если пользователь выбирает XP, часть-3 NTLDR знает, где находится ядро XP. Вместо этого пользователь выбирает win2k3, а затем тот же NTLDR загрузит в память ядро win2k3.

Обратитесь к рисунку 2-79, который представляет собой главный экран загрузки, предоставляемый RHEL, если пользователь выбирает OpenSolaris.

Рисунок 2-79. Записи ОС, показанные RHEL

Ниже приведены инструкции, которым будет следовать GRUB:

title Solaris

rootnoverify (hd0,1)

chainloader +1

Итак, часть-3 RHEL GRUB передаст управление загрузчику bootstrap второго основного раздела, но помните, что win2k3 очистил часть-1 OpenSolaris GRUB. Следовательно, как видно на рисунке 2-80, он не сможет загрузиться.

Рисунок 2-80. OpenSolaris не удалось загрузиться

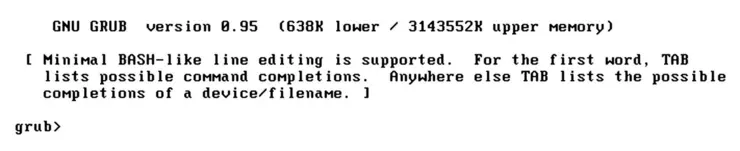

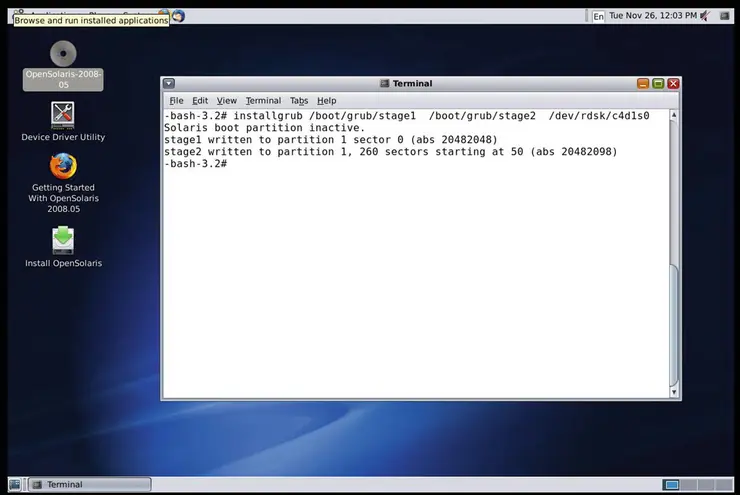

Это означает, что сначала нам нужно исправить загрузчик OpenSolaris. Чтобы это исправить, нам нужно загрузиться с образа Live CD OpenSolaris, который мы использовали для установки OpenSolaris, и после загрузки установить часть-1 и часть-2 (часть-2 не обязательна, но ее можно переустановить) GRUB. с live-диска на зарезервированные 512 байт раздела OpenSolaris + 31 КБ. Команда, которую мы будем использовать, — installgrub. Как следует из названия, команда скопирует часть-1 (этап 1) и часть-2 (этап 2) GRUB из live-образа и поместит их в пространство раздела OpenSolaris размером 512 байт + 31 КБ. На рисунке 2-81 показано действие команды.

# installgrub /boot/grub/stage1 /boot/grub/stage2 /dev/rdsk/c4d0s0

Рисунок 2-81. Команда installgrub

После перезагрузки RHEL снова покажет те же записи ОС (рисунок 2-82), поскольку для RHEL ничего не изменилось.

Рисунок 2-82. Записи ОС, показанные RHEL

Если на этот раз мы выберем OpenSolaris, то часть-3 RHEL GRUB загрузит часть-1 OpenSolaris GRUB из второго раздела. Часть-1 вызовет часть-2 и, в конечном итоге, вызовет часть-3 из фактического раздела OpenSolaris. Третья часть OpenSolaris GRUB будет читать файл /rpool/boot/grub/menu.lst и, как показано на рисунке 2-83, выводить заголовки на экран.

Рисунок 2-83. Записи ОС, показанные OpenSolaris

Если пользователь выберет OpenSolaris, то третья часть OpenSolaris GRUB загрузит ядро из /boot. Если пользователь выбирает Windows, то третья часть OpenSolaris GRUB будет следовать этим инструкциям из /rpool/boot/grub/menu.lst:

title Windows

rootnoverify (hd0,0)

chainloader +1

Теперь мы знаем, что появится на экране (см. рисунок 2-84).

Рисунок 2-84. Записи ОС, показанные в формате BCD

История продолжится, если пользователь выберет более раннюю версию Windows, о которой мы уже говорили. Возвращаясь к исходному списку ОС, на рисунке 2-85 показано, что представлено GRUB RHEL.

Рисунок 2-85. Записи ОС, показанные RHEL

Если пользователь решит загрузить BSD, вы точно знаете, что произойдет. Часть-3 GRUB RHEL будет загружать часть-1 BTX из третьего основного раздела. Часть-1 BTX вызовет часть-2, а часть-2 вызовет часть-3 BTX. В части-3 BTX отобразится экран приветствия, как показано на рисунке 2-86.

Рисунок 2-86. Экран приветствия PC-BSD

После выбора загрузки часть-3 BTX загрузит ядро BSD Unix в память. Итак, все операционные системы, какую бы мы ни установили до сих пор, теперь могут загружаться, и не имеет значения, какой раздел активен. Но можем ли мы взломать загрузчики Windows и заставить их загружать операционные системы Linux и Unix из нашего списка? Да, можем, и это то, что мы сейчас сделаем.

Взлом загрузчиков Windows

На самом деле обмануть загрузчики Windows довольно легко. Как мы видели ранее, загрузчики выполняют цепную загрузку; например, часть-1 вызывает часть-2 своего загрузчика и так далее. Чтобы понять суть, давайте возьмем в качестве примера BSD. Часть-1 BCD вызывает свою часть-2 BCD, но если мы укажем части-1 BCD загрузить по цепочке часть-1 RHEL, то часть-1 RHEL запустится и в конечном итоге будет следовать своей собственной последовательности загрузки. Часть-1 GRUB (RHEL) вызовет часть-2 GRUB и в конечном итоге загрузит часть-3 GRUB, поскольку адрес блока части-3 жестко запрограммирован в части-2. Это означает, что как только запустится часть-1 любого загрузчика, он начнет следовать своей собственной последовательности загрузки, и мы воспользуемся этим поведением.

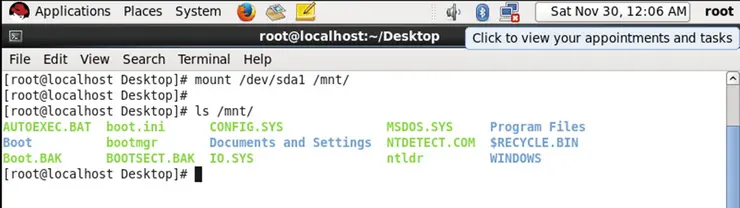

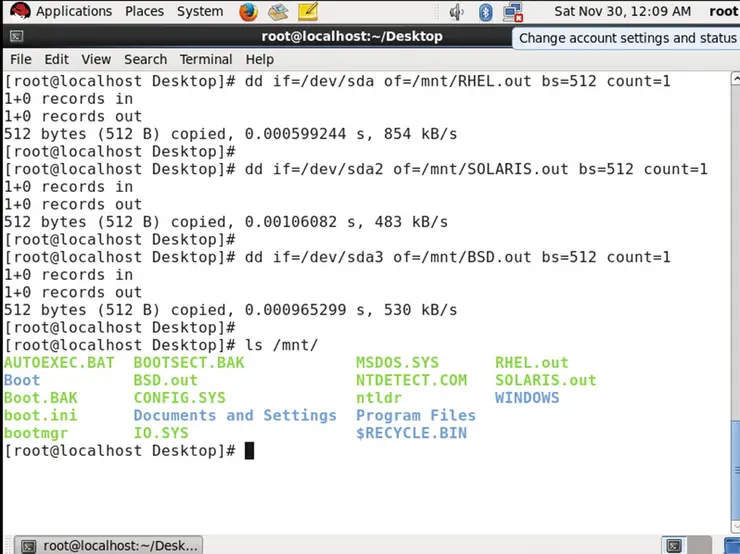

Для этого нам нужно получить часть-1 каждого загрузчика, отличного от Windows, и поместить ее в файловую систему Windows. Итак, файловая система может быть FAT32 или NTFS. Очевидно, что размещение части-1 каждого загрузчика, отличного от Windows, в первом основном разделе имеет наибольшее преимущество, поскольку каждая операционная система Windows устанавливает свои соответствующие загрузчики в первый основной раздел. Итак, с помощью команды dd мы скопируем первые 512 байт (даже первых 440 байт достаточно) каждой ОС, отличной от Windows, и поместим их в раздел XP. Давайте смонтируем первый основной раздел, как показано на рисунке 2-87.

Рисунок 2-87. Команда монтирования

Давайте скопируем первые 512 байт и поместим их в раздел sda1. Для этого обратитесь к рисунку 2-88.

Рисунок 2-88. Передача первых 512 байт в первый основной раздел

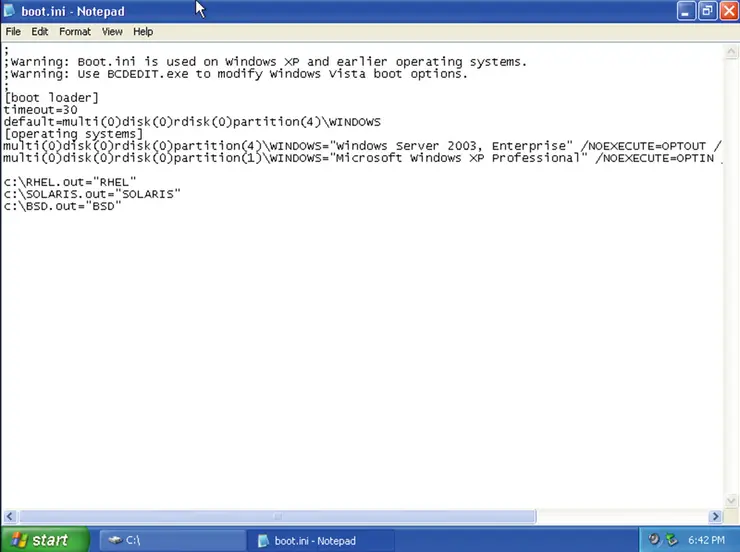

Теперь мы снова загрузимся в XP и, как показано на рисунке 2-89, добавим записи файлов части-1 в файл boot.ini. Файл boot.ini читается обоими загрузчиками Windows: BCD и NTLDR Win2k3.

Рисунок 2-89. Добавление записей в файл boot.ini

Ниже приведены записи, которые мы добавили:

c:\RHEL.out="RHEL"

c:\SOLARIS.out="SOLARIS"

c:\BSD.out="BSD"

Как и в случае с файлом grub.conf, все, что написано в двойных кавычках в boot.ini, будет считаться заголовком записи ОС. Теперь давайте перезагрузим систему и выберем запись ОС Windows из списка ОС RHEL (см. рисунок 2-90).

Рисунок 2-90. Список ОС, отображаемый RHEL

Как мы дошли до этого экрана, легко понять.

-

Система переходит сначала к BIOS, затем к POST, затем к BIOS, затем к первым 512 байтам, а затем к загрузке bootstrap (часть-1) RHEL (GRUB).

-

Затем следует часть-1 GRUB, которая переходит к части-2 GRUB, которая переходит к части-3 GRUB, которая переходит в

/boot/grub.conf, где печатаются заголовки ОС. -

Пользователь выбирает Windows, поэтому далее идет часть-1 BCD из первого основного раздела, а затем часть-2 BCD.

-

Наконец, процесс переходит к части-3, затем к файлу

bcd.exe, который читает файлboot.ini, и все, что записано в двойных кавычках, будет напечатано на экране.

Список ОС показан на Рисунке 2-91.

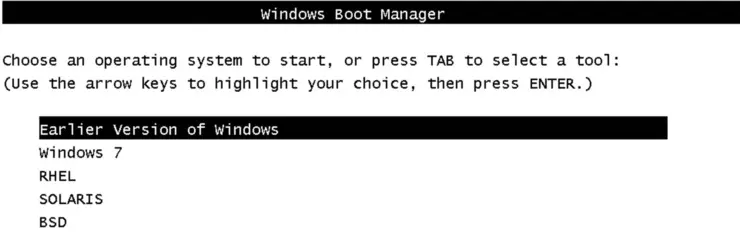

Рисунок 2-91. Записи ОС, отображаемые в Windows 7 (BCD)

Если пользователь выберет более раннюю версию Windows, то часть-3 BCD вызовет часть-3 NTLDR Win2k3. NTLDR снова прочитает файл boot.ini и распечатает список ОС, как показано на рисунке 2-92.

Рисунок 2-92. Записи ОС, отображаемые NTLDR Win2k3

Если пользователь выбирает OpenSolaris, то часть-3 NTLDR запустит файл SOLARIS.out из C: (первый основной раздел). Файл SOLARIS.out — это не что иное, как часть-1 загрузчика OpenSolaris из второго раздела. Часть-1 загрузчика OpenSolaris будет вызывать часть-2 и, в конечном итоге, часть-3 GRUB. Часть-3 прочитает файл menu.lst и распечатает список ОС (рисунок 2-93).

Рисунок 2-93. Записи ОС, отображаемые OpenSolaris GRUB

Если пользователь снова выберет Windows, то часть-3 OpenSolaris вызовет часть-2 BCD из первого основного раздела (rootnoverify (hd0,0)). (Часть-2 BCD будет находиться в разделе VBR первого основного раздела. Мы не будем рассматривать VBR в этой книге.) Часть-2 BCD будет вызывать часть-3 BCD. Она прочитает записи ОС через bcdedit.exe и из boot.ini и распечатает записи ОС. Записи ОС, напечатанные на экране, показаны на рисунке 2-94.

Рисунок 2-94. Записи ОС, отображаемые в Windows 7 (BCD)

Вот как мы создали цикл загрузчика (см. рисунок 2-95 и рисунок 2-96).

Рисунок 2-95. Для загрузки выбрана запись RHEL

Рисунок 2-96. Записи ОС, показанные в GRUB RHEL

Как вы можете видеть, Linux загружает Windows, Linux загружает Unix, Unix загружает Windows, Windows загружает Windows и Windows загружает Linux, но одной вещи все еще не хватает, а именно Linux загружает Linux. Для этого мы установим последнюю ОС из нашего списка — Fedora 15.

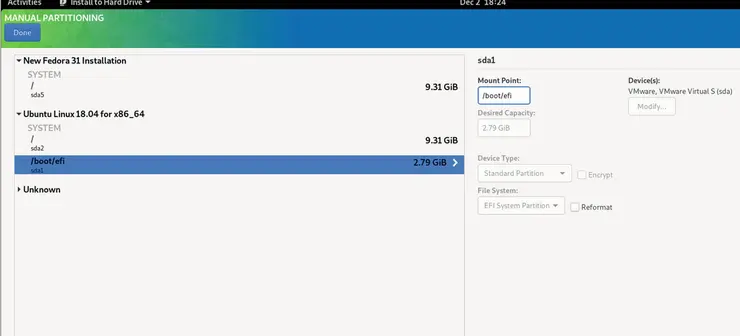

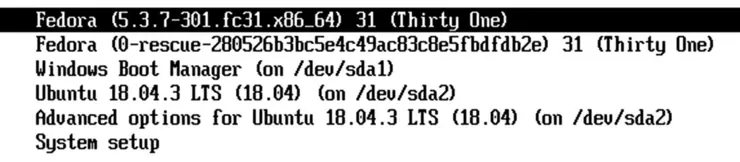

Fedora 15

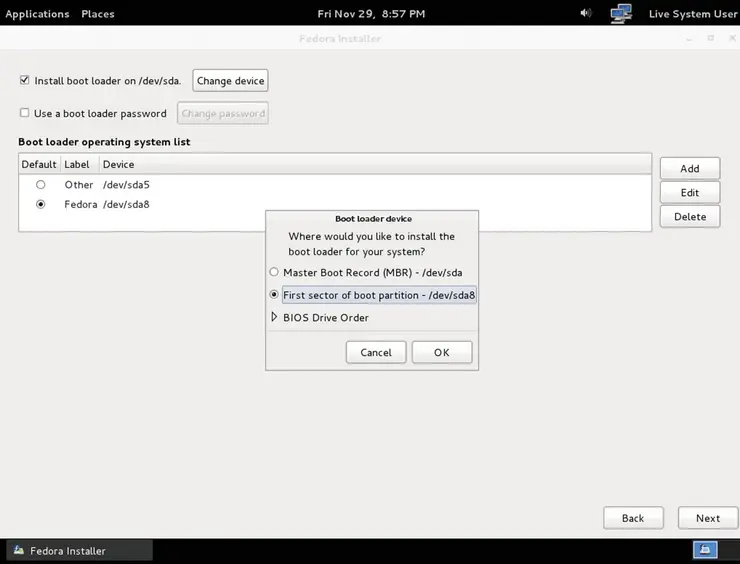

Как показано на рисунке 2-97, мы устанавливаем Fedora 15 на sda8.

Рисунок 2-97. Установщик Fedora

По умолчанию Fedora попытается установить свой загрузчик на первую основной раздел, но если мы разрешим это, нам снова нужно будет добавить запись обо всех остальных ОС в ее grub.conf. Вместо этого мы будем следовать другому подходу. Мы установим загрузчик Fedora (GRUB) в отдельный раздел (sda8) вместо sda1. См. рисунок 2-98.

Рисунок 2-98. Выбор устройства загрузчика

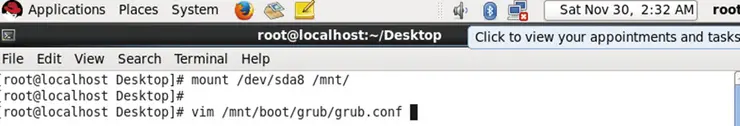

Это означает, что после перезагрузки Fedora никак не сможет загрузиться, поскольку GRUB RHEL не знает об этой новой ОС, поэтому нам нужно добавить запись Fedora в grub.conf RHEL. Для этого давайте смонтируем sda8, как показано на рисунке 2-99.

Рисунок 2-99. Монтирование раздела Fedora

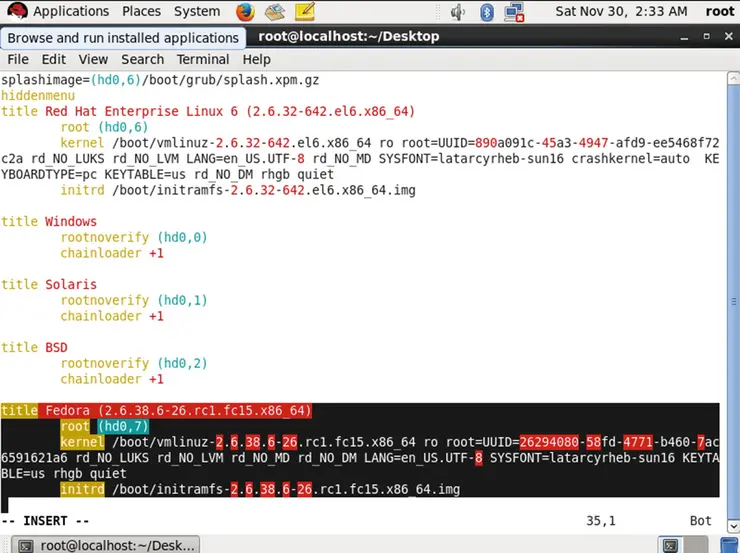

Скопируйте записи Fedora (см. рисунок 2-100) из файла grub.conf Fedora GRUB: /mnt/boot/grub/grub.conf.

Рисунок 2-100. Файл grub.conf Fedora 15

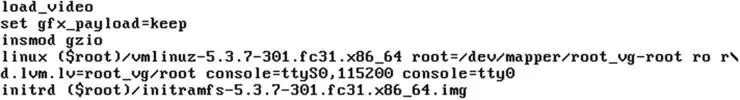

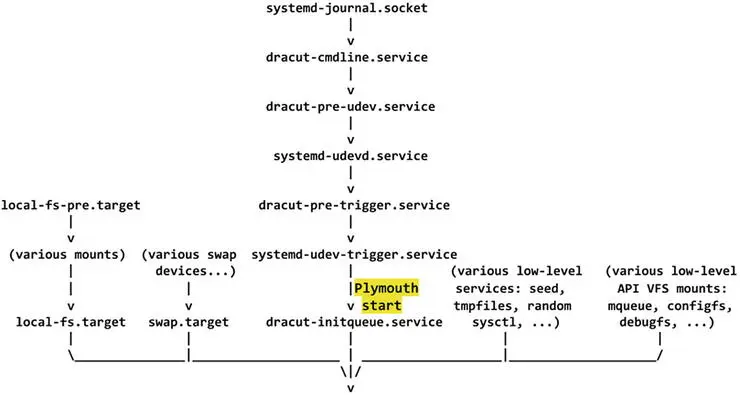

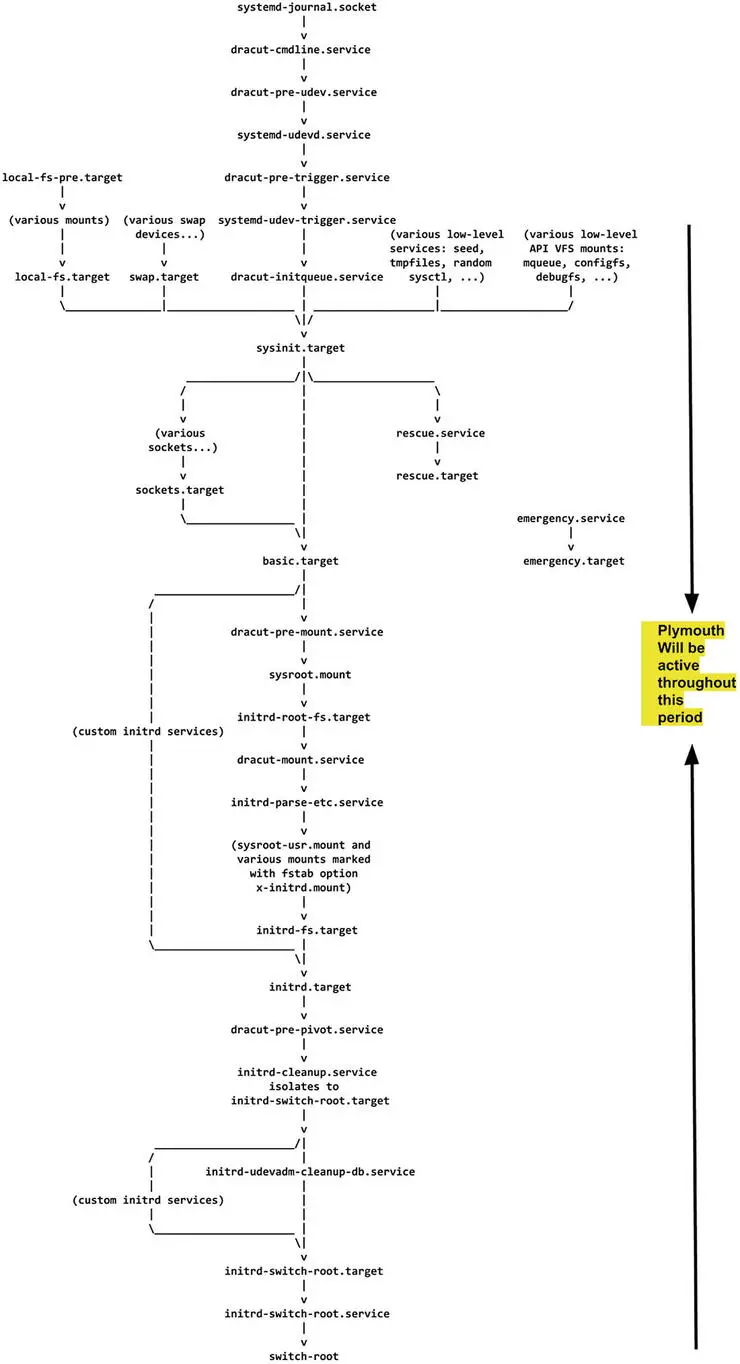

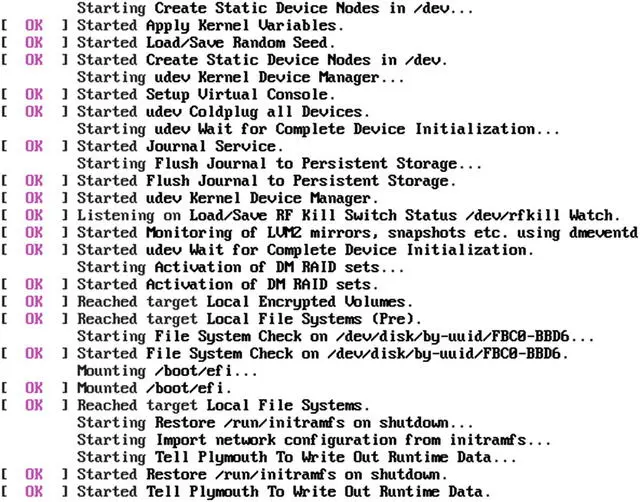

Записи простые. Всякий раз, когда вызывается часть-3 Fedora, она загружает ядро Fedora из /boot/vmlinuz-2.6.38.6-26.rc1.fc15.x86_64 в память. После этого она загружает initramfs из /boot/initramfs-2.6.38.6-26.rc1.fc15.x86_64.img в память.

На рисунке 2-101 показан файл /boot/grub/grub.conf RHEL после копирования записи Fedora из /mnt/boot/grub/grub.conf.

Рисунок 2-101. Файл grub.conf RHEL

После перезагрузки мы получим запись Fedora (рисунок 2-102).

Рисунок 2-102. Записи ОС, показанные RHEL

Когда пользователь выбирает Fedora для загрузки, согласно записи в файле grub.conf RHEL, часть-3 GRUB RHEL загружает ядро из восьмого раздела (sda8 Fedora), а также загружает initramfs из того же места (мы будем поговорим об initramfs в главе 5), и загрузчик исчезнет.

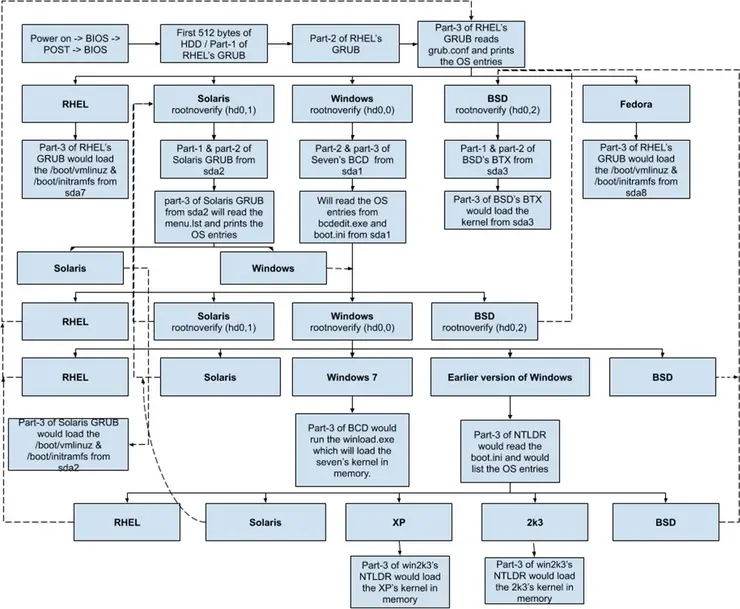

Полная блок-схема

На рисунке 2-103 показана полная блок-схема каждой установленной нами ОС.

Рисунок 2-103. Полная блок-схема всех операционных систем

Надеюсь, теперь вы понимаете, как загрузчики загружают операционные системы в системах на базе BIOS. Теперь пришло время разобраться с новой прошивкой — Unified Extensible Firmware Interface (единый интерфейс расширяемой прошивки) (UEFI).

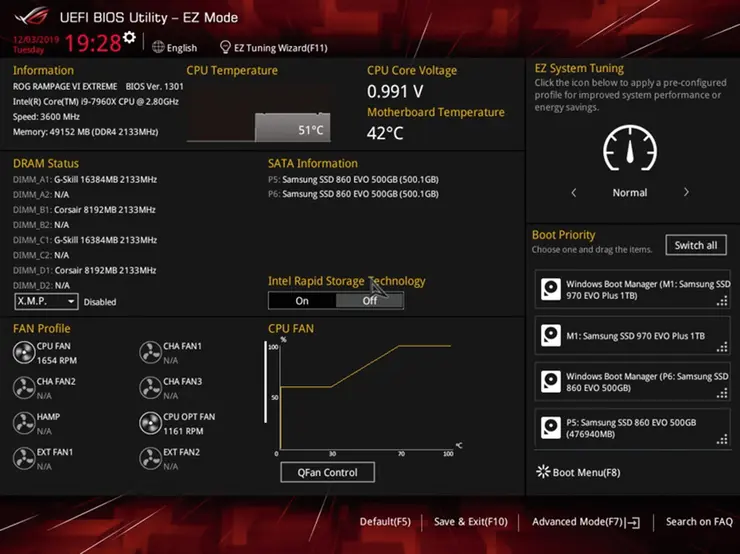

Единый интерфейс расширяемой прошивки (UEFI)

Вот ограничения BIOS, которые вы наблюдали до сих пор:

У вас может быть только четыре основных раздела.

BIOS не может прочитать логические разделы.

BIOS какой-то тупой; он просто переходит к первому сектору вашего жесткого диска.

Максимальный размер раздела в системе на базе BIOS составляет 2,2 ТБ.

Почему у него такие ограничения? Прошивка BIOS была разработана в 1982 году для IBM PC-5150 (рисунок 2-104), который раньше имел следующую конфигурацию:

CPU = 8088 — 16bit x86 processor

Memory = upto 256KB max

OS = MS-DOS

Рисунок 2-104. IBM PC-5150

Как видите, BIOS для этого ПК был разработан много лет назад. За это время операционные системы выросли с гибких дисков до дисков NVME и от текстового режима до блестящих графических интерфейсов. Аппаратные устройства перешли от драйверов к технологии Plug and Play, но BIOS остался прежним: изначально он имел 16-битный набор инструкций, а на более поздних этапах начал использовать 32-битный набор инструкций. Сегодня у нас есть 64-битные процессоры, но BIOS по-прежнему состоит из 32-битных инструкций. В силу некоторых исторических причин мы до сих пор не обновили BIOS до 64-битной версии. Когда все работает, зачем что-то переписывать? Так или иначе, эту философию приняла компьютерная индустрия. В то время как процессор перешел с 16-битного (8088) на 64-битный (i9) режим, BIOS оставался либо 16-битным, либо 32-битным, поскольку на момент ранних этапов загрузки не было необходимости иметь 64-битный процессор, и именно поэтому у нас есть режимы процессора (реальный, защищенный и длинный).

В реальном режиме процессор будет ограничен 16 битами. В этом режиме будут запускаться программы, подобные старому BIOS, которые содержат 16-разрядные инструкции. Эти программы не могут работать ни в каком другом режиме. Позже CPU переключится из реального режима в защищенный. Защищенный режим составляет 32 бита, и в наши дни программы, такие как BIOS, с 32-битным набором инструкций, будут работать в этом режиме, а позже CPU будет переведен в длинный режим, который составляет 64 бита. Помните, что эти режимы не реализуются процессором; скорее, они реализуются прошивкой, такой как BIOS. Это означает, что если мы удалим тот же CPU из системы с включенным реальным режимом и поместим его в систему, у которой нет реального режима, то тот же CPU сразу запустится в защищенном режиме. Мы еще поговорим об этих режимах в главе 4.

Поскольку BIOS работает в защищенном режиме, доступное для BIOS адресное пространство составляет всего 4 ГБ. Если в системе 20 ГБ памяти, BIOS сможет адресовать только до 4 ГБ. Хотя в системе установлен 64-битный процессор i9, BIOS все равно сможет использовать только 32 его бита. Из-за этих аппаратных проблем BIOS имеет ограничения.

Ограничения BIOS

Вот некоторые ограничения BIOS:

-

BIOS может перейти только к первому сектору размером 512 байт.

- MBR (PT) размером 64 байта является частью первого загрузочного сектора. Если мы увеличим размер MBR, он выйдет за рамки 512 байт; следовательно, мы не можем увеличить размер MBR, поэтому BIOS может предоставить только четыре основных раздела.

-

BIOS не может генерировать хорошую графику/графический интерфейс.

-

Это общее утверждение, которое используется в сравнении с UEFI. Некоторые производители BIOS реализовали веб-браузеры вне ОС, но такие реализации редко можно увидеть на обычном настольном оборудовании.

-

Кроме того, в Phoenix некоторые реализации BIOS содержат драйвер FAT32, с помощью которого удается отображать иконки внутри настроек BIOS.

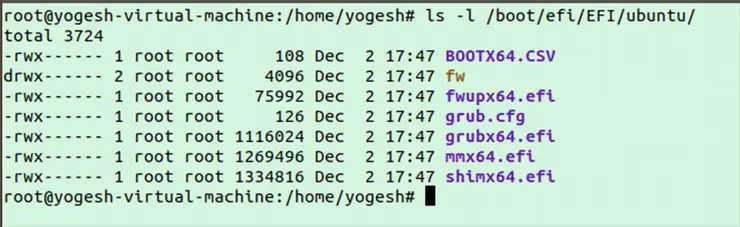

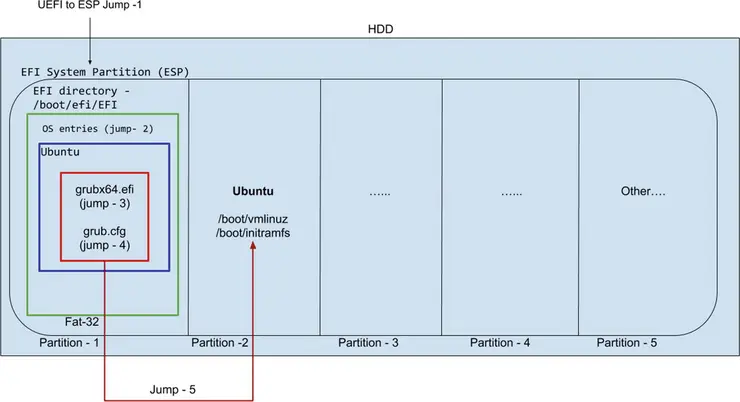

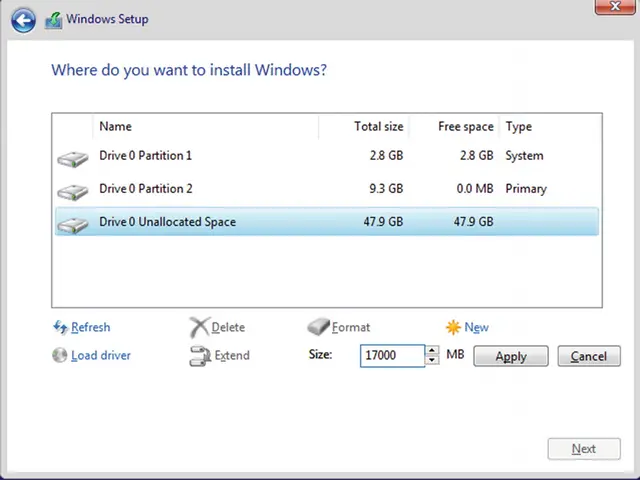

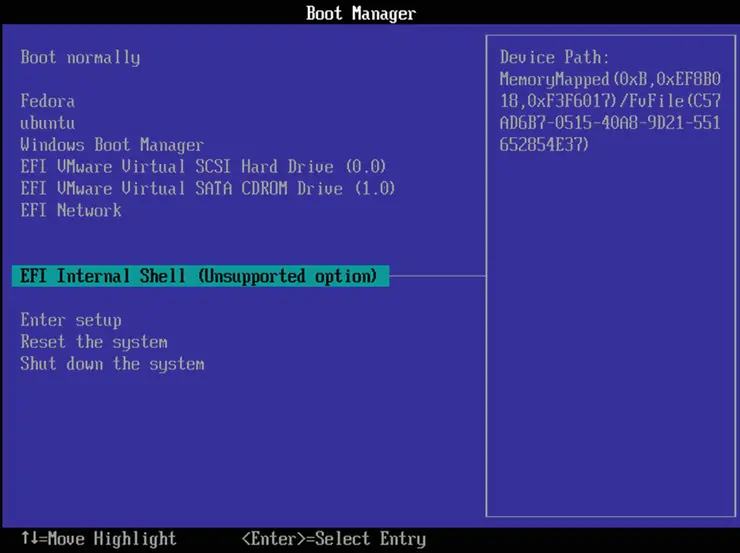

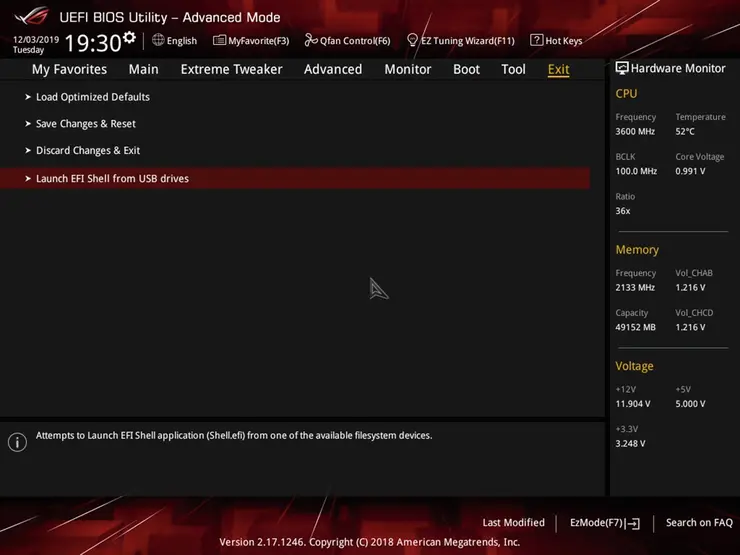

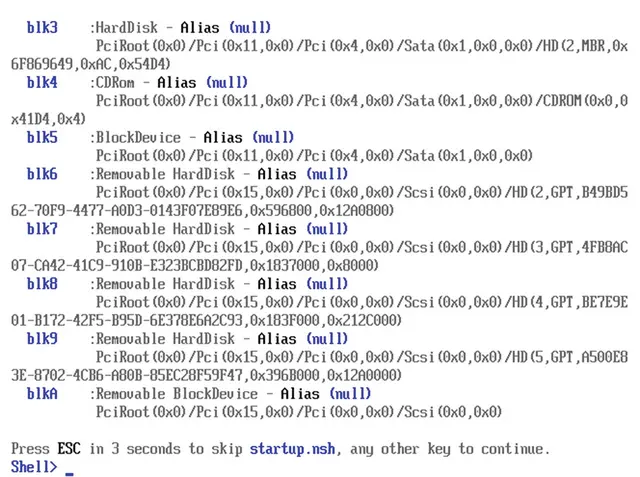

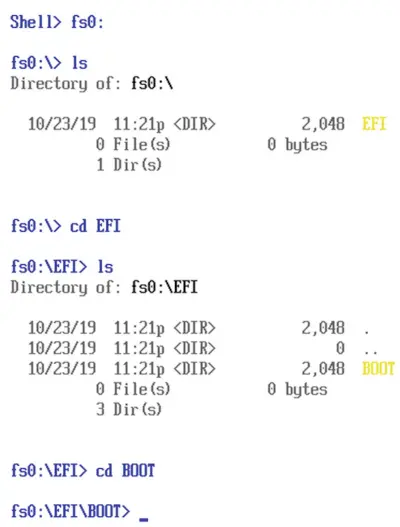

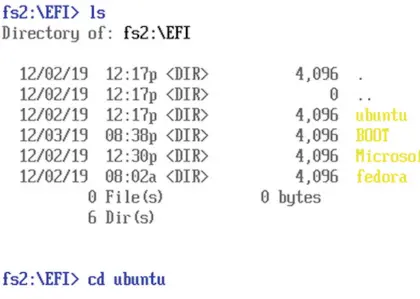

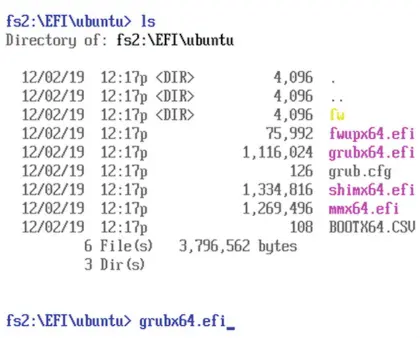

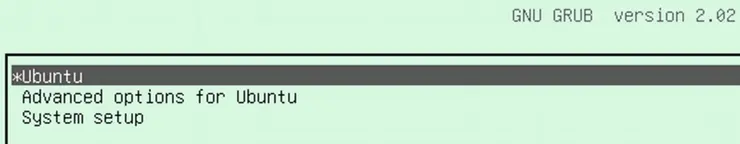

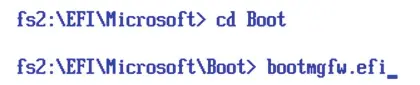

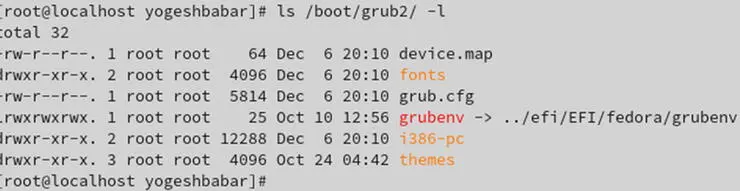

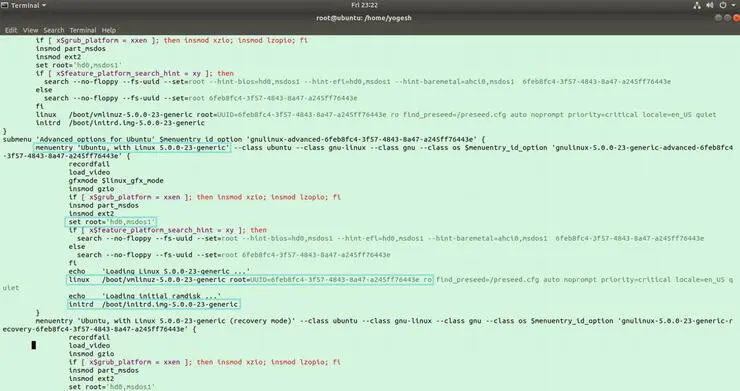

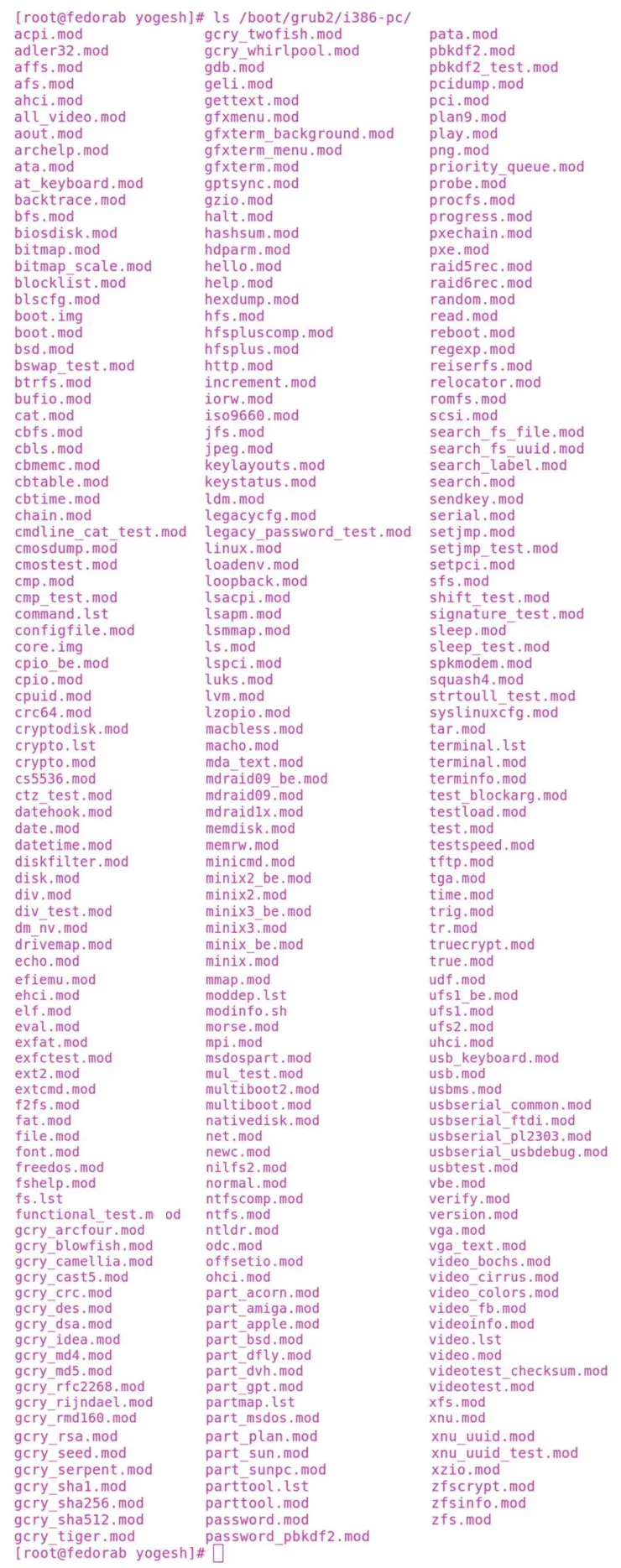

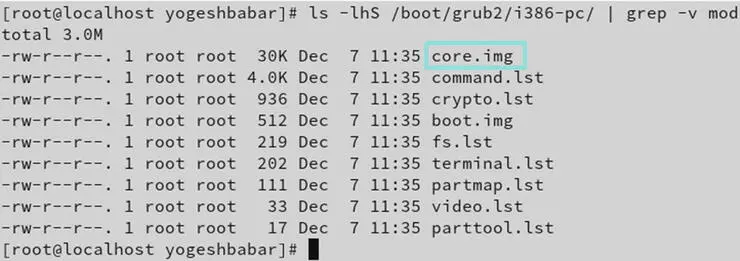

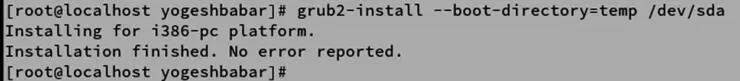

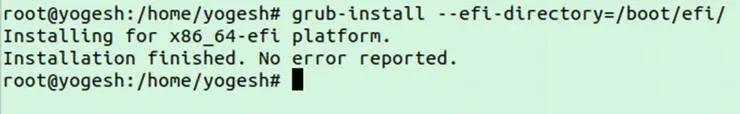

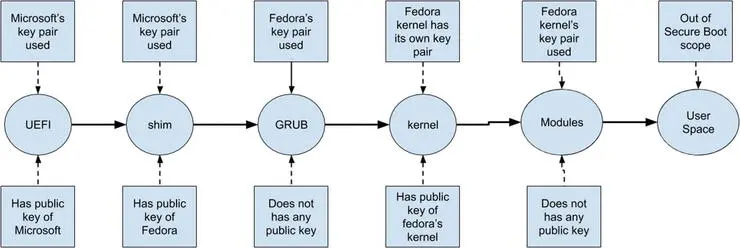

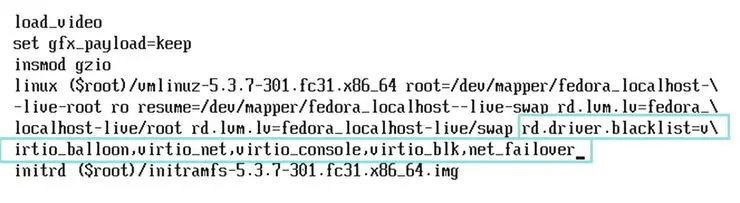

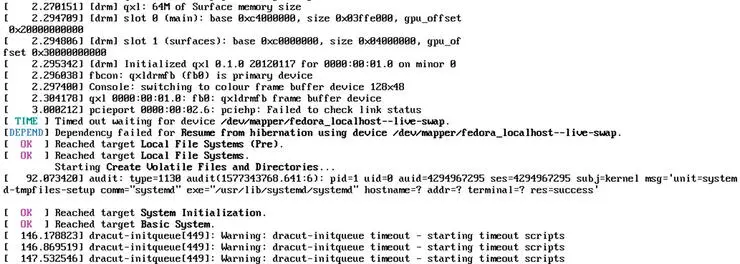

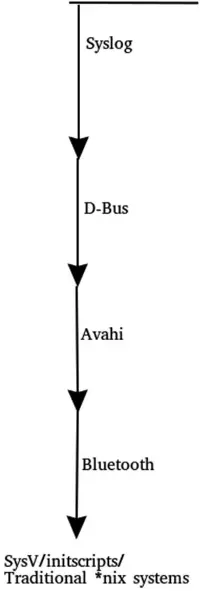

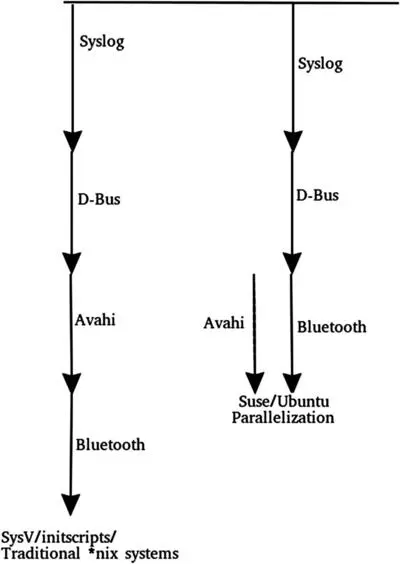

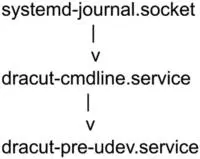

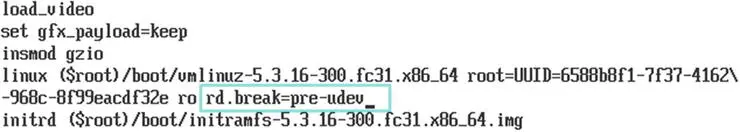

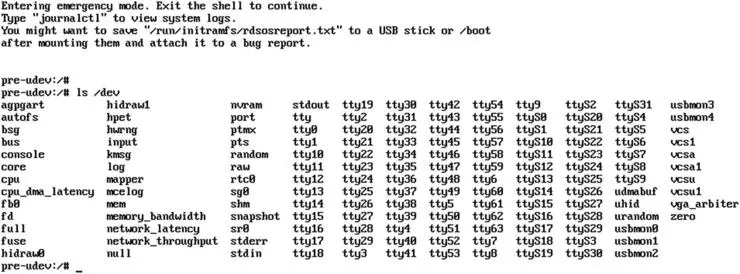

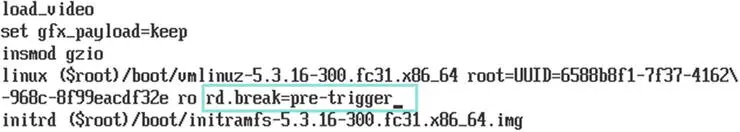

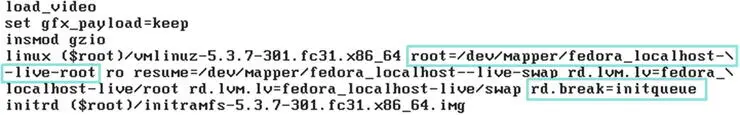

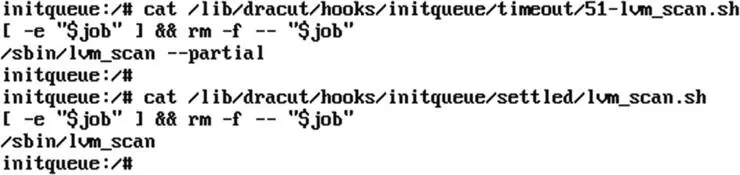

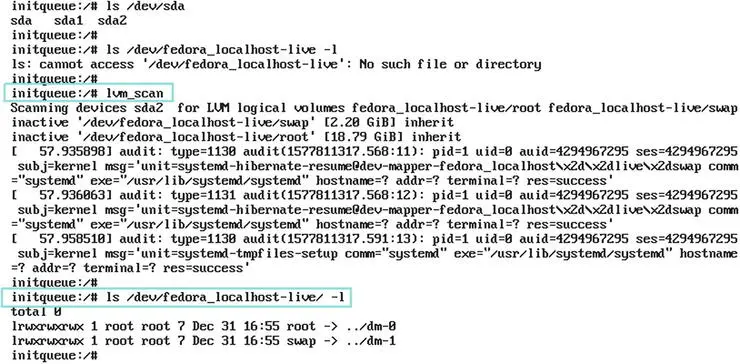

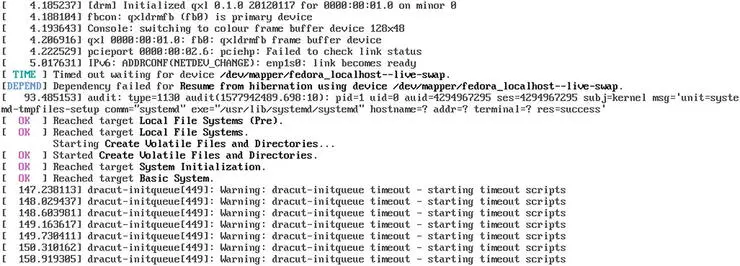

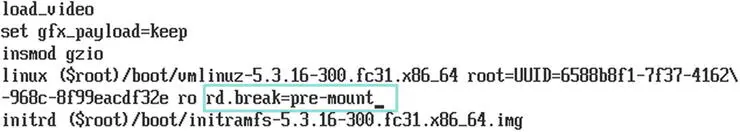

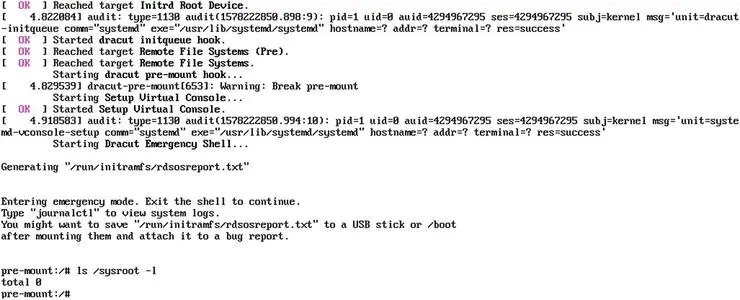

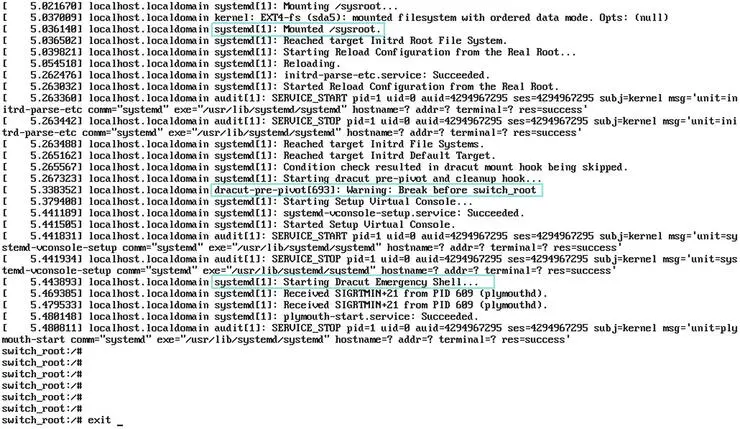

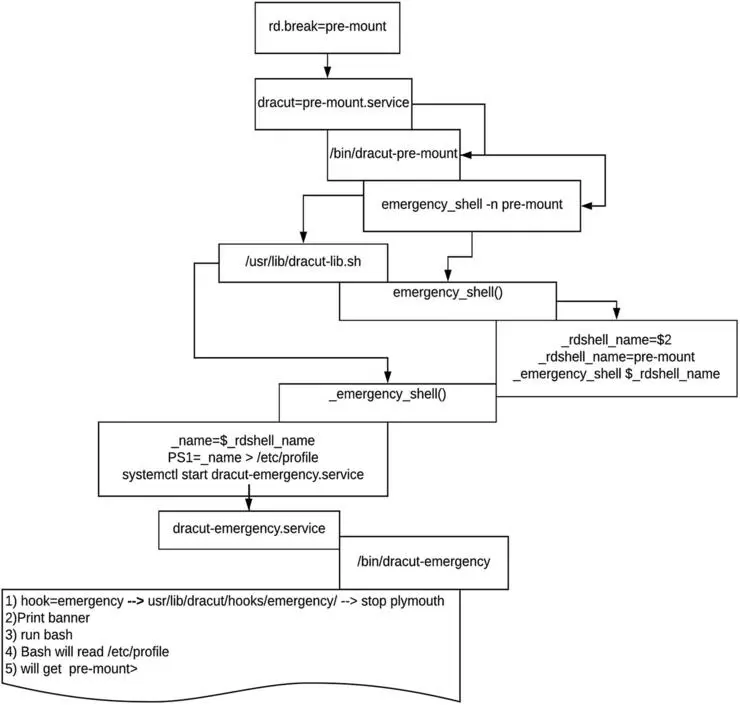

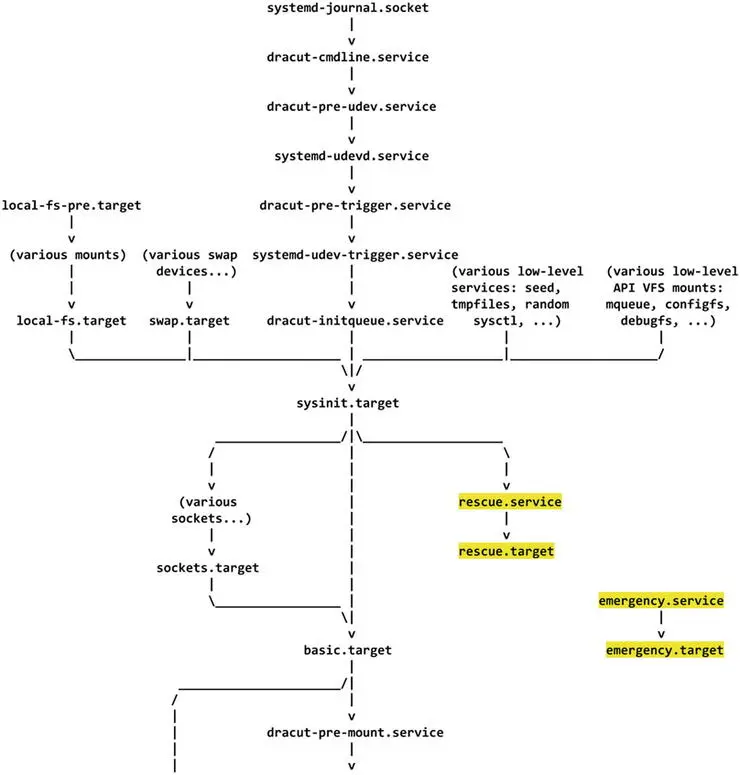

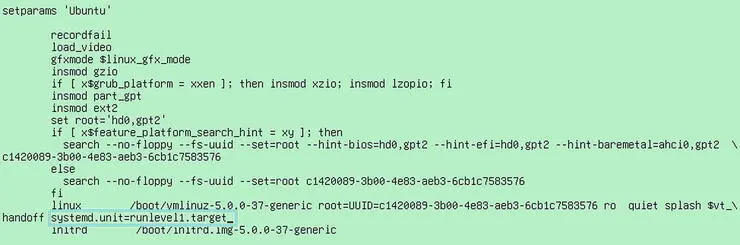

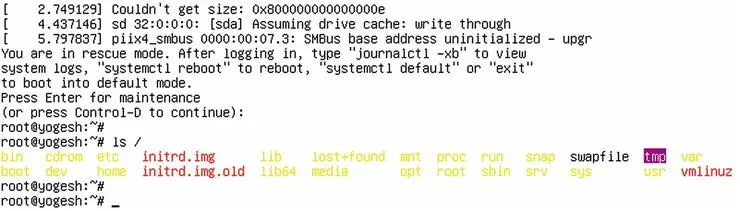

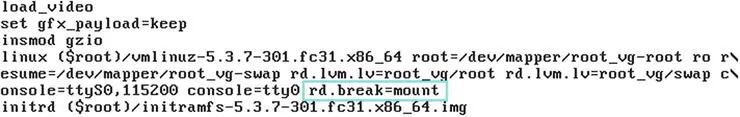

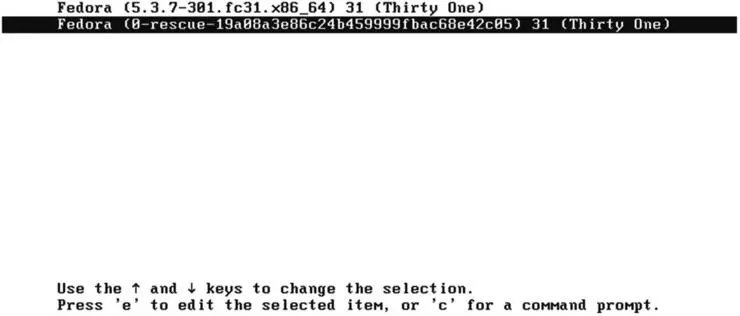

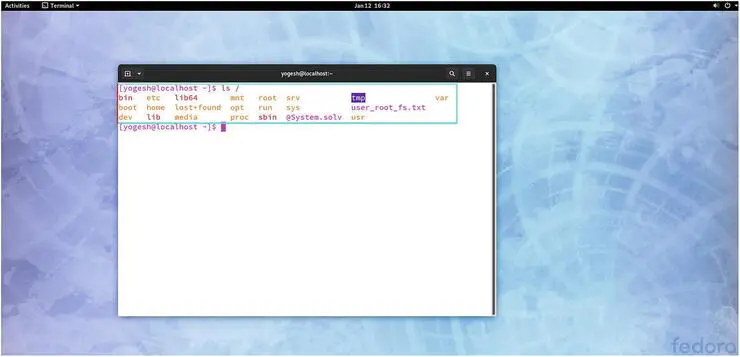

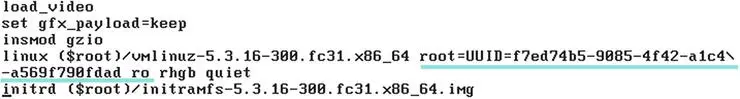

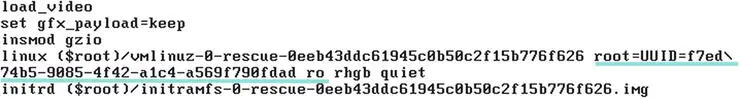

-